分析謊言

分析偏差

馬克吐溫有爭議地說過類似的話,“謊言分為三種:謊言,該死的謊言和 分析“

我們理所當然地認為分析為我們提供了有用的、可操作的見解。 我們常常沒有意識到,我們自己和其他人的偏見如何影響即使是最複雜的軟件和系統給出的答案。 有時,我們可能會被不誠實地操縱,但更常見的是,潛入我們的分析中的可能是微妙和無意識的偏見。 有偏見的分析背後的動機是多方面的。 有時,我們期望從科學中獲得的公正結果受到以下因素的影響:1) 數據呈現方式的微妙選擇,2) 不一致或不具代表性的數據,3) 人工智能係統的訓練方式,4) 研究人員或其他嘗試的無知、無能講故事,5)分析本身。

演示文稿有偏見

有些謊言比其他謊言更容易被發現。 當您知道要尋找什麼時,您可能更容易檢測到潛在的 誤導性圖形和圖表。

至少有 誤導性顯示數據的五種方法:1)顯示有限的數據集,2)。 顯示不相關的相關性,3) 不准確地顯示數據,4) 非常規地顯示數據,或 5)。 顯示數據過於簡單。

顯示有限的數據集

限制數據或手動選擇數據的非隨機部分通常會講述與大局不一致的故事。 不良抽樣或櫻桃採摘是指分析師使用非代表性樣本來代表更大的群體。

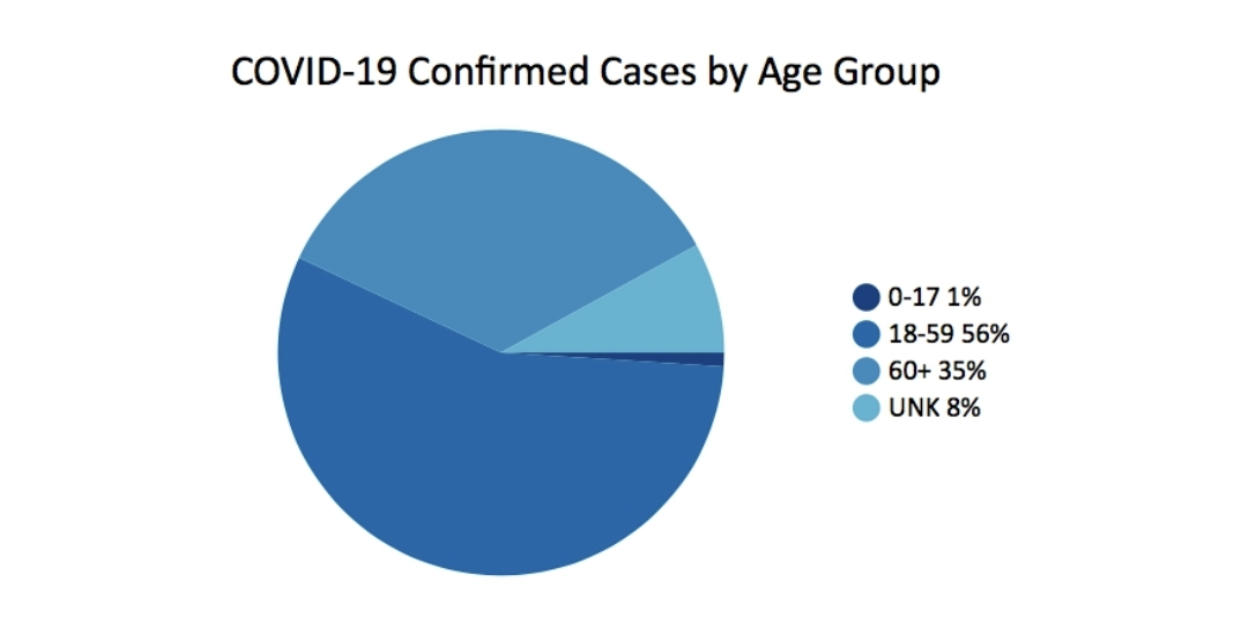

在3月2020, 佐治亞州公共衛生部 將此圖表作為其每日狀態報告的一部分發布。 它實際上提出的問題比它回答的要多。

缺少的一件事是上下文。 例如,了解每個年齡組的人口百分比是有幫助的。 看起來簡單的餅圖的另一個問題是年齡組不均衡。 0-17 有 18 年,18-59 有 42 年,60+ 是開放式的,但大約有 40 年。 僅根據這張圖表得出的結論是,大多數病例發生在 18-59 歲年齡段。 60 歲以上的年齡組受 COVID 病例的影響似乎較輕。 但這不是故事的全部。

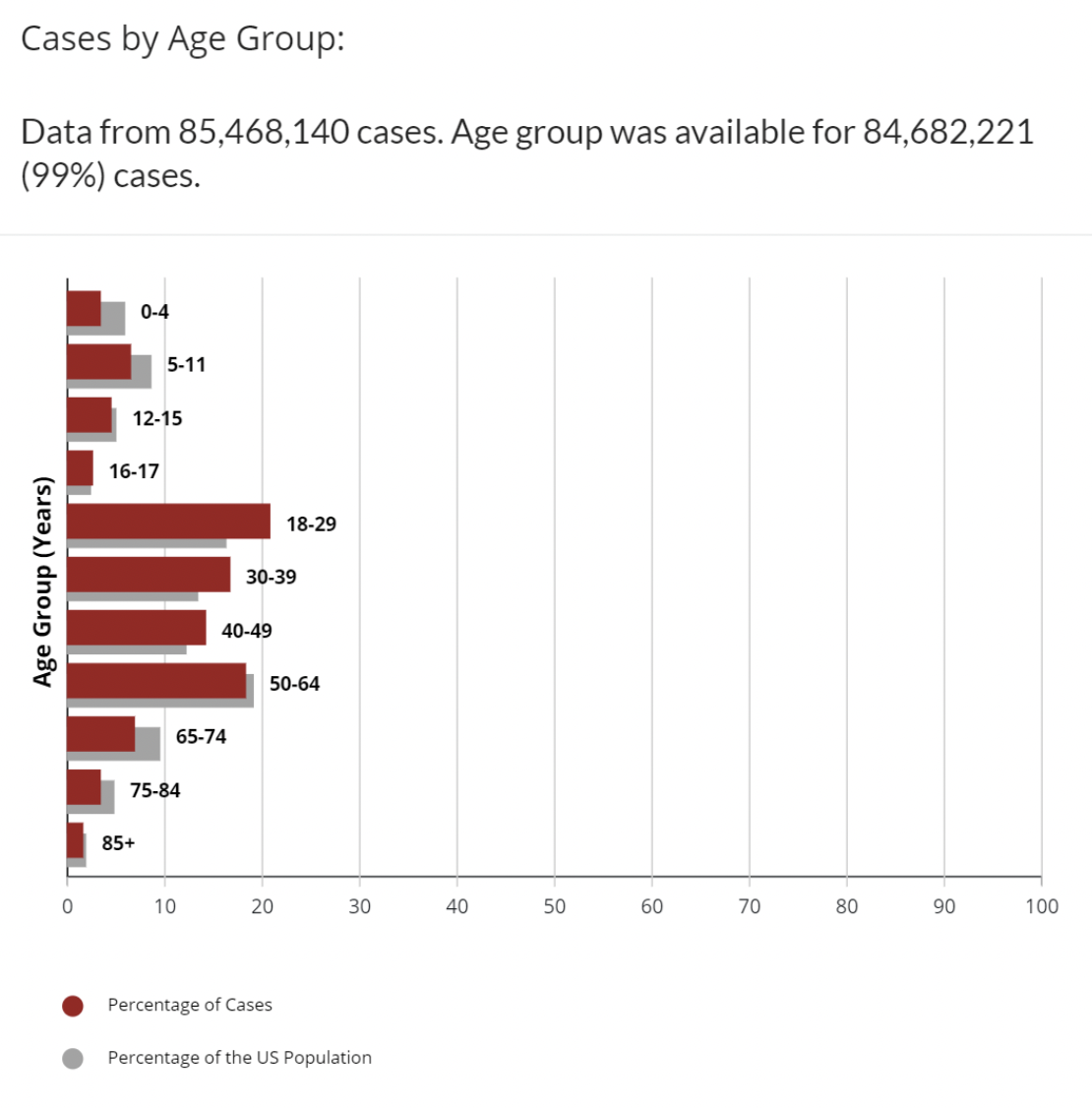

為了比較,這個不同的數據集在 疾病預防控制中心網站 按年齡組繪製 COVID 病例圖表,並附上每個年齡範圍內的美國人口百分比的附加數據。

這個更好。 我們有更多的背景。 我們可以看到,18-29、30-39、40-49 年齡段的病例比例都高於該年齡段在人口中的比例。 仍然有一些不平衡的年齡組。 為什麼 16-17 歲是一個單獨的年齡組? 但這還不是故事的全部,但專家們撰寫的專欄文章、預測和授權的內容遠不止於此。 顯然,對於 COVID,除了年齡之外,還有許多變量會影響被視為陽性病例:疫苗接種狀態、檢測的可用性、檢測的次數、合併症等等。 案件數量本身提供了不完整的畫面。 大多數專家還會查看死亡人數或每 100,000 人中的死亡百分比或病死率,以了解 COVID 如何影響每個年齡組。

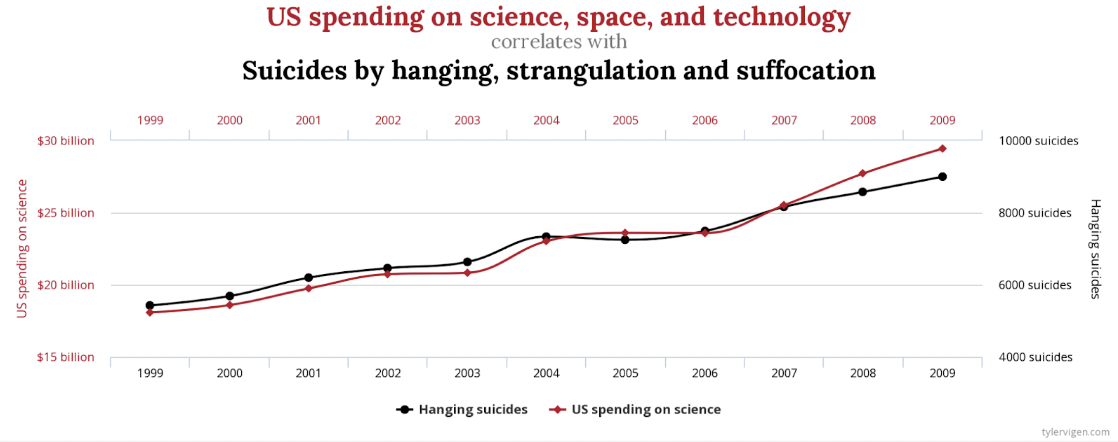

顯示不相關的相關性

顯然,有一個 相關性強 美國在科學、空間和技術上的支出與因絞刑、勒死和窒息而自殺的人數之間存在差異。 相關性為 99.79%,幾乎完美匹配。

但是,誰會提出這些以某種方式相關,或者一個導致另一個? 還有其他不那麼極端的例子,但同樣虛假。 斯克里普斯全國拼字比賽中獲獎的字母與被毒蜘蛛殺死的人數之間也存在類似的強相關性。 巧合? 你決定。

繪製這些數據的另一種可能較少誤導的方法是在兩個 Y 軸上都包含零。

顯示數據不准確

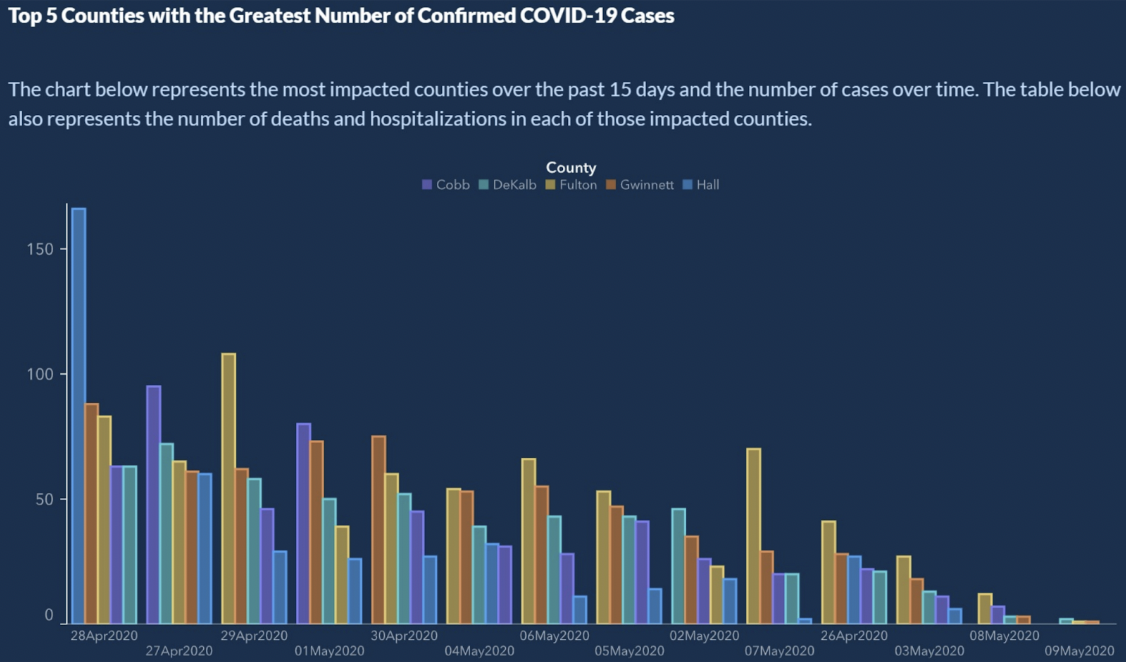

起 如何糟糕地顯示數據,美國佐治亞州公佈了確診 COVID-5 病例數最多的前 19 個縣。

看起來合法,對吧? 確診的 COVID-19 病例明顯呈下降趨勢。 你能讀懂X軸嗎? X 軸代表時間。 通常,日期將從左到右增加。 在這裡,我們在 X 軸上看到了一點時間旅行:

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 ...

等待? 什麼? X 軸不按時間順序排序。 因此,儘管趨勢看起來不錯,但我們無法得出任何結論。 如果對日期進行排序,則病例數的條形圖顯示的鋸齒形圖案比任何趨勢都多。

這裡的簡單解決方法是按照日曆的方式對日期進行排序。

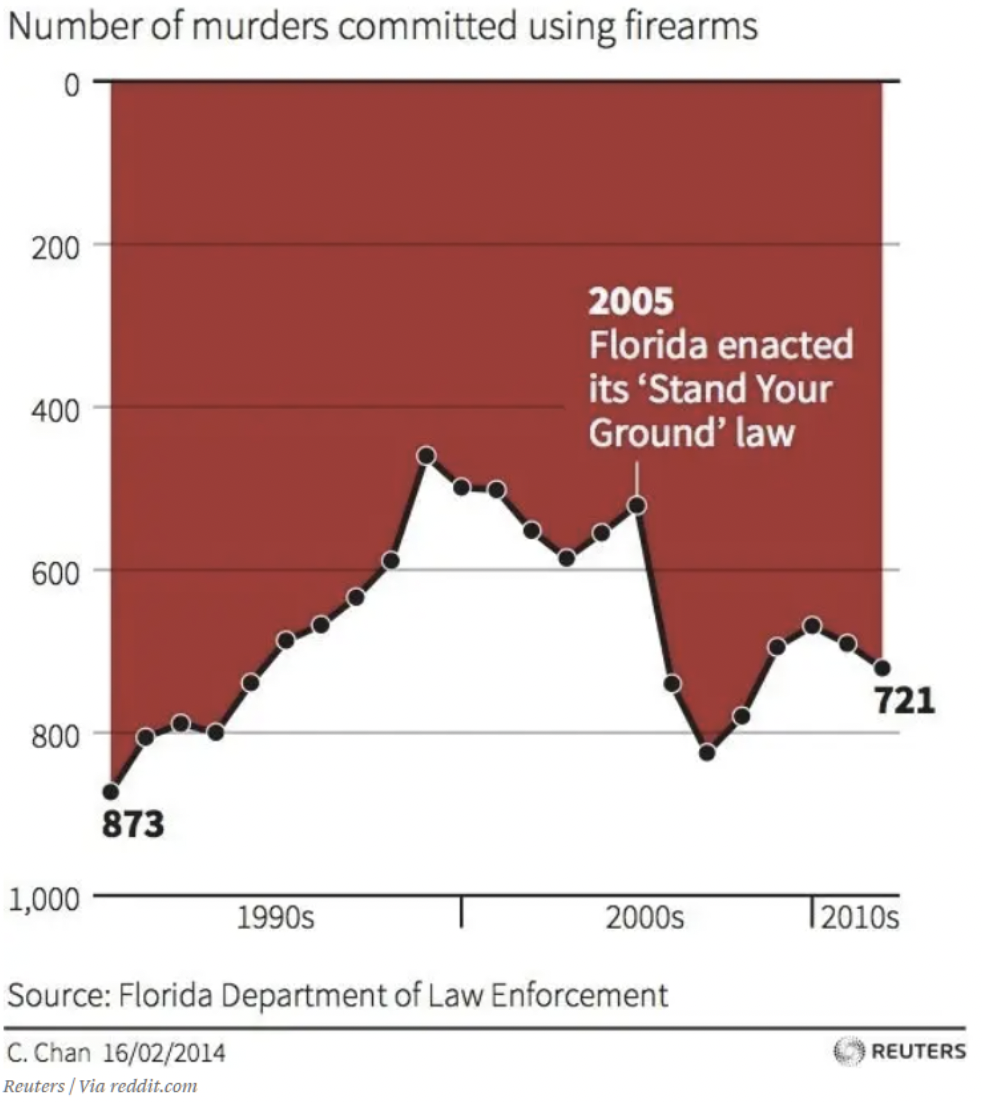

非常規地顯示數據

我們都很忙。 我們的大腦已經教會我們根據世界上一貫的假設做出快速判斷。 例如,我見過的每張圖都顯示 x 軸和 y 軸在零或最低值處相遇。 簡單地看一下這張圖表,你能得出什麼關於佛羅里達州的影響的結論? “堅持你的基本法。”? 我很慚愧地承認這一點,但這張圖表起初愚弄了我。 您的眼睛很容易被圖形中間的文字和箭頭所吸引。 在這張圖表中向下是向上的。 這可能不是謊言——數據就在那裡。 但是,我不得不認為這是為了欺騙。 如果您還沒有看到它,y 軸上的零位於頂部。 因此,隨著數據呈下降趨勢,這意味著更多的死亡。 這張圖表顯示,使用槍支的謀殺案數量 增加 從 2005 年以後的趨勢來看 向下.

顯示過度簡化的數據

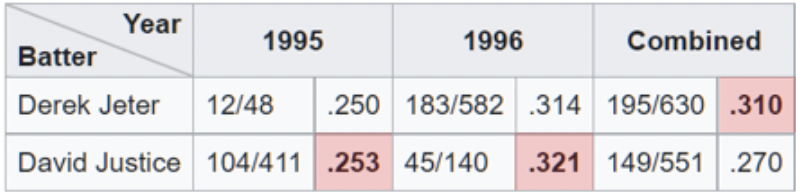

當分析師利用辛普森悖論時,可以看到數據過度簡化的一個例子。 當聚合數據似乎顯示出與將其分成子集時不同的結論時,就會出現這種現象。 在查看高級匯總百分比時,很容易陷入這個陷阱。 辛普森悖論在工作中最清晰的例證之一與 擊球率.

在這裡,我們看到 Derek Jeter 在 1995 和 1996 賽季的整體打擊率高於 David Justice。 當我們意識到正義在這兩年的平均擊球率上都超過了傑特時,悖論就出現了。 如果您仔細觀察,當您意識到 Jeter 在 4 年的平均擊球次數(分母)增加了大約 1996 倍時,這是有道理的,而 007 年的平均擊球次數降低了 1996。而正義隊的擊球次數大約是 10 倍,僅為 . 003 高於 1995 年的平均值。

演示文稿看似簡單,但辛普森悖論有意或無意地導致了錯誤的結論。 最近,新聞和社交媒體上出現了與疫苗和 COVID 死亡率相關的辛普森悖論的例子。 一 圖表 顯示了比較 10-59 歲人群接種疫苗和未接種疫苗的死亡率的折線圖。 該圖表表明,未接種疫苗的人始終具有較低的死亡率。 這裡發生了什麼?

這個問題類似於我們在擊球率上看到的問題。 在這種情況下,分母是每個年齡組的人數。 該圖結合了具有不同結果的組。 如果我們分別查看年齡較大的 50-59 歲組,我們會發現接種疫苗的情況更好。 同樣,如果我們查看 10-49,我們也會看到接種疫苗的票價更好。 矛盾的是,當查看組合時,未接種疫苗的結果似乎更糟。 通過這種方式,您可以使用數據為相反的論點提出理由。

數據有偏差

數據不能總是可信的。 即使在科學界,超過三分之一的接受調查的研究人員承認 “可疑的研究實踐。” 另一個 研究欺詐偵探 說:“數據中的欺詐行為很可能比我們實際發現的要多得多——表格、折線圖、排序數據[——]。 坐在廚房餐桌旁的任何人都可以在電子表格中輸入一些數字,並製作出看起來令人信服的折線圖。”

首先 例子 看起來有人這樣做了。 我並不是說這是欺詐,但作為一項調查,它只是不會生成任何有助於做出明智決策的數據。 該調查似乎詢問了受訪者對加油站咖啡或其他相關時事的看法。

- 高超

- 大

- 非常好

我裁剪了 Twitter 帖子以刪除對有罪方的引用,但這是調查最終結果的實際完整圖表。 像這樣的調查並不少見。 顯然,任何由響應產生的數據創建的圖表都將顯示有問題的咖啡不容錯過。

問題是,如果您接受了此調查,但沒有找到符合您想法的答案,您將跳過該調查。 這可能是如何創建不可信數據的一個極端示例。 然而,糟糕的調查設計會導致更少的回應,而那些做出回應的人只有一個意見,這只是程度問題。 數據有偏差。

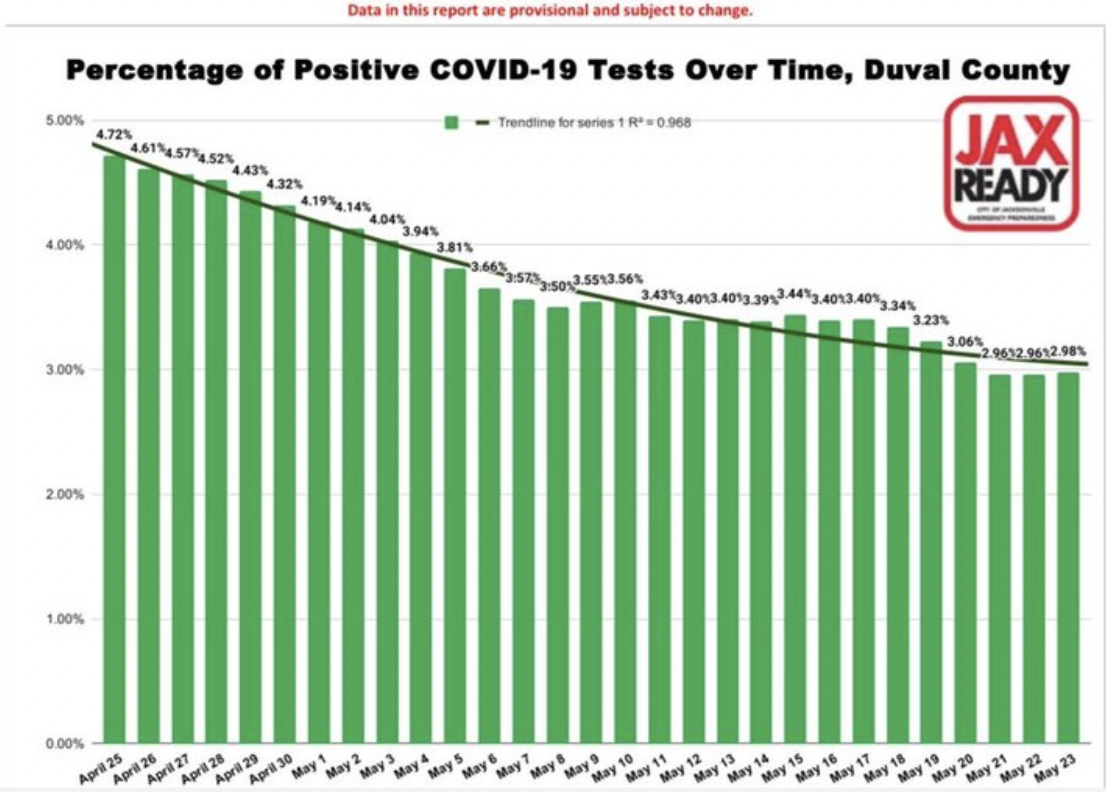

第二個數據偏差示例來自“最糟糕的 COVID 19 誤導性圖表“

同樣,這是微妙的,並不完全明顯。 條形圖顯示佛羅里達州一個縣的 COVID-19 陽性病例百分比隨時間平穩下降——幾乎太平穩了。 您可以輕鬆得出病例正在下降的結論。 太好了,可視化準確地代表了數據。 問題出在數據上。 所以,這是一個更陰險的偏見,因為你看不到它。 它已融入數據。 您需要問的問題包括,誰在接受測試? 換句話說,分母是什麼,或者我們正在查看的人口百分比。 假設是整個人口,或者至少是一個有代表性的樣本。

然而,在此期間,在這個縣,測試只對有限數量的人進行。 他們必須有類似 COVID 的症狀,或者最近去過熱點列表中的國家。 此外,混淆結果的事實是,每個陽性測試都被計算在內,每個陰性測試都被計算在內。 通常,當一個人檢測呈陽性時,他們會在病毒走完後再次檢測,結果呈陰性。 因此,從某種意義上說,對於每個正面案例,都有一個負面測試案例將其抵消。 絕大多數測試都是陰性的,每個人的陰性測試都被計算在內。 您可以看到數據是如何有偏差的,並且對於做出決策並不是特別有用。

AI 輸入和訓練是有偏見的

人工智能至少有兩種方式可以導致有偏見的結果:從有偏見的數據開始,或者使用有偏見的算法來處理有效數據。

有偏輸入

我們中的許多人的印像是,可以信任人工智能來處理數字、應用其算法並對數據進行可靠的分析。 人工智能只有經過訓練才能變得聰明。 如果訓練它的數據不完善,結果或結論也將不可信。 與上述調查偏差的情況類似,可以通過多種方式獲取數據 偏 在機器學習中:。

- 樣本偏差——訓練數據集不代表整個人群。

- 排除偏差 – 有時看似異常值實際上是有效的,或者,我們在哪些地方劃清界限(郵政編碼、日期等)。

- 測量偏差 – 慣例是始終從彎液面的中心和底部進行測量,例如,當測量容量瓶或試管中的液體時(汞除外)。

- 回憶偏差——當研究依賴於參與者的記憶時。

- 觀察者偏見——科學家和所有人類一樣,更傾向於看到他們期望看到的東西。

- 性別歧視和種族主義偏見——性別或種族的比例可能過高或過低。

- 關聯偏見——數據強化了刻板印象

為了讓人工智能返回可靠的結果,它的訓練數據需要代表現實世界。 正如我們在之前的博客文章中所討論的,數據準備與任何其他數據項目一樣至關重要。 不可靠的數據會給機器學習系統上一堂錯誤的課,並會導致錯誤的結論。 也就是說,“所有數據都是有偏見的。 這不是妄想症。 這是事實。” – Sanjiv M. Narayan 博士,斯坦福大學醫學院。

使用有偏見的數據進行訓練導致了許多值得注意的人工智能失敗。 (例子 這裡 和 這裡研究 這裡..)

有偏算法

算法是一組接受輸入並創建輸出以回答業務問題的規則。 它們通常是定義明確的決策樹。 算法感覺就像黑匣子。 沒有人知道它們是如何工作的,通常,甚至是 使用它們的公司. 哦,它們通常是專有的。 它們神秘而復雜的性質是有偏見的算法如此陰險的原因之一。 .

考慮醫學、人力資源或金融領域的人工智能算法,其中考慮了種族因素。 如果種族是一個因素,那麼算法就不可能是種族盲目的。 這不是理論上的。 在現實世界中使用人工智能發現了類似的問題 招聘, 拼車, 申請貸款秒,並 腎移植.

底線是,如果你的數據或算法不好,比無用更糟糕,它們可能是危險的。 有這樣一個“算法審計。” 目標是幫助組織識別與算法相關的潛在風險,因為它與公平、偏見和歧視有關。 別處, Facebook 正在使用 AI 來對抗 AI 中的偏見。

人們有偏見

我們在等式的兩邊都有人。 人們正在準備分析,人們正在接收信息。 有研究人員,也有讀者。 在任何通信中,傳輸或接收都可能出現問題。

以天氣為例。 “有可能下雨”是什麼意思? 首先,氣象學家說有可能下雨是什麼意思? 根據美國政府 國家氣象局,下雨的機會,或者他們所謂的降水概率 (PoP),是天氣預報中最不為人所知的元素之一。 它確實有一個標准定義:“降水概率只是在指定時間段內給定預測區域的給定區域降水量增加 0.01 英寸 [原文如此] 的統計概率。” “給定區域”是預測區域,或 broad投擲區。 這意味著官方的降水概率取決於該地區某處會下雨的信心以及該地區將被弄濕的百分比。 換句話說,如果氣象學家確信預測區域會下雨(置信度 = 100%),那麼 PoP 代表該區域將下雨的部分。

巴黎街; 下雨天,Gustave Caillebotte (1848-1894) 芝加哥藝術學院公共領域

下雨的機會取決於信心和麵積。 我不知道。 我懷疑其他人也不知道。 大約 75% 的人口不准確理解 PoP 是如何計算的,或者它的含義是什麼。 那麼,我們是否被愚弄了,或者,這是一個認知問題。 我們稱之為降水感知。 我們責怪天氣預報員嗎? 公平地說,有一些 混亂 在天氣預報員中也是如此。 在一個 調查,接受調查的氣象學家中有 43% 表示 PoP 的定義幾乎沒有一致性。

分析本身是有偏見的

在五個影響因素中,分析本身可能是最令人驚訝的。 在導致發表評論論文的科學研究中,通常假設一個理論,定義測試假設的方法,收集數據,然後分析數據。 已完成的分析類型及其完成方式在如何影響結論方面被低估了。 在一個 紙 今年早些時候(2022 年 XNUMX 月)發表在《國際癌症雜誌》上,作者評估了隨機對照試驗和回顧性觀察研究的結果。 他們的研究結果得出結論,

通過在比較有效性研究中改變分析選擇,我們產生了相反的結果。 我們的結果表明,一些回顧性觀察研究可能會發現一種治療方法可以改善患者的預後,而另一項類似的研究可能會發現它沒有,這只是基於分析選擇。

過去,在閱讀科學期刊文章時,如果您和我一樣,您可能會認為結果或結論都是關於數據的。 現在看來,結果,或者說最初的假設是被證實還是被反駁,也可能取決於分析的方法。

另一個 研究 發現了類似的結果。 文章, 許多分析師,一個數據集:使分析選擇的變化如何影響結果變得透明, 描述了他們如何將相同的數據集提供給 29 個不同的團隊進行分析。 數據分析通常被視為一個嚴格的、定義明確的過程,它會導致一個單一的結論。

儘管有方法學家的抗議,但很容易忽視這樣一個事實,即結果可能取決於所選擇的分析策略,而這些策略本身就充滿了理論、假設和選擇點。 在許多情況下,有許多合理(和許多不合理)的方法來評估與研究問題相關的數據。

研究人員對數據進行了眾包分析,得出的結論是,所有研究都包括主觀決定——包括使用哪種類型的分析——這可能會影響研究的最終結果。

另一個人的推薦 研究員 誰分析了上述研究,在使用單篇論文進行決策或得出結論時要謹慎。

解決分析中的偏見

這只是一個警示故事。 知識可以保護我們免受詐騙。 掃描儀可能用來欺騙我們的方法越多,我們就越不可能被扒手的誤導或龐氏騙局的流暢談話所吸引。 因此,理解和識別影響我們分析的潛在偏見也是如此。 如果我們意識到潛在的影響,我們或許能夠更好地呈現故事並最終做出更好的決策。