Analytics Løgn

Analysens skævhed

Mark Twain sagde diskutabelt noget i retning af: "Der er tre slags løgne: løgne, forbandede løgne og analytics".

Vi tager for givet, at analyser giver os brugbare, handlingsrettede indsigter. Hvad vi ofte ikke er klar over er, hvordan vores egne og andres fordomme påvirker de svar, vi får af selv de mest sofistikerede software og systemer. Nogle gange kan vi blive manipuleret uærligt, men mere almindeligt kan det være subtile og ubevidste skævheder, der kryber ind i vores analyser. Motivationen bag biased analytics er mangefold. Nogle gange er de upartiske resultater, vi forventer fra videnskaben, påvirket af 1) subtile valg i, hvordan data præsenteres, 2) inkonsistente eller ikke-repræsentative data, 3) hvordan AI-systemer trænes, 4) uvidenhed, inkompetence hos forskere eller andre, der prøver at fortælle historien, 5) selve analysen.

Præsentationen er partisk

Nogle af løgnene er nemmere at få øje på end andre. Når du ved, hvad du skal kigge efter, kan du lettere opdage potentielt vildledende grafer og diagrammer.

Der er mindst fem måder at vise data på vildledende: 1) Vis et begrænset datasæt, 2). Vis ikke-relaterede korrelationer, 3) Vis data unøjagtigt, 4) Vis data ukonventionelt, eller 5). Vis data for forenklet.

Vis et begrænset datasæt

Begrænsning af data eller håndvalg af en ikke-tilfældig del af dataene kan ofte fortælle en historie, der ikke stemmer overens med det store billede. Dårlig prøveudtagning eller kirsebærplukning er, når analytikeren bruger en ikke-repræsentativ prøve til at repræsentere en større gruppe.

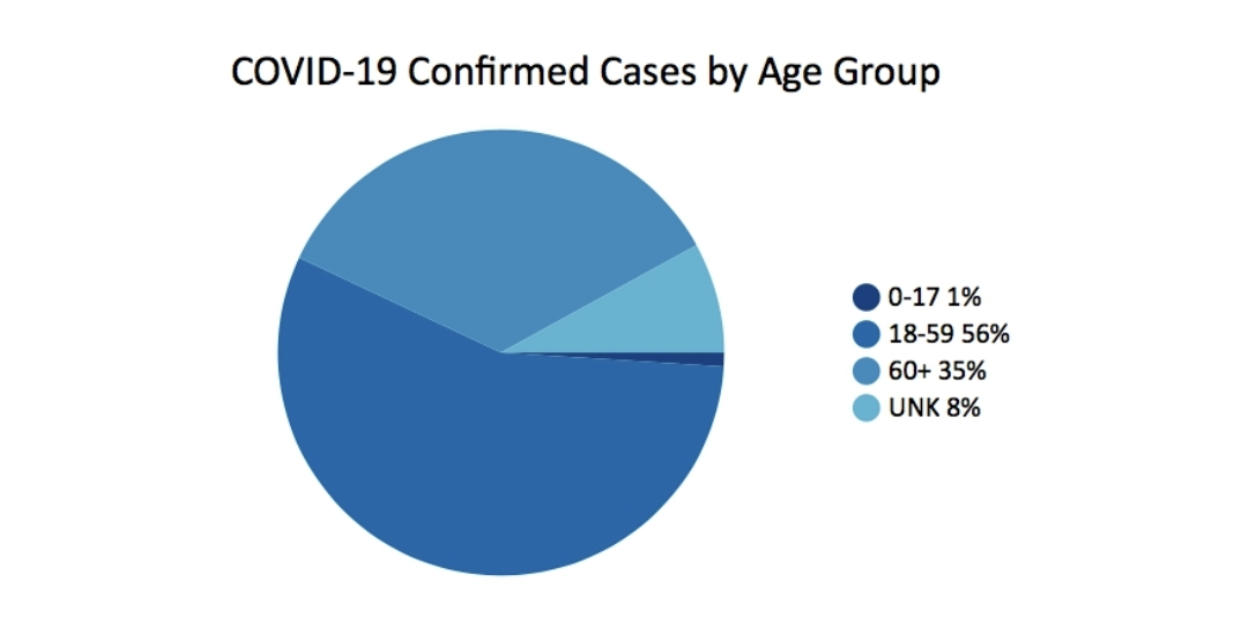

I marts 2020, Georgias Department of Public Health offentliggjort dette diagram som en del af sin daglige statusrapport. Det rejser faktisk flere spørgsmål, end det besvarer.

En af de ting, der mangler, er kontekst. For eksempel ville det være nyttigt at vide, hvor stor en procentdel af befolkningen er for hver aldersgruppe. Et andet problem med det enkelt udseende cirkeldiagram er de ujævne aldersgrupper. 0-17 har 18 år, 18-59 har 42, 60+ er åbent, men har omkring 40 år. Konklusionen, alene givet dette diagram, er, at størstedelen af tilfældene er i aldersgruppen 18-59 år. Den 60+-årige ser ud til at være mindre hårdt ramt af COVID-tilfælde. Men dette er ikke hele historien.

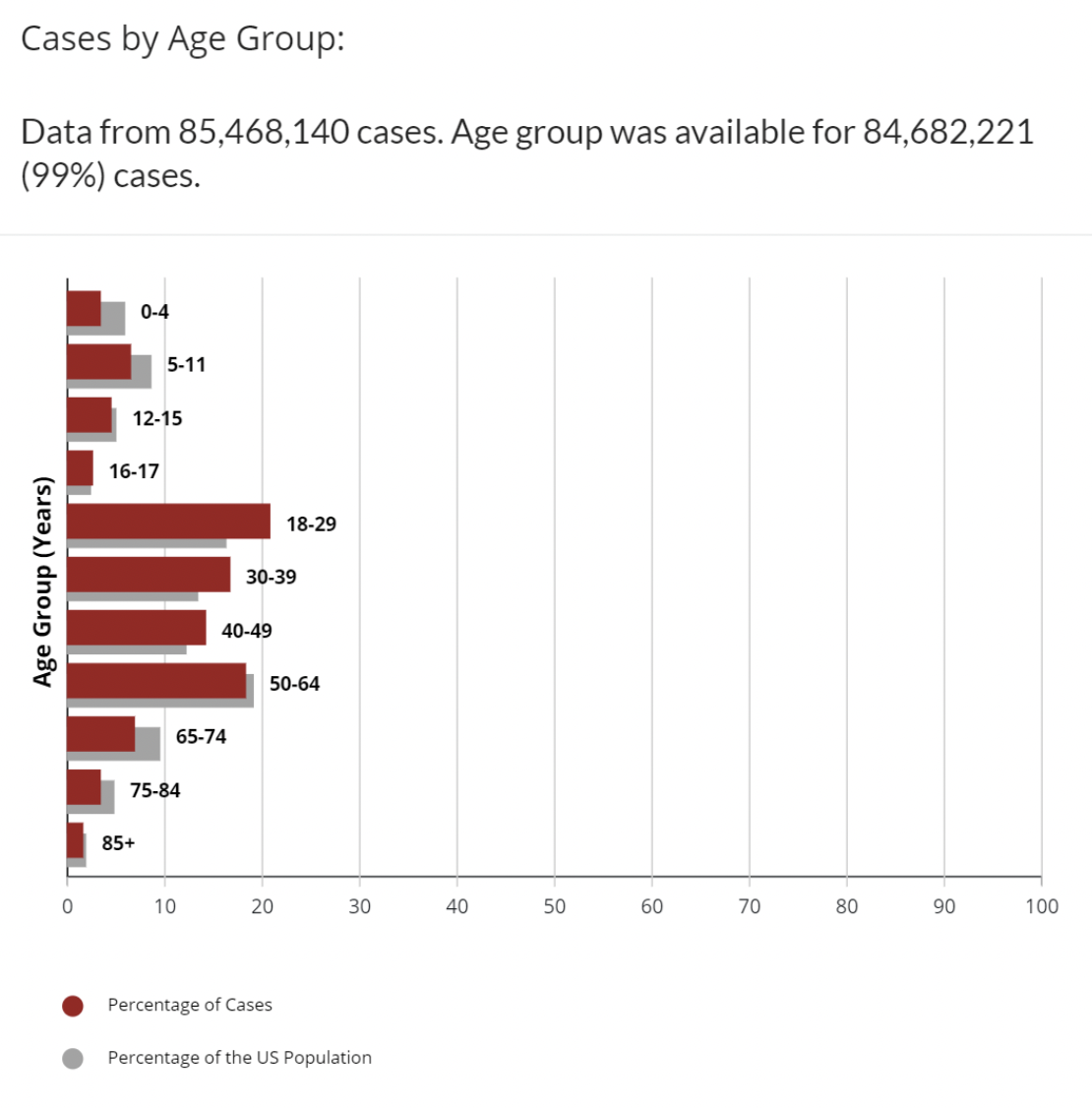

Til sammenligning kan dette forskellige datasæt på CDC hjemmeside kortlægger COVID-tilfælde efter aldersgruppe med de yderligere data om procentdelen af den amerikanske befolkning, der er i hver aldersgruppe.

Dette er bedre. Vi har mere kontekst. Vi kan se, at aldersgrupperne 18-29, 30-39, 40-49 alle har en højere procentdel af tilfælde end procentdelen af aldersgruppen i befolkningen. Der er stadig nogle ujævne aldersgrupper. Hvorfor er 16-17 en separat aldersgruppe? Stadig dette er ikke hele historien, men eksperter har skrevet klummer, lavet forudsigelser og mandater om mindre end dette. Med COVID er der naturligvis mange variabler ud over alder, der påvirker at blive talt som et positivt tilfælde: vaccinationsstatus, tilgængelighed af tests, antal gange testet, komorbiditeter og mange andre. Antallet af sager giver i sig selv et ufuldstændigt billede. De fleste eksperter ser også på antallet af dødsfald eller procentdelen af dødsfald pr. 100,000 indbyggere eller dødsfald for at se på, hvordan COVID påvirker hver aldersgruppe.

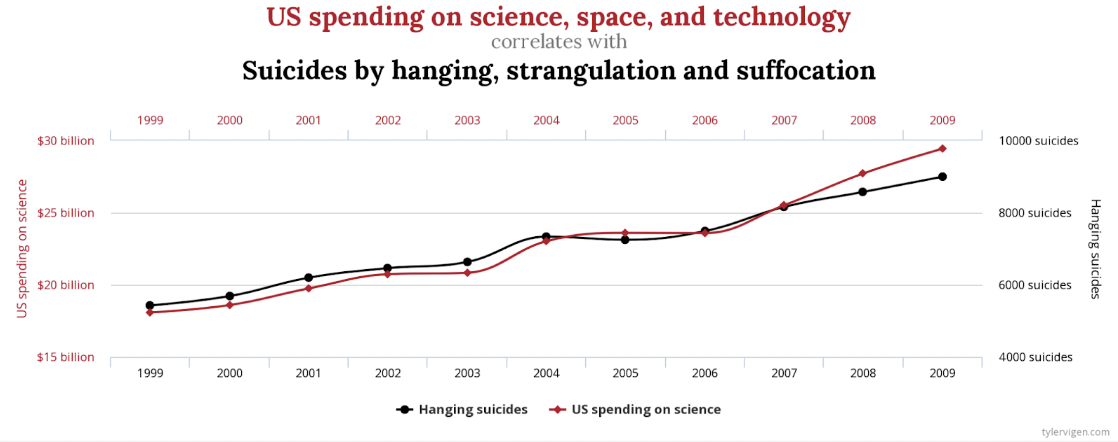

Vis ikke-relaterede sammenhænge

Det er klart, at der er en stærk korrelation mellem USA's udgifter til videnskab, rumfart og teknologi og antallet af selvmord ved hængning, kvælning og kvælning. Korrelationen er 99.79%, næsten et perfekt match.

Hvem ville dog sige, at disse på en eller anden måde er relaterede, eller det ene forårsager det andet? Der er andre mindre ekstreme eksempler, men ikke mindre falske. Der er en lignende stærk sammenhæng mellem bogstaver i Winning Word of Scripps National Spelling Bee og antallet af mennesker dræbt af giftige edderkopper. Sammentræf? Du bestemmer.

En anden måde at kortlægge disse data, der kan være mindre vildledende, ville være at inkludere nul på begge Y-akser.

Vis data unøjagtigt

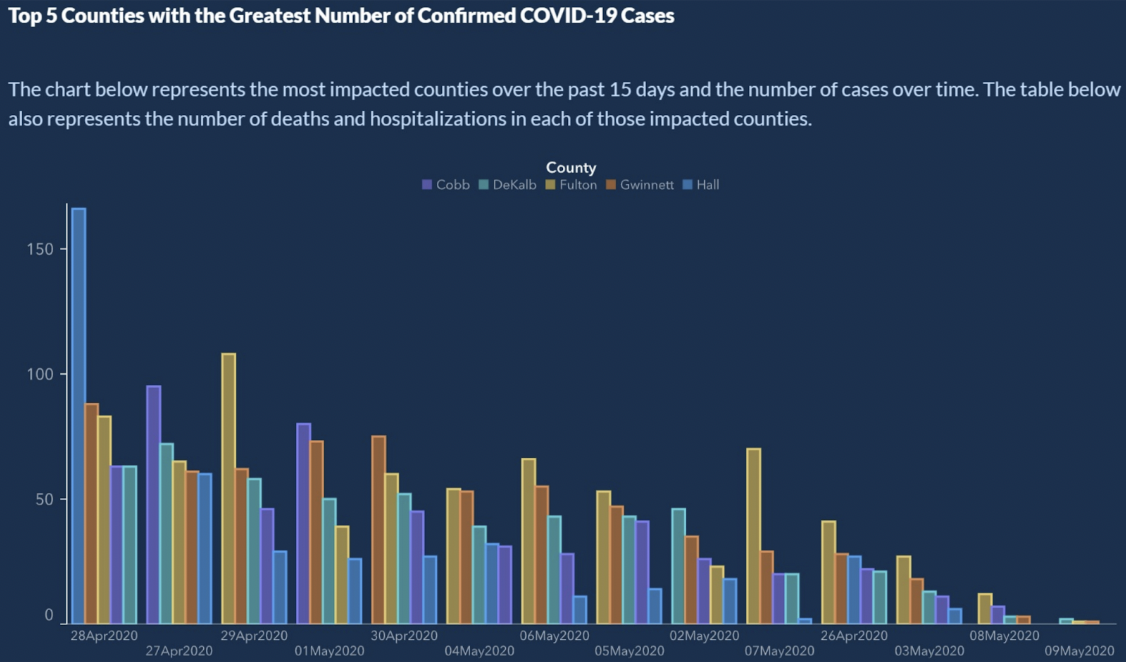

Fra Sådan viser du data dårligt, præsenterede den amerikanske stat Georgia de 5 bedste amter med det største antal bekræftede COVID-19-tilfælde.

Ser lovligt ud, ikke? Der er klart en nedadgående tendens af bekræftede COVID-19-tilfælde. Kan du læse X-aksen? X-aksen repræsenterer tid. Typisk vil datoer stige fra venstre mod højre. Her ser vi en lille tidsrejse på X-aksen:

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 ...

Vente? Hvad? X-aksen er ikke sorteret kronologisk. Så hvor flot trenden end ser ud, kan vi ikke drage nogen konklusioner. Hvis datoerne er bestilt, viser søjlerne for antallet af sager mere et savtandsmønster end nogen form for en trend.

Den nemme løsning her er at sortere datoerne, som en kalender gør.

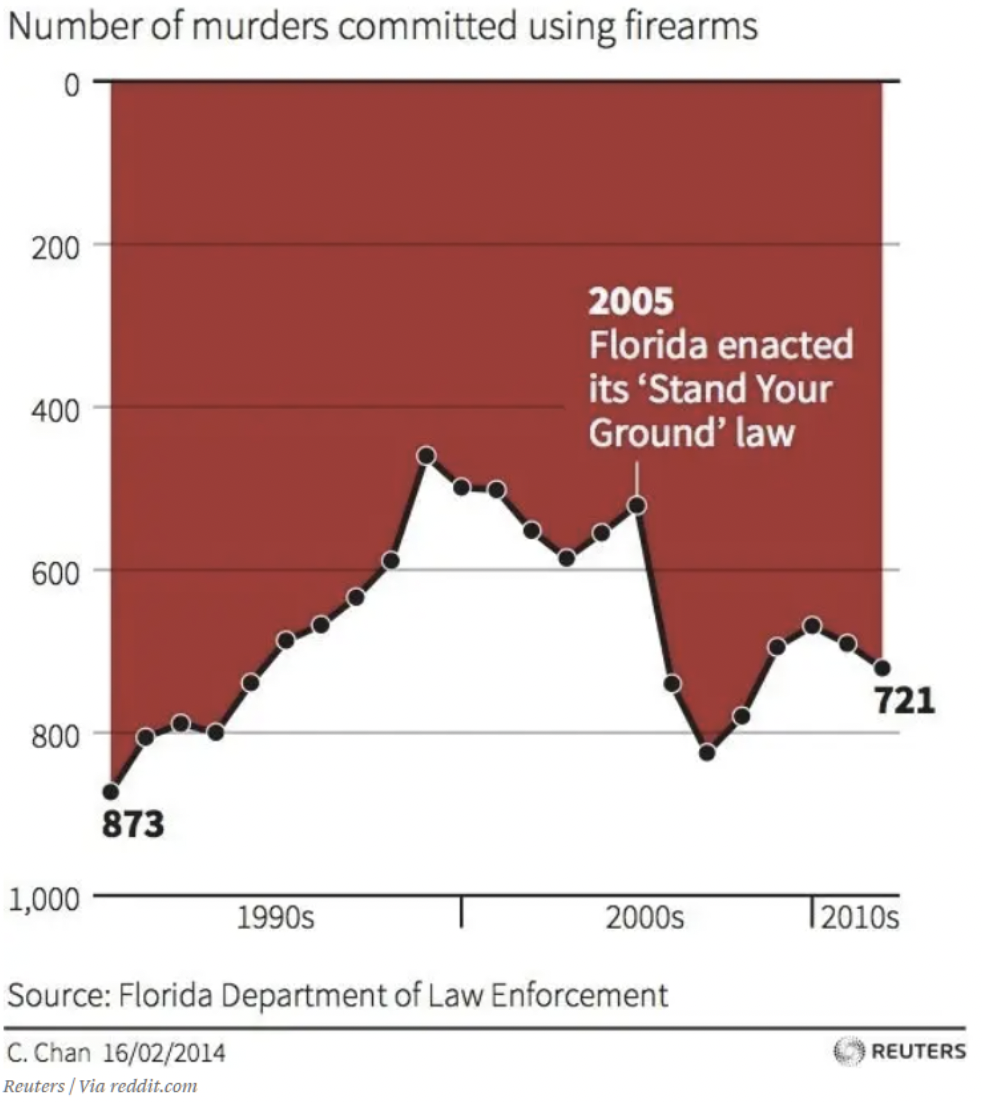

Vis data ukonventionelt

Vi har alle travlt. Vores hjerner har lært os at foretage hurtige vurderinger baseret på antagelser, som har været konsekvente i vores verden. For eksempel viser hver graf, jeg nogensinde har set, x- og y-akserne mødes ved nul eller laveste værdier. Hvis du kort ser på dette diagram, hvilke konklusioner kan du drage om effekten af Floridas "Stå din grundlov.”? Jeg skammer mig over at indrømme det, men denne graf narrede mig i starten. Dit øje trækkes bekvemt til teksten og pilen i midten af grafikken. Ned er op i denne graf. Det er måske ikke løgn – dataene er okay der. Men jeg må tro, at det er meningen at bedrage. Hvis du ikke har set den endnu, er nul på y-aksen øverst. Så efterhånden som data falder, betyder det flere dødsfald. Dette diagram viser, at antallet af mord med skydevåben øget efter 2005, indikeret ved, at tendensen går ned.

Vis dataene forsimplet

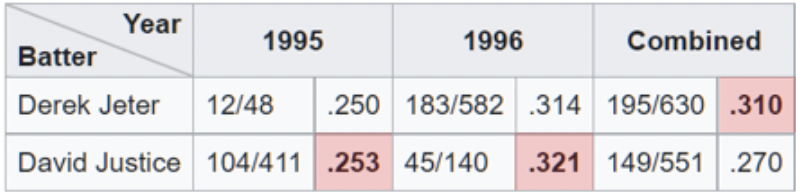

Et eksempel på over-simplificering af data kan ses, når analytikere drager fordel af Simpsons Paradox. Dette er et fænomen, der opstår, når aggregerede data ser ud til at demonstrere en anden konklusion, end når de er opdelt i delmængder. Denne fælde er let at falde i, når man ser på aggregerede procenter på højt niveau. En af de klareste illustrationer af Simpsons paradoks på arbejde er relateret til slaggennemsnit.

Her ser vi, at Derek Jeter har et højere samlet slaggennemsnit end David Justice for sæsonerne 1995 og 1996. Paradokset kommer ind, når vi indser, at Justice slog Jeter i batting-gennemsnit begge disse år. Hvis du ser grundigt efter, giver det mening, når du indser, at Jeter havde omkring 4x flere at-bats (nævneren) i 1996 med et 007 lavere gennemsnit i 1996. Hvorimod Justice havde omkring 10x antallet af at-bats på kun . 003 højere gennemsnit i 1995.

Præsentationen fremstår ligetil, men Simpsons paradoks har bevidst eller ubevidst ført til forkerte konklusioner. For nylig har der været eksempler på Simpsons Paradox i nyhederne og på sociale medier relateret til vacciner og COVID-dødelighed. En kortlægge viser en linjegraf, der sammenligner dødsrater mellem vaccinerede og uvaccinerede for personer i alderen 10-59 år. Diagrammet viser, at de uvaccinerede konsekvent har en lavere dødelighed. Hvad sker der her?

Problemet ligner det, vi ser med slaggennemsnit. Nævneren i dette tilfælde er antallet af individer i hver aldersgruppe. Grafen kombinerer grupper, der har forskellige resultater. Ser vi på den ældre aldersgruppe, 50-59 år, hver for sig, ser vi, at de vaccinerede klarer sig bedre. Ligeledes ser vi, hvis vi ser på 10-49, også, at de vaccinerede klarer sig bedre. Paradoksalt nok, når man ser på det kombinerede sæt, ser uvaccinerede ud til at have et dårligere resultat. På denne måde er du i stand til at argumentere for modsatte argumenter ved hjælp af dataene.

Dataene er partiske

Data kan ikke altid stole på. Selv i det videnskabelige samfund indrømmede over en tredjedel af de adspurgte forskere "tvivlsom forskningspraksis." En anden detektiv for forskningssvindel siger: "Der er meget sandsynligt meget mere bedrageri i data - tabeller, linjegrafer, sekventeringsdata [- end vi faktisk opdager]. Enhver, der sidder ved deres køkkenbord, kan sætte nogle tal i et regneark og lave en linjegraf, som ser overbevisende ud."

Dette første eksempel ser ud som om nogen gjorde netop det. Jeg siger ikke, at dette er svindel, men som en undersøgelse genererer det bare ikke nogen data, der bidrager til en informeret beslutning. Det ser ud til, at undersøgelsen spurgte respondenterne om deres mening om tankstationskaffe eller en anden relevant aktuel begivenhed.

- Superb

- Great

- Meget godt

Jeg har beskåret Twitter-opslaget for at fjerne henvisninger til den skyldige part, men dette er hele diagrammet over de endelige resultater af undersøgelsen. Undersøgelser som denne er ikke ualmindelige. Det er klart, at ethvert diagram, der er oprettet ud fra de data, der er et resultat af svarene, viser, at den pågældende kaffe ikke må gå glip af.

Problemet er, at hvis du havde fået denne undersøgelse og ikke fandt et svar, der passede til din tankegang, ville du springe undersøgelsen over. Dette kan være et ekstremt eksempel på, hvordan upålidelige data kan skabes. Dårligt undersøgelsesdesign kan dog føre til færre svar, og de, der svarer, har kun én mening, det er kun et spørgsmål om grad. Dataene er partiske.

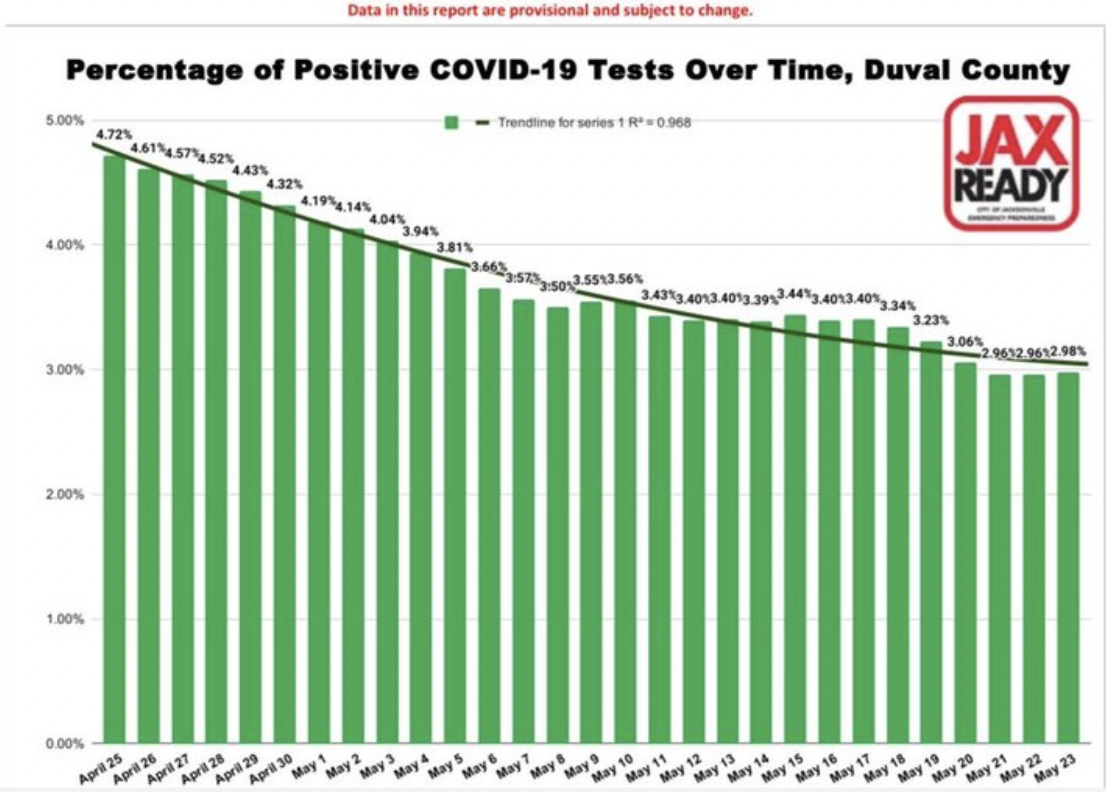

Dette andet eksempel på databias er fra filerne til "Værste COVID 19 vildledende grafer".

Igen, dette er subtilt og ikke helt indlysende. Søjlediagrammet viser et jævnt – næsten for jævnt – fald i procentdelen af positive COVID-19-tilfælde over tid for et amt i Florida. Du kan sagtens drage den konklusion, at sagerne er faldende. Det er fantastisk, visualiseringen repræsenterer dataene nøjagtigt. Problemet ligger i dataene. Så det er en mere lumsk skævhed, fordi du ikke kan se det. Det er bagt ind i dataene. De spørgsmål, du skal stille, inkluderer, hvem bliver testet? Med andre ord, hvad er nævneren, eller den befolkning, som vi ser på en procentdel af. Antagelsen er, at det er hele populationen eller i det mindste et repræsentativt udsnit.

Men i denne periode, i dette amt, blev prøver kun givet til et begrænset antal personer. De skulle have COVID-lignende symptomer eller var for nylig rejst til et land på listen over hot spots. Derudover forvirrende resultaterne er det faktum, at hver positiv test blev talt og hver negativ test blev talt. Typisk, når en person testede positiv, ville de teste igen, når virussen havde løbet sit forløb og ville teste negativ. Så på en måde er der for hvert positivt tilfælde et negativt testtilfælde, som annullerer det. Langt de fleste tests er negative, og hver enkelt persons negative test blev talt. Du kan se, hvordan dataene er partiske og ikke særligt nyttige til at træffe beslutninger.

AI-input og -træning er biased

Der er mindst to måder, hvorpå kunstig intelligens kan føre til skæve resultater: begyndende med forudindtaget data eller brug af skæve algoritmer til at behandle gyldige data.

Forspændt input

Mange af os er under indtryk af, at AI kan have tillid til at knuse tallene, anvende dens algoritmer og spytte en pålidelig analyse af dataene ud. Kunstig intelligens kan kun være så smart, som den er trænet. Hvis de data, som den er trænet på, er ufuldkomne, vil resultaterne eller konklusionerne heller ikke være til at stole på. I lighed med tilfældet ovenfor med undersøgelsesbias er der en række måder, hvorpå data kan være forudindtaget i maskinlæring:.

- Prøvebias – træningsdatasættet er ikke repræsentativt for hele befolkningen.

- Eksklusion bias – nogle gange er det, der ser ud til at være afvigende, faktisk gyldigt, eller hvor vi trækker grænsen for, hvad der skal inkluderes (postnumre, datoer osv.).

- Målebias – konventionen er altid at måle fra midten og bunden af menisken, for eksempel ved måling af væsker i målekolber eller reagensglas (undtagen kviksølv).

- Recall bias – når forskning afhænger af deltagernes hukommelse.

- Observatør-bias - forskere, som alle mennesker, er mere tilbøjelige til at se, hvad de forventer at se.

- Sexistisk og racistisk skævhed – køn eller race kan være over- eller underrepræsenteret.

- Association bias – dataene forstærker stereotyper

For at AI kan returnere pålidelige resultater, skal dens træningsdata repræsentere den virkelige verden. Som vi har diskuteret i en tidligere blogartikel, er udarbejdelsen af data kritisk og ligesom ethvert andet dataprojekt. Upålidelige data kan lære maskinlæringssystemer den forkerte lektie og vil resultere i den forkerte konklusion. Når det er sagt, "Alle data er partiske. Dette er ikke paranoia. Dette er fakta." – Dr. Sanjiv M. Narayan, Stanford University School of Medicine.

Brug af forudindtaget data til træning har ført til en række bemærkelsesværdige AI-fejl. (Eksempler link. , link., forskning link...)

Forspændte algoritmer

En algoritme er et sæt regler, der accepterer et input og skaber output for at besvare et forretningsproblem. De er ofte veldefinerede beslutningstræer. Algoritmer føles som sorte kasser. Ingen er sikker på, hvordan de fungerer, ofte, ikke engang virksomheder, der bruger dem. Åh, og de er ofte proprietære. Deres mystiske og komplekse natur er en af grundene til, at forudindtaget algoritmer er så lumske. .

Overvej AI-algoritmer inden for medicin, HR eller finans, som tager race i betragtning. Hvis race er en faktor, kan algoritmen ikke være raceblind. Dette er ikke teoretisk. Problemer som disse er blevet opdaget i den virkelige verden ved hjælp af AI i leje, ride-share, lån ansøgnings og nyretransplantationer.

Den nederste linje er, at hvis dine data eller algoritmer er dårlige, er værre end ubrugelige, kan de være farlige. Der er sådan noget som "algoritmisk revision." Målet er at hjælpe organisationer med at identificere de potentielle risici relateret til algoritmen, da den relaterer til retfærdighed, bias og diskrimination. Andre steder, Facebook bruger AI til at bekæmpe bias i AI.

Folk er partiske

Vi har mennesker på begge sider af ligningen. Folk forbereder analysen, og folk modtager informationen. Der er forskere, og der er læsere. I enhver kommunikation kan der være problemer med transmissionen eller modtagelsen.

Tag for eksempel vejret. Hvad betyder "en chance for regn"? For det første, hvad mener meteorologer, når de siger, at der er en chance for regn? Ifølge den amerikanske regering National Weather Service, en chance for regn, eller hvad de kalder Probability of Precipitation (PoP), er et af de mindst forståede elementer i en vejrudsigt. Det har en standarddefinition: "Sandsynligheden for nedbør er simpelthen en statistisk sandsynlighed på 0.01" [sic] af [sic] mere nedbør i et givet område i det givne prognoseområde i den angivne tidsperiode." Det "givne område" er prognoseområdet, eller broadstøbt område. Det betyder, at den officielle sandsynlighed for nedbør afhænger af tilliden til, at det vil regne et sted i området og procentdelen af området, der bliver vådt. Med andre ord, hvis meteorologen er sikker på, at det kommer til at regne i prognoseområdet (Confidence = 100%), så repræsenterer PoP den del af området, der vil modtage regn.

Paris Street; Regnvejrsdag,Gustave Caillebotte (1848-1894) Chicago Art Institute Public Domain

Chancen for regn afhænger af både tillid og område. Det vidste jeg ikke. Jeg formoder, at andre mennesker heller ikke ved det. Omkring 75 % af befolkningen forstår ikke præcist, hvordan PoP beregnes, eller hvad det er meningen at repræsentere. Så bliver vi narret, eller er dette et problem med opfattelsen. Lad os kalde det nedbørsopfattelse. Skyder vi vejrudsigteren skylden? For at være retfærdig er der nogle forvirring også blandt vejrudsigterne. I en undersøgelse43% af de adspurgte meteorologer sagde, at der er meget lidt sammenhæng i definitionen af PoP.

Selve analysen er forudindtaget

Af de fem indflydelsesfaktorer er analysen i sig selv den mest overraskende. I videnskabelig forskning, der resulterer i, at et gennemgået papir bliver publiceret, opstilles der typisk en teori, der defineres metoder til at teste hypotesen, data indsamles, derefter analyseres dataene. Den type analyse, der udføres, og hvordan den udføres, er undervurderet i, hvordan det påvirker konklusionerne. I en papir offentliggjort tidligere i år (januar 2022), i International Journal of Cancer, evaluerede forfatterne, om resultaterne af randomiserede kontrollerede forsøg og retrospektive observationsstudier. Deres resultater konkluderede, at

Ved at variere analytiske valg i komparativ effektivitetsforskning genererede vi modsatrettede resultater. Vores resultater tyder på, at nogle retrospektive observationsstudier kan finde ud af, at en behandling forbedrer resultaterne for patienter, mens en anden lignende undersøgelse måske finder, at den ikke gør det, blot baseret på analytiske valg.

Tidligere, når du læser en videnskabelig tidsskriftsartikel, hvis du er ligesom mig, har du måske troet, at resultaterne eller konklusionerne udelukkende handler om data. Nu ser det ud til, at resultaterne, eller om den oprindelige hypotese bekræftes eller afkræftes, også kan afhænge af analysemetoden.

En anden studere fundet lignende resultater. Artiklen, Mange analytikere, ét datasæt: Gør gennemsigtig, hvordan variationer i analytiske valg påvirker resultater, beskriver, hvordan de gav det samme datasæt til 29 forskellige teams at analysere. Dataanalyse ses ofte som en streng, veldefineret proces, der fører til en enkelt konklusion.

På trods af metodologers remonstrationer er det let at overse, at resultater kan afhænge af den valgte analytiske strategi, som i sig selv er gennemsyret af teori, antagelser og valgpunkter. I mange tilfælde er der mange rimelige (og mange urimelige) tilgange til at evaluere data, der har betydning for et forskningsspørgsmål.

Forskerne crowd-sourcede analysen af dataene og kom til den konklusion, at al forskning omfatter subjektive beslutninger – herunder hvilken type analyse der skal bruges – som kan påvirke det endelige resultat af undersøgelsen.

En andens anbefaling forsker hvem der har analyseret ovenstående undersøgelse, skal være forsigtig, når man bruger et enkelt papir til at træffe beslutninger eller drage konklusioner.

Håndtering af bias i Analytics

Dette er simpelthen ment som en advarselsfortælling. Viden kan beskytte os mod at blive grebet af svindel. Jo mere bevidste om mulige metoder en scanner kan bruge til at narre os, jo mindre sandsynligt er det, at vi bliver taget i, f.eks. af en lommetyvs vildledning eller den glatte snak om et Ponzi-spil. Sådan er det med at forstå og erkende potentielle skævheder, der påvirker vores analyser. Hvis vi er opmærksomme på potentielle påvirkninger, kan vi måske præsentere historien bedre og i sidste ende træffe bedre beslutninger.