Analytische Lüge

Die Voreingenommenheit der Analyse

Mark Twain sagte umstritten so etwas wie: „Es gibt drei Arten von Lügen: Lügen, verdammte Lügen und Analytik"

Wir gehen davon aus, dass Analysen uns nützliche, umsetzbare Erkenntnisse liefern. Was wir oft nicht erkennen, ist, wie unsere eigenen Vorurteile und die anderer die Antworten beeinflussen, die uns sogar die ausgeklügeltste Software und Systeme geben. Manchmal werden wir auf unehrliche Weise manipuliert, aber häufiger sind es subtile und unbewusste Vorurteile, die sich in unsere Analysen einschleichen. Die Motivation hinter voreingenommenen Analysen ist vielfältig. Manchmal werden die unparteiischen Ergebnisse, die wir von der Wissenschaft erwarten, beeinflusst durch 1) subtile Entscheidungen bei der Darstellung der Daten, 2) inkonsistente oder nicht repräsentative Daten, 3) wie KI-Systeme trainiert werden, 4) die Unwissenheit, Inkompetenz von Forschern oder anderen, die es versuchen um die Geschichte zu erzählen, 5) die Analyse selbst.

Die Präsentation ist voreingenommen

Einige der Lügen sind leichter zu erkennen als andere. Wenn Sie wissen, wonach Sie suchen müssen, können Sie potenzielle leichter erkennen irreführende Grafiken und Diagramme.

Es gibt mindestens Fünf Möglichkeiten, Daten irreführend darzustellen: 1) Einen begrenzten Datensatz anzeigen, 2). Unzusammenhängende Korrelationen zeigen, 3) Daten ungenau zeigen, 4) Daten unkonventionell zeigen oder 5). Daten stark vereinfacht anzeigen.

Zeigen Sie einen begrenzten Datensatz an

Die Begrenzung der Daten oder die manuelle Auswahl eines nicht zufälligen Abschnitts der Daten kann oft eine Geschichte erzählen, die nicht mit dem Gesamtbild übereinstimmt. Schlechtes Sampling oder Rosinenpicken liegt vor, wenn der Analyst eine nicht repräsentative Stichprobe verwendet, um eine größere Gruppe zu repräsentieren.

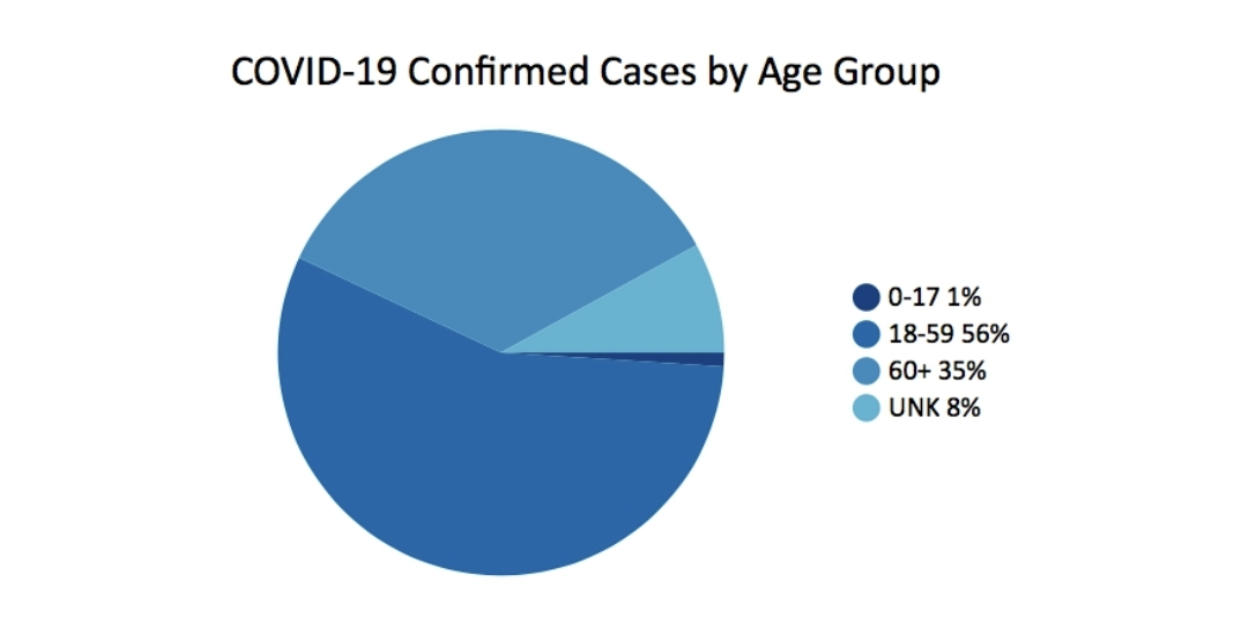

Im März 2020 wurde Georgiens Gesundheitsministerium veröffentlichte dieses Diagramm als Teil seines täglichen Statusberichts. Es wirft tatsächlich mehr Fragen auf, als es beantwortet.

Eines der Dinge, die fehlen, ist der Kontext. Beispielsweise wäre es hilfreich zu wissen, wie hoch der Prozentsatz der Bevölkerung für jede Altersgruppe ist. Ein weiteres Problem mit dem einfach aussehenden Tortendiagramm sind die ungleichmäßigen Altersgruppen. 0-17 hat 18 Jahre, 18-59 hat 42, 60+ ist offen, hat aber ungefähr 40 Jahre. Die Schlussfolgerung, allein angesichts dieses Diagramms, ist, dass die Mehrheit der Fälle in der Altersgruppe der 18- bis 59-Jährigen liegt. Die Altersgruppe der über 60-Jährigen scheint weniger stark von COVID-Fällen betroffen zu sein. Aber das ist nicht die ganze Geschichte.

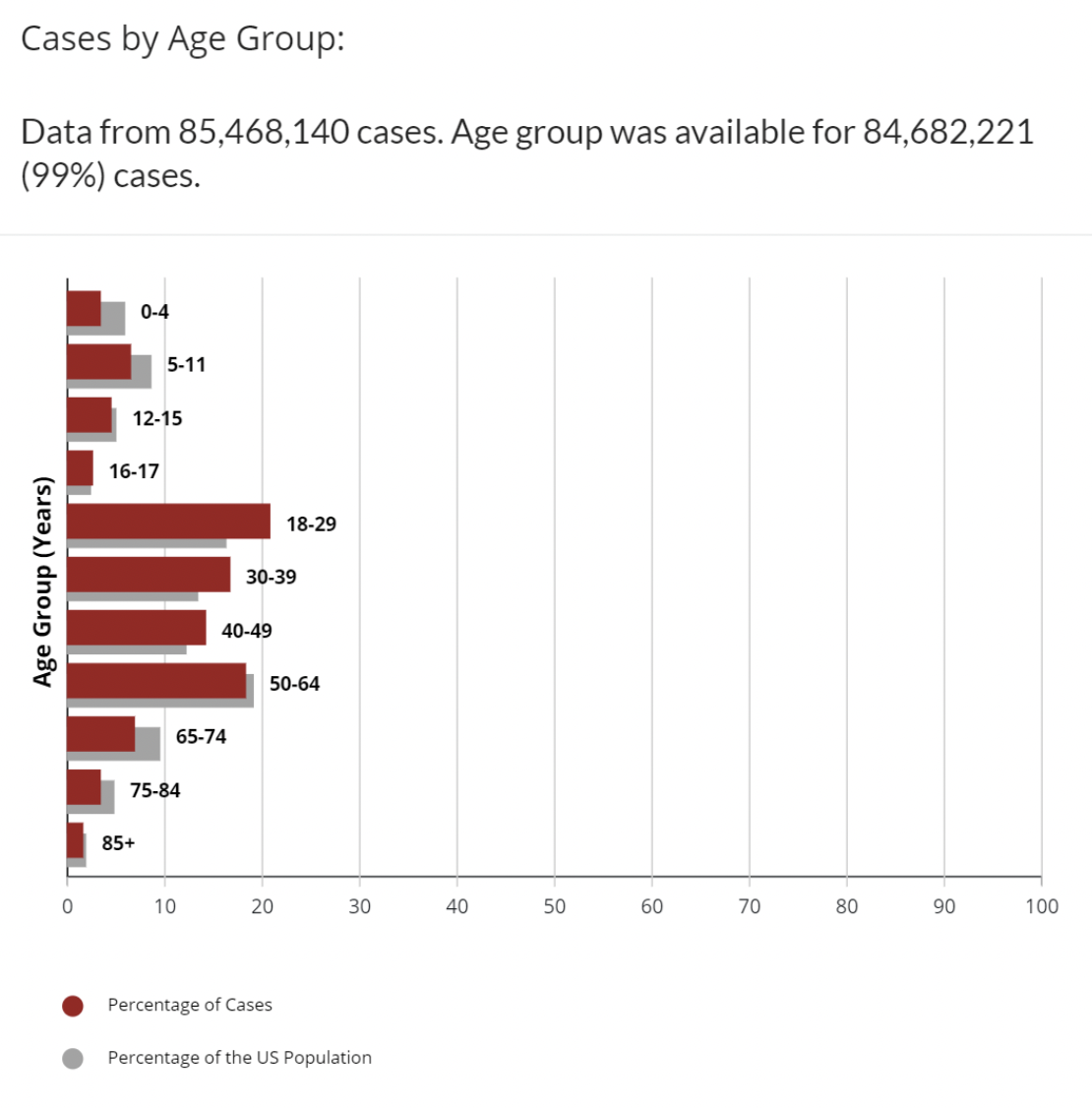

Zum Vergleich dieser andere Datensatz auf der CDC-Website zeigt COVID-Fälle nach Altersgruppe mit den zusätzlichen Daten zum Prozentsatz der US-Bevölkerung, der sich in jeder Altersgruppe befindet.

Das ist besser. Wir haben mehr Kontext. Wir können sehen, dass die Altersgruppen 18–29, 30–39, 40–49 alle einen höheren Prozentsatz an Fällen aufweisen als der Prozentsatz der Altersgruppe in der Bevölkerung. Es gibt immer noch einige ungleiche Altersgruppen. Warum ist 16-17 eine separate Altersgruppe? Dies ist noch nicht die ganze Geschichte, aber Experten haben Kolumnen geschrieben, Vorhersagen gemacht und Mandate über weniger als das abgegeben. Offensichtlich gibt es bei COVID neben dem Alter viele Variablen, die sich darauf auswirken, ob ein positiver Fall gezählt wird: Impfstatus, Verfügbarkeit von Tests, Anzahl der Tests, Komorbiditäten und viele andere. Die Zahl der Fälle selbst liefert ein unvollständiges Bild. Die meisten Experten betrachten auch die Anzahl der Todesfälle oder den Prozentsatz der Todesfälle pro 100,000 Einwohner oder Todesfälle, um zu untersuchen, wie sich COVID auf jede Altersgruppe auswirkt.

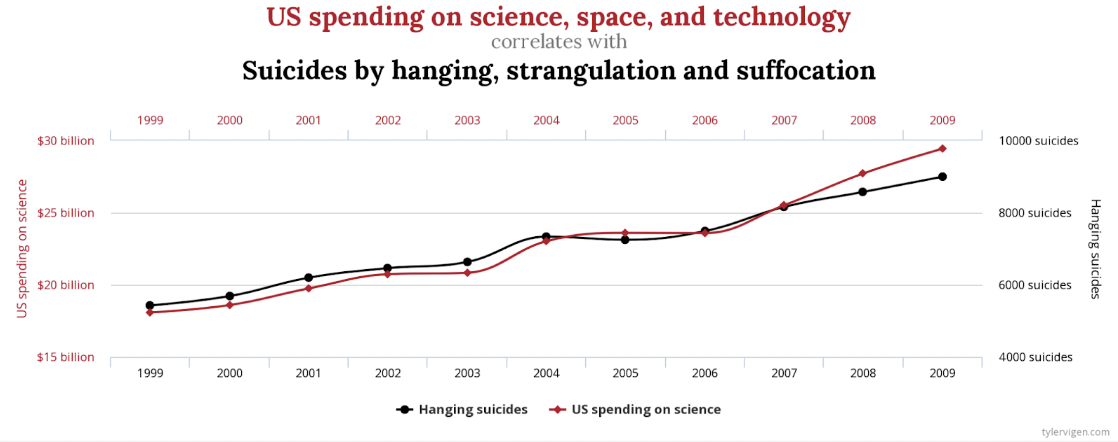

Unzusammenhängende Korrelationen anzeigen

Offensichtlich gibt es eine starke Korrelation zwischen den US-Ausgaben für Wissenschaft, Raumfahrt und Technologie und der Zahl der Selbstmorde durch Erhängen, Strangulieren und Ersticken. Die Korrelation beträgt 99.79 %, nahezu eine perfekte Übereinstimmung.

Wer würde jedoch behaupten, dass diese irgendwie zusammenhängen oder das eine das andere verursacht? Es gibt andere weniger extreme Beispiele, aber nicht weniger falsch. Es gibt eine ähnlich starke Korrelation zwischen Buchstaben in Winning Word of Scripps National Spelling Bee und der Anzahl der von Giftspinnen getöteten Menschen. Zufall? Du entscheidest.

Eine andere Möglichkeit, diese Daten grafisch darzustellen, die möglicherweise weniger irreführend ist, besteht darin, Null auf beiden Y-Achsen einzuschließen.

Daten ungenau anzeigen

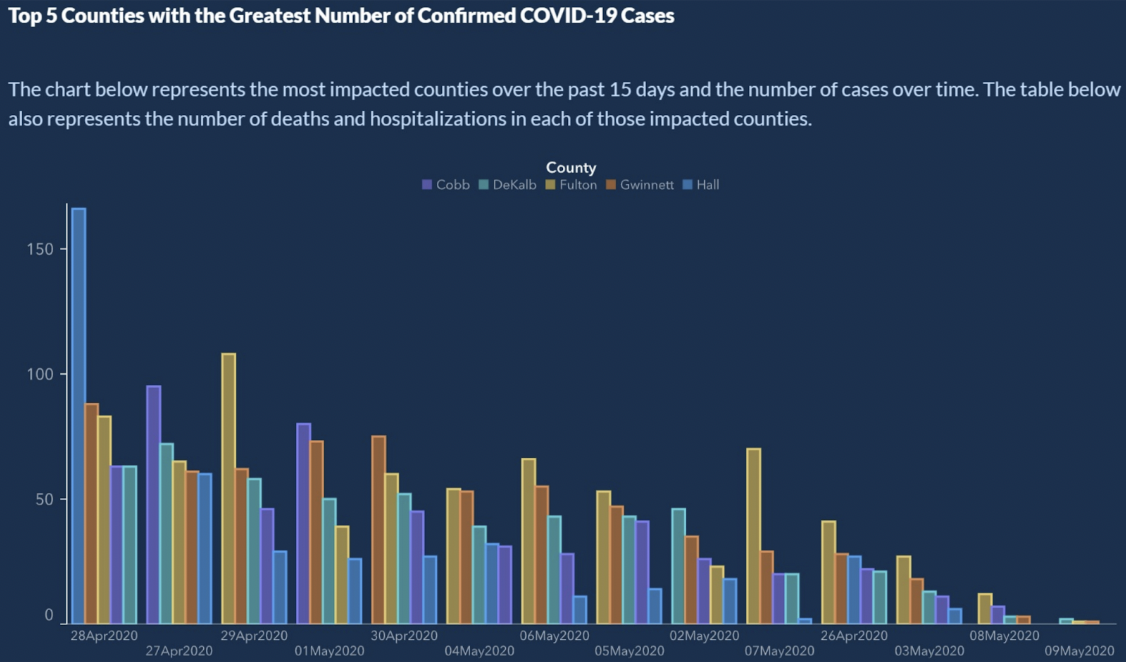

Aus Wie man Daten schlecht anzeigtpräsentierte der US-Bundesstaat Georgia die Top 5 Counties mit der größten Anzahl bestätigter COVID-19-Fälle.

Sieht echt aus, oder? Es gibt eindeutig einen Abwärtstrend bestätigter COVID-19-Fälle. Kannst du die X-Achse ablesen? Die X-Achse repräsentiert die Zeit. In der Regel werden die Daten von links nach rechts erhöht. Hier sehen wir eine kleine Zeitreise auf der X-Achse:

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 ...

Warte ab? Was? Die X-Achse ist nicht chronologisch sortiert. So schön der Trend auch aussehen mag, wir können daraus keine Schlussfolgerungen ziehen. Wenn die Daten geordnet sind, zeigen die Balken für die Fallzahlen eher ein Sägezahnmuster als irgendeinen Trend.

Die einfache Lösung besteht darin, die Daten so zu sortieren, wie es ein Kalender tut.

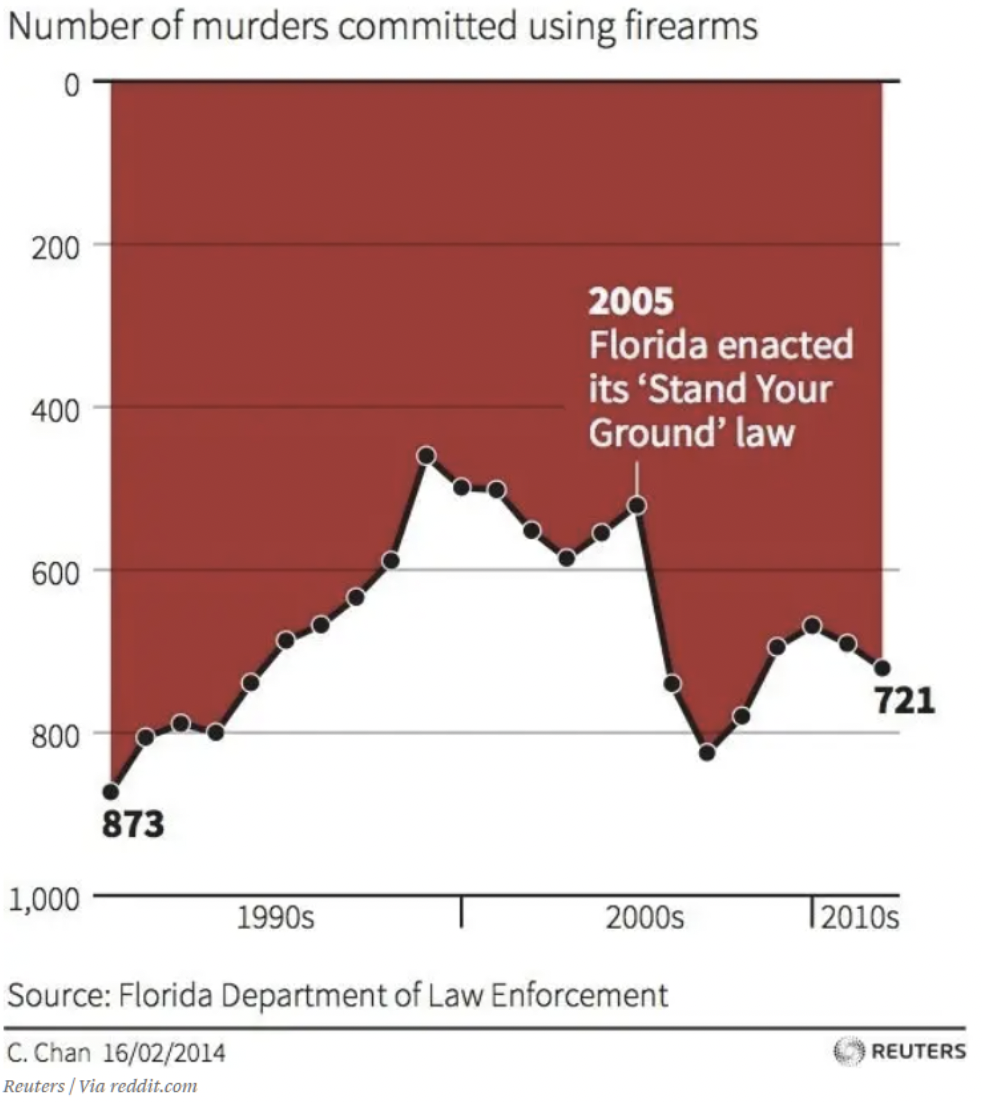

Zeigen Sie Daten unkonventionell an

Wir sind alle beschäftigt. Unser Gehirn hat uns gelehrt, schnelle Urteile auf der Grundlage von Annahmen zu treffen, die in unserer Welt konsistent sind. Zum Beispiel zeigt jede Grafik, die ich je gesehen habe, dass sich die x- und y-Achsen bei Null oder den niedrigsten Werten treffen. Wenn Sie sich dieses Diagramm kurz ansehen, welche Schlussfolgerungen können Sie über die Wirkung von Florida ziehen? „Bleib bei deinem Grundgesetz.“? Ich schäme mich, es zuzugeben, aber diese Grafik hat mich zuerst getäuscht. Ihr Blick wird bequem auf den Text und den Pfeil in der Mitte der Grafik gelenkt. Unten ist oben in diesem Diagramm. Es ist vielleicht keine Lüge – die Daten sind in Ordnung. Aber ich muss denken, dass es täuschen soll. Falls Sie es noch nicht gesehen haben, die Null auf der y-Achse ist ganz oben. Wenn die Daten nach unten tendieren, bedeutet das also mehr Todesfälle. Dieses Diagramm zeigt, dass die Anzahl der Morde mit Schusswaffen hat nach 2005, angezeigt durch den Trend gehen nach unten.

Zeigen Sie die Daten stark vereinfacht an

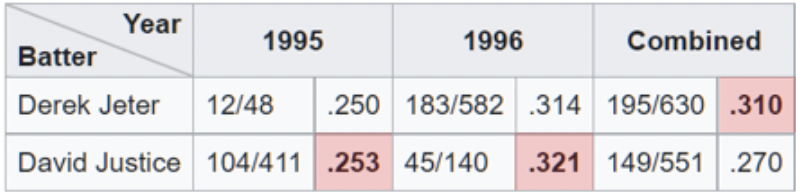

Ein Beispiel für eine übermäßige Vereinfachung der Daten kann gesehen werden, wenn Analysten das Simpson-Paradoxon ausnutzen. Dies ist ein Phänomen, das auftritt, wenn aggregierte Daten eine andere Schlussfolgerung zu zeigen scheinen als wenn sie in Teilmengen aufgeteilt werden. In diese Falle tappt man leicht, wenn man sich aggregierte Prozentsätze auf hoher Ebene ansieht. Eine der klarsten Illustrationen von Simpsons Paradox bei der Arbeit ist verwandt mit Schlagdurchschnitte.

Hier sehen wir, dass Derek Jeter in den Saisons 1995 und 1996 insgesamt einen höheren Schlagdurchschnitt hat als David Justice. Das Paradoxon kommt ins Spiel, wenn wir feststellen, dass Justice Jeter in beiden Jahren im Schlagdurchschnitt besiegt hat. Wenn Sie genau hinsehen, ist es sinnvoll, wenn Sie erkennen, dass Jeter 4 ungefähr 1996x mehr At-Fledermäuse (der Nenner) hatte, bei einem um 007 niedrigeren Durchschnitt im Jahr 1996. Justice dagegen hatte ungefähr 10x so viele At-Fledermäuse bei nur . 003 höherer Durchschnitt im Jahr 1995.

Die Präsentation erscheint einfach, aber das Simpson-Paradoxon hat wissentlich oder unwissentlich zu falschen Schlussfolgerungen geführt. Kürzlich gab es in den Nachrichten und in den sozialen Medien Beispiele für das Simpson-Paradoxon im Zusammenhang mit Impfstoffen und der COVID-Mortalität. Einer Tabelle zeigt ein Liniendiagramm, das die Sterblichkeitsraten zwischen geimpften und ungeimpften Personen im Alter von 10 bis 59 Jahren vergleicht. Das Diagramm zeigt, dass die Ungeimpften durchweg eine niedrigere Sterblichkeitsrate haben. Was ist denn hier los?

Das Problem ähnelt dem, das wir bei Schlagdurchschnitten sehen. Der Nenner ist in diesem Fall die Anzahl der Personen in jeder Altersgruppe. Das Diagramm kombiniert Gruppen mit unterschiedlichen Ergebnissen. Wenn wir die ältere Altersgruppe 50-59 separat betrachten, sehen wir, dass die Geimpften besser abschneiden. Wenn wir uns 10-49 ansehen, sehen wir auch, dass die Geimpften besser abschneiden. Paradoxerweise scheinen Ungeimpfte bei Betrachtung des kombinierten Satzes ein schlechteres Ergebnis zu haben. Auf diese Weise können Sie anhand der Daten für gegensätzliche Argumente plädieren.

Die Daten sind voreingenommen

Daten kann man nicht immer vertrauen. Auch in der Scientific Community räumten über ein Drittel der befragten Forscher ein „fragwürdige Forschungspraktiken“. Ein anderer Betrugsdetektivin recherchieren sagt: „Es gibt sehr wahrscheinlich viel mehr Betrug in Daten – Tabellen, Liniendiagrammen, Sequenzdaten [– als wir tatsächlich entdecken]. Jeder, der an seinem Küchentisch sitzt, kann einige Zahlen in eine Tabelle einfügen und ein Liniendiagramm erstellen, das überzeugend aussieht.“

Das zuerst Beispiel sieht aus, als hätte jemand genau das getan. Ich sage nicht, dass dies Betrug ist, aber als Umfrage werden einfach keine Daten generiert, die zu einer fundierten Entscheidung beitragen. Es sieht so aus, als ob die Umfrage die Befragten nach ihrer Meinung zu Tankstellenkaffee oder einem anderen relevanten aktuellen Ereignis gefragt hat.

- Hervorragend

- Groß

- Sehr gute

Ich habe den Twitter-Beitrag gekürzt, um Verweise auf die schuldige Partei zu entfernen, aber dies ist das eigentliche gesamte Diagramm der endgültigen Ergebnisse der Umfrage. Umfragen wie diese sind keine Seltenheit. Offensichtlich zeigt jedes Diagramm, das aus den Daten der Antworten erstellt wurde, dass der betreffende Kaffee nicht fehlen darf.

Das Problem ist, dass Sie die Umfrage überspringen würden, wenn Sie diese Umfrage erhalten hätten und keine Antwort finden würden, die Ihrer Meinung entspricht. Dies kann ein extremes Beispiel dafür sein, wie nicht vertrauenswürdige Daten erstellt werden können. Ein schlechtes Umfragedesign kann jedoch zu weniger Antworten führen, und diejenigen, die antworten, haben nur eine Meinung, es ist nur eine Frage des Grades. Die Daten sind voreingenommen.

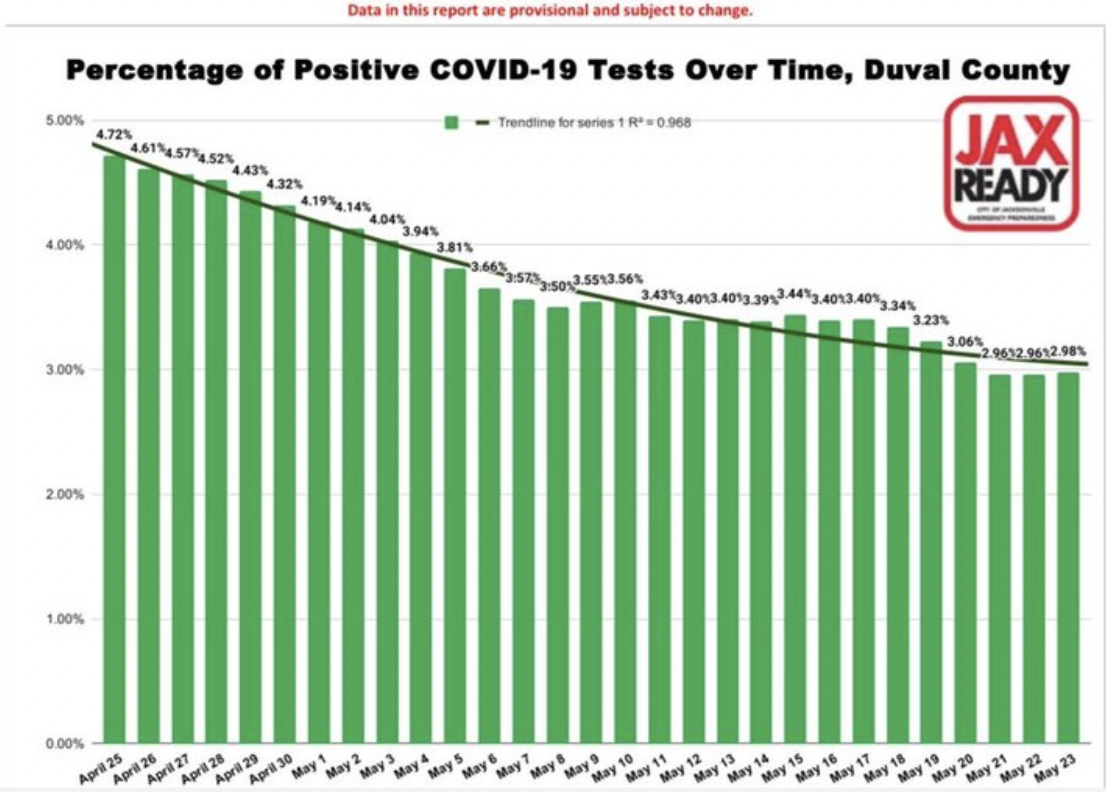

Dieses zweite Beispiel für Datenverzerrung stammt aus den Dateien von „Die schlimmsten irreführenden Diagramme zu COVID 19"

Auch dies ist subtil und nicht ganz offensichtlich. Das Balkendiagramm zeigt einen gleichmäßigen – fast zu gleichmäßigen – Rückgang des Prozentsatzes positiver COVID-19-Fälle im Laufe der Zeit für einen Bezirk in Florida. Man könnte leicht den Schluss ziehen, dass die Fälle zurückgehen. Das ist großartig, die Visualisierung stellt die Daten genau dar. Das Problem liegt in den Daten. Es ist also eine heimtückischere Voreingenommenheit, weil Sie es nicht sehen können. Es ist in die Daten eingebrannt. Zu den Fragen, die Sie stellen müssen, gehören: Wer wird getestet? Mit anderen Worten, was ist der Nenner oder die Bevölkerung, von der wir einen Prozentsatz betrachten. Die Annahme ist, dass es sich um die gesamte Bevölkerung oder zumindest um eine repräsentative Stichprobe handelt.

Während dieser Zeit wurden in diesem Landkreis jedoch nur Tests an einer begrenzten Anzahl von Personen durchgeführt. Sie mussten COVID-ähnliche Symptome haben oder waren kürzlich in ein Land gereist, das auf der Liste der Hotspots steht. Zusätzlich verwirrt werden die Ergebnisse durch die Tatsache, dass jeder positive Test gezählt und jeder negative Test gezählt wurde. Wenn eine Person positiv getestet wurde, testete sie normalerweise erneut, wenn das Virus seinen Lauf genommen hatte, und wurde negativ getestet. Es gibt also gewissermaßen für jeden positiven Fall einen negativen Testfall, der ihn aufhebt. Die überwiegende Mehrheit der Tests ist negativ, und die negativen Tests jeder Person wurden gezählt. Sie können sehen, wie die Daten voreingenommen und nicht besonders nützlich für Entscheidungen sind.

KI-Eingabe und -Training ist voreingenommen

Es gibt mindestens zwei Möglichkeiten, wie KI zu verzerrten Ergebnissen führen kann: Beginnend mit verzerrten Daten oder durch Verwendung verzerrter Algorithmen zur Verarbeitung gültiger Daten.

Voreingenommener Eingang

Viele von uns haben den Eindruck, dass man sich darauf verlassen kann, dass KI die Zahlen verarbeitet, ihre Algorithmen anwendet und eine zuverlässige Analyse der Daten ausspuckt. Künstliche Intelligenz kann nur so schlau sein, wie sie trainiert wird. Wenn die Daten, auf denen es trainiert wird, unvollkommen sind, kann den Ergebnissen oder Schlussfolgerungen auch nicht vertraut werden. Ähnlich wie im obigen Fall der Verzerrung durch Umfragen gibt es eine Reihe von Möglichkeiten, wie Daten sein können voreingenommen beim maschinellen Lernen:.

- Stichprobenverzerrung – der Trainingsdatensatz ist nicht repräsentativ für die Gesamtbevölkerung.

- Ausschlussverzerrung – manchmal sind scheinbare Ausreißer tatsächlich gültig, oder wir ziehen die Grenze, was einzuschließen ist (Postleitzahlen, Daten usw.).

- Messverzerrung – Die Konvention besteht darin, immer von der Mitte und dem Boden des Meniskus aus zu messen, z. B. wenn Flüssigkeiten in Messkolben oder Reagenzgläsern gemessen werden (außer Quecksilber).

- Recall Bias – wenn die Forschung vom Gedächtnis der Teilnehmer abhängt.

- Beobachterverzerrung – Wissenschaftler neigen, wie alle Menschen, eher dazu, das zu sehen, was sie zu sehen erwarten.

- Sexistische und rassistische Vorurteile – Geschlecht oder Rasse können über- oder unterrepräsentiert sein.

- Assoziationsverzerrung – die Daten verstärken Stereotypen

Damit KI verlässliche Ergebnisse liefern kann, müssen ihre Trainingsdaten die reale Welt abbilden. Wie wir in einem früheren Blogartikel besprochen haben, ist die Aufbereitung von Daten kritisch und wie bei jedem anderen Datenprojekt. Unzuverlässige Daten können maschinellen Lernsystemen die falsche Lektion erteilen und zu falschen Schlussfolgerungen führen. Das heißt: „Alle Daten sind voreingenommen. Das ist keine Paranoia. Das ist Fakt." – Dr. Sanjiv M. Narayan, Medizinische Fakultät der Stanford University.

Die Verwendung von voreingenommenen Daten für das Training hat zu einer Reihe bemerkenswerter KI-Fehler geführt. (Beispiele hier und hier, Forschung hier..)

Voreingenommene Algorithmen

Ein Algorithmus ist eine Reihe von Regeln, die eine Eingabe akzeptieren und eine Ausgabe erstellen, um ein Geschäftsproblem zu lösen. Sie sind oft gut definierte Entscheidungsbäume. Algorithmen fühlen sich an wie Black Boxes. Niemand ist sich sicher, wie sie funktionieren, oft nicht einmal die Unternehmen, die sie verwenden. Oh, und sie sind oft proprietär. Ihre mysteriöse und komplexe Natur ist einer der Gründe, warum voreingenommene Algorithmen so heimtückisch sind. .

Betrachten Sie KI-Algorithmen in der Medizin, im Personalwesen oder im Finanzwesen, die die Rasse berücksichtigen. Wenn die Rasse ein Faktor ist, kann der Algorithmus nicht rassenblind sein. Das ist nicht theoretisch. Probleme wie diese wurden in der realen Welt mithilfe von KI entdeckt Verleih, Mitfahrgelegenheit, Darlehensanträges, und Nierentransplantationen.

Die Quintessenz ist, dass wenn Ihre Daten oder Algorithmen schlecht sind, schlimmer als nutzlos, sie gefährlich sein können. Es gibt so etwas wie „algorithmische Prüfung.“ Ziel ist es, Organisationen dabei zu helfen, die potenziellen Risiken im Zusammenhang mit dem Algorithmus in Bezug auf Fairness, Voreingenommenheit und Diskriminierung zu identifizieren. Anderswo, Facebook verwendet KI, um Vorurteile in der KI zu bekämpfen.

Menschen sind voreingenommen

Wir haben Menschen auf beiden Seiten der Gleichung. Die Leute bereiten die Analyse vor und die Leute erhalten die Informationen. Es gibt Forscher und es gibt Leser. Bei jeder Kommunikation kann es zu Übertragungs- oder Empfangsproblemen kommen.

Nehmen Sie zum Beispiel das Wetter. Was bedeutet „wahrscheinlich Regen“? Erstens, was meinen Meteorologen, wenn sie sagen, dass es regnen kann? Nach Angaben der US-Regierung National Weather Service, eine Regenwahrscheinlichkeit oder was sie als Niederschlagswahrscheinlichkeit (PoP) bezeichnen, ist eines der am wenigsten verstandenen Elemente in einer Wettervorhersage. Es hat eine Standarddefinition: „Die Niederschlagswahrscheinlichkeit ist einfach eine statistische Wahrscheinlichkeit von 0.01 Zoll [sic] von [sic] mehr Niederschlag in einem bestimmten Gebiet in dem bestimmten Vorhersagegebiet in dem angegebenen Zeitraum.“ Das „vorgegebene Gebiet“ ist das Vorhersagegebiet, oder broadBesetzungsbereich. Das bedeutet, dass die offizielle Niederschlagswahrscheinlichkeit von der Zuversicht abhängt, dass es irgendwo in der Gegend regnen wird, und von dem Prozentsatz der Fläche, der nass wird. Mit anderen Worten, wenn der Meteorologe zuversichtlich ist, dass es im vorhergesagten Gebiet regnen wird (Konfidenz = 100 %), stellt der PoP den Teil des Gebiets dar, der Regen erhalten wird.

Pariser Straße; Regnerischer Tag, Gustave Caillebotte (1848-1894) Chicago Art Institute Public Domain

Die Regenwahrscheinlichkeit hängt sowohl vom Vertrauen als auch vom Gebiet ab. Das wusste ich nicht. Ich vermute, dass andere Leute das auch nicht wissen. Etwa 75 % der Bevölkerung verstehen nicht genau, wie PoP berechnet wird oder was er darstellen soll. Lassen wir uns also täuschen oder ist das ein Wahrnehmungsproblem? Nennen wir es Niederschlagswahrnehmung. Geben wir dem Meteorologen die Schuld? Um fair zu sein, es gibt einige Verwirrung auch unter Meteorologen. In Eins Umfragegaben 43 % der befragten Meteorologen an, dass die Definition von PoP sehr wenig einheitlich ist.

Die Analyse selbst ist voreingenommen

Von den fünf Einflussfaktoren dürfte die Analyse selbst am überraschendsten sein. In der wissenschaftlichen Forschung, die zur Veröffentlichung eines begutachteten Artikels führt, wird typischerweise eine Theorie hypothetisiert, Methoden zum Testen der Hypothese definiert, Daten gesammelt und dann die Daten analysiert. Die Art der Analyse, die durchgeführt wird und wie sie durchgeführt wird, wird in Bezug darauf, wie sie die Schlussfolgerungen beeinflusst, unterschätzt. In einem Krepppapier Anfang dieses Jahres (Januar 2022) im International Journal of Cancer veröffentlicht, bewerteten die Autoren, ob die Ergebnisse randomisierter kontrollierter Studien und retrospektiver Beobachtungsstudien. Ihre Ergebnisse kamen zu dem Schluss, dass

Durch unterschiedliche analytische Entscheidungen in der vergleichenden Wirksamkeitsforschung haben wir gegensätzliche Ergebnisse erzielt. Unsere Ergebnisse deuten darauf hin, dass einige retrospektive Beobachtungsstudien feststellen, dass eine Behandlung die Ergebnisse für Patienten verbessert, während eine andere ähnliche Studie möglicherweise feststellt, dass dies nicht der Fall ist, nur basierend auf analytischen Entscheidungen.

In der Vergangenheit haben Sie beim Lesen eines Artikels in einer wissenschaftlichen Zeitschrift, wenn Sie wie ich sind, vielleicht gedacht, dass es bei den Ergebnissen oder Schlussfolgerungen nur um die Daten geht. Nun scheint es, dass die Ergebnisse oder ob die anfängliche Hypothese bestätigt oder widerlegt wird, auch von der Analysemethode abhängen können.

Ein anderer Studie ähnliche Ergebnisse gefunden. Der Artikel, Viele Analysten, ein Datensatz: Transparenz darüber schaffen, wie sich Variationen in analytischen Entscheidungen auf die Ergebnisse auswirken, beschreibt, wie sie denselben Datensatz 29 verschiedenen Teams zur Analyse gaben. Die Datenanalyse wird oft als strenger, klar definierter Prozess angesehen, der zu einer einzigen Schlussfolgerung führt.

Trotz der Proteste der Methodologen wird leicht übersehen, dass die Ergebnisse von der gewählten Analysestrategie abhängen können, die ihrerseits von Theorien, Annahmen und Entscheidungspunkten durchdrungen ist. In vielen Fällen gibt es viele vernünftige (und viele unvernünftige) Ansätze zur Auswertung von Daten, die sich auf eine Forschungsfrage beziehen.

Die Forscher führten eine Crowdsourcing-Analyse der Daten durch und kamen zu dem Schluss, dass alle Forschungen subjektive Entscheidungen beinhalten – einschließlich der Art der zu verwendenden Analyse – die das endgültige Ergebnis der Studie beeinflussen können.

Die Empfehlung eines anderen Forscher der die obige Studie analysiert hat, sollte vorsichtig sein, wenn er ein einzelnes Papier verwendet, um Entscheidungen zu treffen oder Schlussfolgerungen zu ziehen.

Adressierung von Bias in Analytics

Dies soll lediglich eine Warnung sein. Wissen kann uns davor schützen, auf Betrug hereinzufallen. Je besser wir uns der möglichen Methoden bewusst sind, die ein Scanner verwenden könnte, um uns zu täuschen, desto unwahrscheinlicher ist es, dass wir beispielsweise auf die Fehlleitung eines Taschendiebs oder das glatte Gerede eines Ponzi-Spiels hereinfallen. Es geht also darum, potenzielle Verzerrungen zu verstehen und zu erkennen, die sich auf unsere Analysen auswirken. Wenn wir uns möglicher Einflüsse bewusst sind, können wir die Geschichte möglicherweise besser darstellen und letztendlich bessere Entscheidungen treffen.