Analytics leugen

De vooringenomenheid van analyse

Mark Twain zei discutabel iets als: "Er zijn drie soorten leugens: leugens, verdomde leugens en... analytics. '

We nemen als vanzelfsprekend aan dat analytics ons nuttige, bruikbare inzichten geeft. Wat we ons vaak niet realiseren is hoe onze eigen vooroordelen en die van anderen de antwoorden beïnvloeden die we krijgen van zelfs de meest geavanceerde software en systemen. Soms worden we oneerlijk gemanipuleerd, maar vaker zijn het subtiele en onbewuste vooroordelen die onze analyses binnensluipen. De motivatie achter vooringenomen analyses is veelvoudig. Soms worden de onpartijdige resultaten die we van de wetenschap verwachten beïnvloed door 1) subtiele keuzes in hoe de gegevens worden gepresenteerd, 2) inconsistente of niet-representatieve gegevens, 3) hoe AI-systemen worden getraind, 4) de onwetendheid, incompetentie van onderzoekers of anderen die proberen om het verhaal te vertellen, 5) de analyse zelf.

De presentatie is bevooroordeeld

Sommige leugens zijn gemakkelijker te herkennen dan andere. Als u weet waarnaar u moet zoeken, kunt u mogelijk gemakkelijker detecteren misleidende grafieken en diagrammen.

Er zijn ten minste vijf manieren om gegevens misleidend weer te geven: 1) Toon een beperkte dataset, 2). Toon niet-gerelateerde correlaties, 3) Toon gegevens onnauwkeurig, 4) Toon gegevens onconventioneel, of 5). Gegevens te eenvoudig weergeven.

Toon een beperkte dataset

Het beperken van de gegevens of het handmatig selecteren van een niet-willekeurig deel van de gegevens kan vaak een verhaal vertellen dat niet consistent is met het grote geheel. Bad sampling, of cherry picking, is wanneer de analist een niet-representatieve steekproef gebruikt om een grotere groep te vertegenwoordigen.

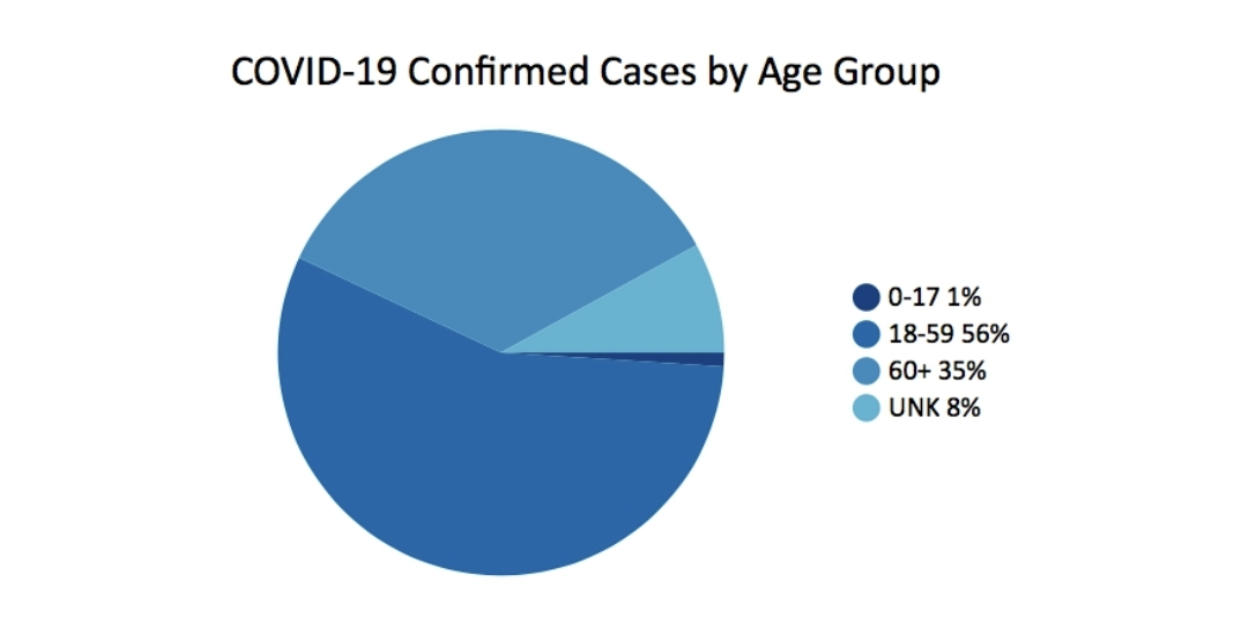

In maart 2020, Het Georgische ministerie van Volksgezondheid publiceerde deze grafiek als onderdeel van het dagelijkse statusrapport. Het roept eigenlijk meer vragen op dan het beantwoordt.

Een van de dingen die ontbreekt, is context. Het zou bijvoorbeeld nuttig zijn om te weten wat het percentage van de bevolking is voor elke leeftijdsgroep. Een ander probleem met het eenvoudig ogende cirkeldiagram zijn de ongelijke leeftijdsgroepen. De 0-17 heeft 18 jaar, 18-59 heeft 42, 60+ heeft een open einde, maar heeft ongeveer 40 jaar. De conclusie, alleen al op basis van deze grafiek, is dat de meerderheid van de gevallen zich in de leeftijdsgroep van 18-59 jaar bevindt. De leeftijdsgroep van 60 jaar en ouder lijkt minder zwaar te worden getroffen door COVID-gevallen. Maar dit is niet het hele verhaal.

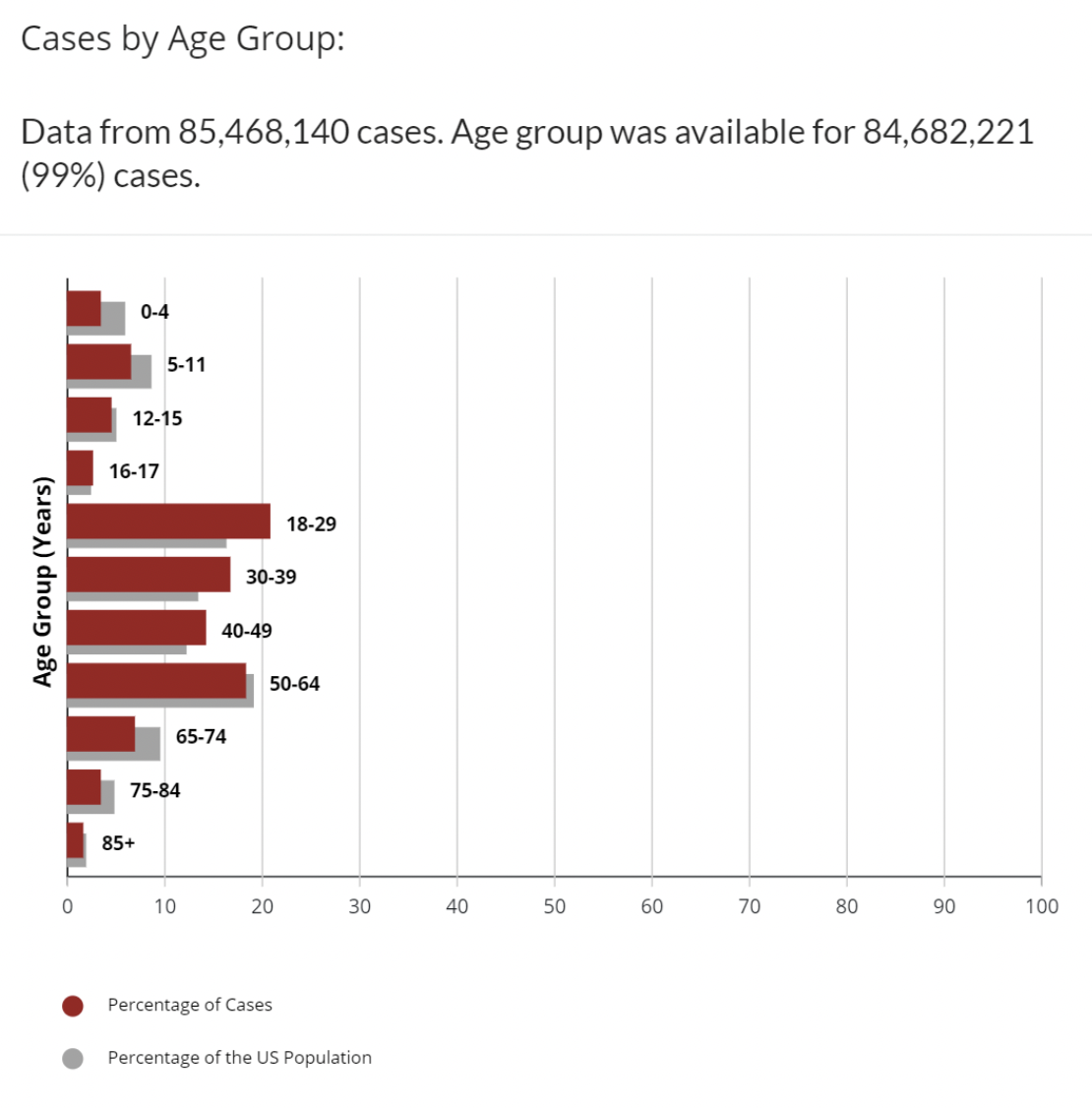

Ter vergelijking: deze verschillende dataset op de CDC-website brengt COVID-gevallen per leeftijdsgroep in kaart met de aanvullende gegevens over het percentage van de Amerikaanse bevolking in elke leeftijdscategorie.

Dit is beter. We hebben meer context. We zien dat de leeftijdsgroepen 18-29, 30-39, 40-49 allemaal een hoger percentage gevallen hebben dan het percentage van de leeftijdsgroep in de bevolking. Er zijn nog steeds een aantal ongelijke leeftijdsgroepen. Waarom is 16-17 een aparte leeftijdsgroep? Toch is dit niet het hele verhaal, maar experts hebben columns geschreven, voorspellingen gedaan en mandaten gegeven over minder dan dit. Het is duidelijk dat er bij COVID naast leeftijd veel variabelen zijn die van invloed zijn op het tellen als een positief geval: vaccinatiestatus, beschikbaarheid van tests, aantal keer getest, comorbiditeiten en vele andere. Het aantal gevallen zelf geeft een onvolledig beeld. De meeste experts kijken ook naar het aantal sterfgevallen, of percentages sterfgevallen per 100,000 inwoners, of dodelijke slachtoffers om te kijken hoe COVID van invloed is op elke leeftijdsgroep.

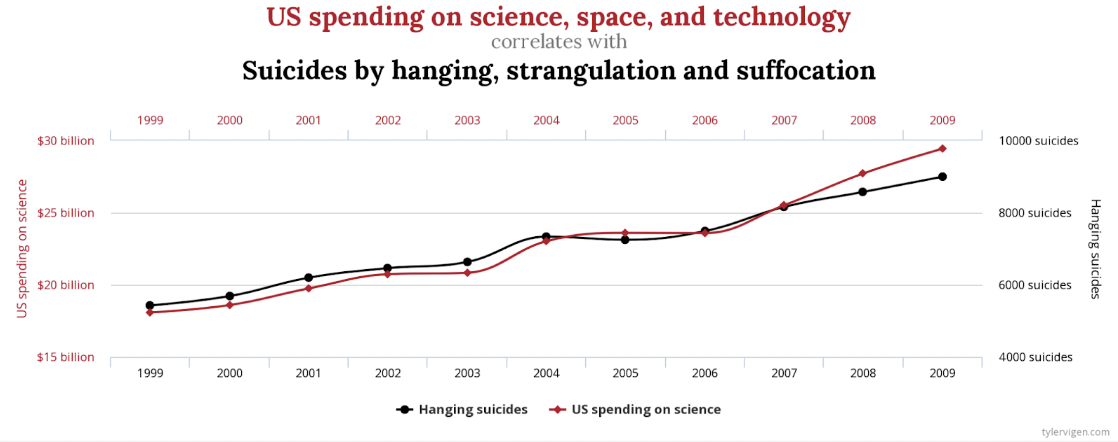

Toon niet-gerelateerde correlaties

Het is duidelijk dat er een sterke correlatie tussen de Amerikaanse uitgaven aan wetenschap, ruimte en technologie en het aantal zelfmoorden door ophanging, wurging en verstikking. De correlatie is 99.79%, bijna een perfecte match.

Wie zou echter beweren dat deze op de een of andere manier met elkaar verband houden, of dat het een het ander veroorzaakt? Er zijn andere, minder extreme voorbeelden, maar niet minder onecht. Er is een vergelijkbare sterke correlatie tussen Letters in Winning Word of Scripps National Spelling Bee en het aantal mensen gedood door giftige spinnen. Toeval? Jij beslist.

Een andere manier om deze gegevens in kaart te brengen die misschien minder misleidend is, is door nul op beide Y-assen op te nemen.

Gegevens onjuist weergeven

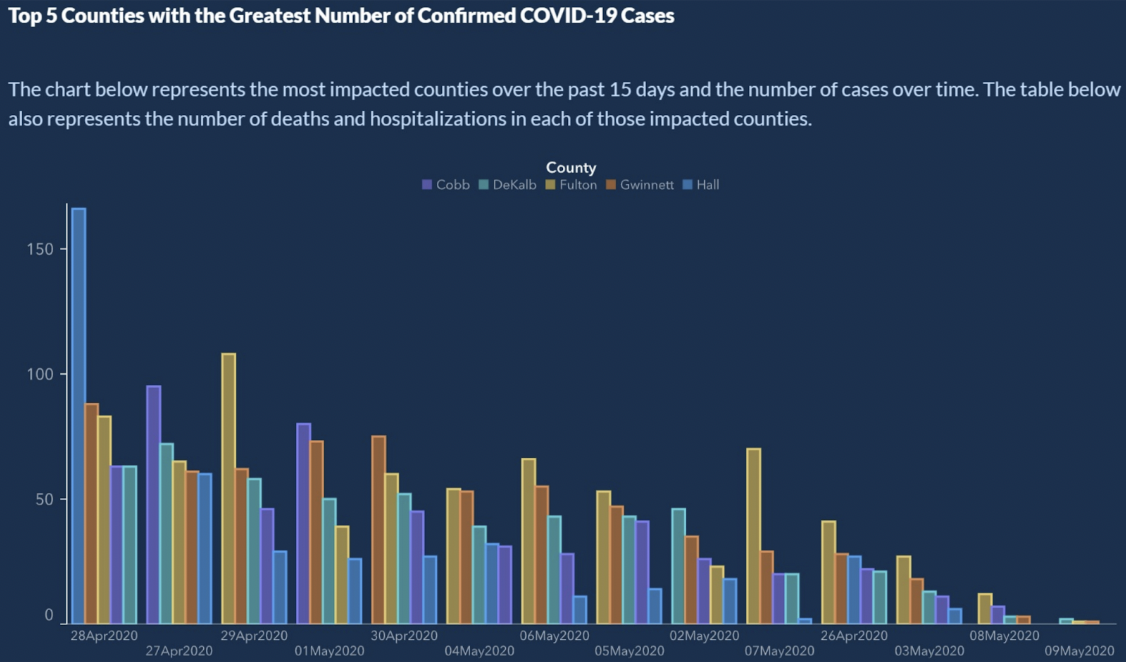

Van Gegevens slecht weergeven, presenteerde de Amerikaanse staat Georgia de top 5 van provincies met het grootste aantal bevestigde COVID-19-gevallen.

Ziet er legitiem uit, toch? Er is duidelijk een neerwaartse trend van bevestigde COVID-19-gevallen. Kun je de X-as lezen? De X-as stelt de tijd voor. Doorgaans lopen de datums van links naar rechts op. Hier zien we een kleine tijdreis op de X-as:

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 ...

Wacht? Wat? De X-as is niet chronologisch gesorteerd. Dus hoe mooi de trend er ook uitziet, we kunnen geen conclusies trekken. Als de datums zijn geordend, vertonen de balken voor het aantal gevallen meer een zaagtandpatroon dan een trend.

De eenvoudige oplossing hier is om de datums te sorteren zoals een kalender dat doet.

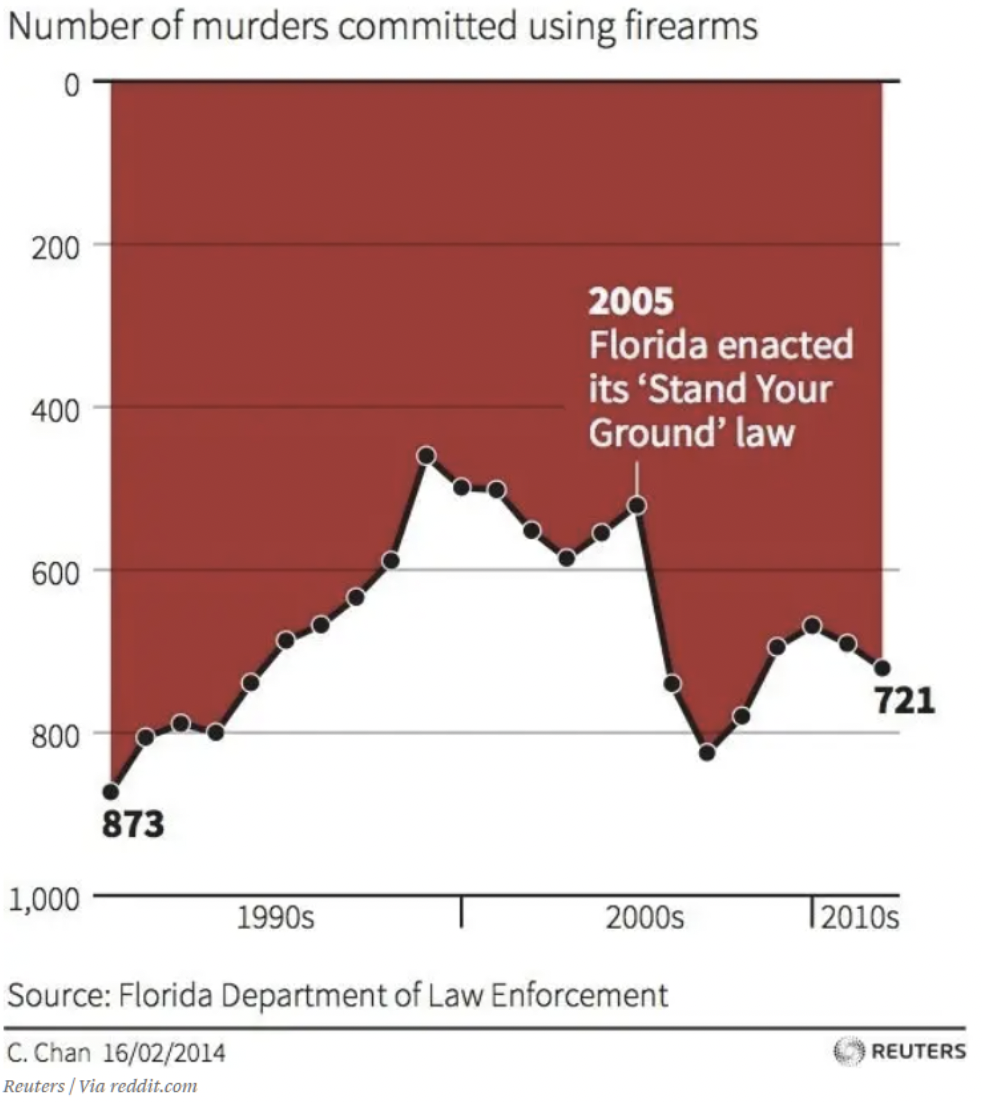

Gegevens onconventioneel weergeven

We zijn allemaal druk. Onze hersenen hebben ons geleerd om snel te oordelen op basis van aannames die consistent zijn geweest in onze wereld. Elke grafiek die ik ooit heb gezien, toont bijvoorbeeld de x- en y-assen die elkaar ontmoeten op nul of de laagste waarden. Als u kort naar deze grafiek kijkt, welke conclusies kunt u trekken over het effect van Florida's? “Houd je aan de grondwet.”? Ik schaam me om het toe te geven, maar deze grafiek hield me eerst voor de gek. Uw oog wordt gemakkelijk naar de tekst en de pijl in het midden van de afbeelding getrokken. Omlaag is omhoog in deze grafiek. Het is misschien geen leugen - de gegevens zijn in orde. Maar ik moet denken dat het bedoeld is om te misleiden. Als je het nog niet hebt gezien, staat nul op de y-as bovenaan. Dus als de gegevenstrends afnemen, betekent dat meer doden. Deze grafiek laat zien dat het aantal moorden met vuurwapens meer na 2005, aangegeven door de trend beneden.

Toon de gegevens te vereenvoudigd

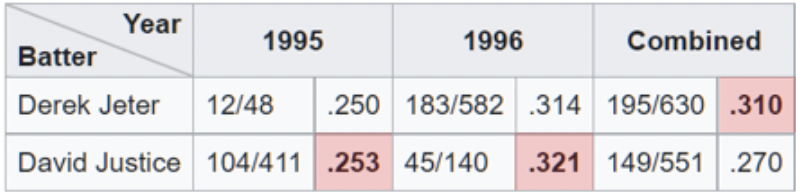

Een voorbeeld van oversimplificatie van de gegevens is te zien wanneer analisten profiteren van Simpson's Paradox. Dit is een fenomeen dat optreedt wanneer geaggregeerde gegevens een andere conclusie lijken te tonen dan wanneer ze in subsets worden opgesplitst. Deze valkuil is gemakkelijk te betreden als we kijken naar geaggregeerde percentages op hoog niveau. Een van de duidelijkste illustraties van Simpson's Paradox op het werk is gerelateerd aan: slaggemiddelden.

Hier zien we dat Derek Jeter een hoger algemeen slaggemiddelde heeft dan David Justice voor de seizoenen 1995 en 1996. De paradox komt binnen wanneer we ons realiseren dat Justice Jeter versloeg in beide jaren het slaggemiddelde. Als je goed kijkt, is het logisch als je je realiseert dat Jeter in 4 ongeveer 1996x meer slagbeurten (de noemer) had tegen een .007 lager gemiddelde in 1996. Terwijl Justice ongeveer 10x zoveel slagbeurten had op slechts . 003 hoger gemiddelde in 1995.

De presentatie lijkt eenvoudig, maar Simpson's Paradox heeft, bewust of onbewust, tot onjuiste conclusies geleid. Onlangs zijn er voorbeelden van Simpson's Paradox in het nieuws en op sociale media met betrekking tot vaccins en COVID-sterfte. Een in kaart te brengen toont een lijngrafiek waarin de sterftecijfers tussen gevaccineerd en niet-gevaccineerd worden vergeleken voor mensen van 10-59 jaar oud. De grafiek laat zien dat niet-gevaccineerden consequent een lager sterftecijfer hebben. Wat is hier aan de hand?

Het probleem is vergelijkbaar met het probleem dat we zien met slaggemiddelden. De noemer is in dit geval het aantal personen in elke leeftijdsgroep. De grafiek combineert groepen die verschillende uitkomsten hebben. Als we de oudere leeftijdsgroep, 50-59 jaar, apart bekijken, zien we dat de gevaccineerden het beter doen. Evenzo, als we naar 10-49 kijken, zien we ook dat de gevaccineerden het beter doen. Paradoxaal genoeg lijken niet-gevaccineerde mensen een slechter resultaat te hebben als we naar de gecombineerde set kijken. Op deze manier kunt u met behulp van de gegevens een pleidooi houden voor tegengestelde argumenten.

De gegevens zijn bevooroordeeld

Gegevens zijn niet altijd te vertrouwen. Zelfs in de wetenschappelijke gemeenschap gaf meer dan een derde van de ondervraagde onderzoekers toe dat "dubieuze onderzoekspraktijken." Nog een onderzoek fraude detective zegt: "Er is zeer waarschijnlijk veel meer fraude in gegevens - tabellen, lijngrafieken, sequentiegegevens [- dan we daadwerkelijk ontdekken]. Iedereen die aan de keukentafel zit, kan wat getallen in een spreadsheet zetten en een lijngrafiek maken die er overtuigend uitziet.”

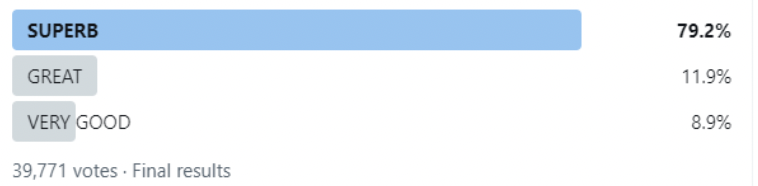

Dit eerst voorbeeld het lijkt erop dat iemand dat precies heeft gedaan. Ik zeg niet dat dit fraude is, maar als onderzoek genereert het gewoon geen gegevens die bijdragen aan een weloverwogen beslissing. Het lijkt erop dat de enquête respondenten heeft gevraagd naar hun mening over koffie bij tankstations of een andere relevante actuele gebeurtenis.

- prachtige

- Grote

- Heel goed

Ik heb de Twitter-post bijgesneden om verwijzingen naar de schuldige partij te verwijderen, maar dit is de eigenlijke volledige grafiek van de uiteindelijke resultaten van de enquête. Dergelijke enquêtes zijn niet ongewoon. Het is duidelijk dat elke grafiek die is gemaakt op basis van de gegevens die voortvloeien uit de reacties, de koffie in kwestie niet mag missen.

Het probleem is dat als u deze enquête had gekregen en geen antwoord zou vinden dat bij u past, u de enquête zou overslaan. Dit kan een extreem voorbeeld zijn van hoe onbetrouwbare gegevens kunnen worden gecreëerd. Een slecht onderzoeksontwerp kan echter leiden tot minder reacties en degenen die wel reageren, hebben maar één mening, het is slechts een kwestie van gradatie. De gegevens zijn bevooroordeeld.

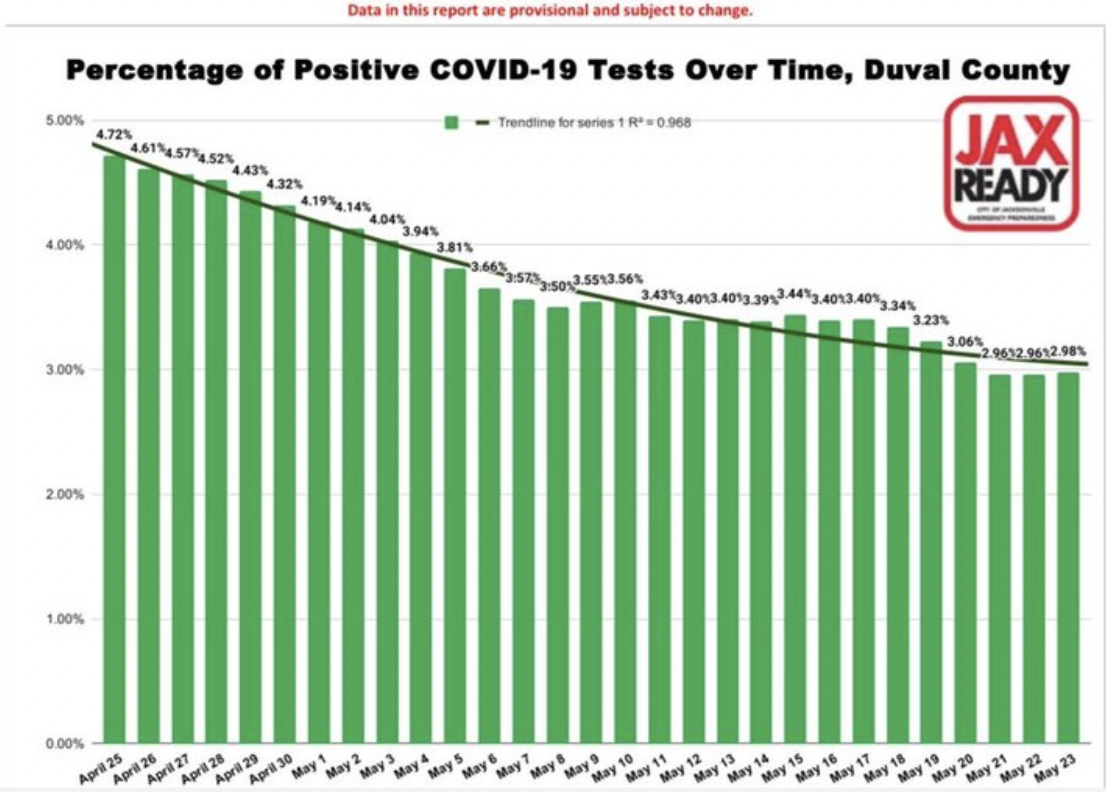

Dit tweede voorbeeld van databias komt uit de bestanden van “Slechtste COVID 19 misleidende grafieken. '

Nogmaals, dit is subtiel en niet helemaal duidelijk. De staafgrafiek toont een soepele – bijna te vloeiende – daling van het percentage positieve COVID-19-gevallen in de loop van de tijd voor een provincie in Florida. Je zou gemakkelijk de conclusie kunnen trekken dat het aantal gevallen afneemt. Dat is geweldig, de visualisatie geeft de gegevens nauwkeurig weer. Het probleem zit in de gegevens. Het is dus een meer verraderlijke vooringenomenheid omdat je het niet kunt zien. Het zit ingebakken in de data. De vragen die u moet stellen, zijn onder meer: wie wordt er getest? Met andere woorden, wat is de noemer, of de populatie waarvan we naar een percentage kijken. De aanname is dat het om de gehele populatie gaat, of in ieder geval om een representatieve steekproef.

In deze periode werden in deze provincie echter maar aan een beperkt aantal mensen tests afgenomen. Ze moesten COVID-achtige symptomen hebben, of waren onlangs naar een land op de lijst met hotspots gereisd. Bovendien verwarrend voor de resultaten is het feit dat elke positieve test werd geteld en elke negatieve test werd geteld. Wanneer een persoon positief testte, testten ze meestal opnieuw wanneer het virus zijn beloop had gehad en zouden ze negatief testen. Dus in zekere zin is er voor elk positief geval een negatief testgeval dat het opheft. De overgrote meerderheid van de tests is negatief en de negatieve tests van elk individu werden geteld. U kunt zien hoe de gegevens bevooroordeeld zijn en niet bijzonder nuttig zijn voor het nemen van beslissingen.

AI-invoer en training is bevooroordeeld

Er zijn op zijn minst twee manieren waarop AI tot vertekende resultaten kan leiden: te beginnen met bevooroordeelde gegevens of door bevooroordeelde algoritmen te gebruiken om geldige gegevens te verwerken.

Bevooroordeelde invoer

Velen van ons hebben de indruk dat AI kan worden vertrouwd om de cijfers te kraken, zijn algoritmen toe te passen en een betrouwbare analyse van de gegevens uit te voeren. Kunstmatige intelligentie kan alleen zo slim zijn als het is getraind. Als de gegevens waarop het is getraind niet perfect zijn, zijn de resultaten of conclusies ook niet te vertrouwen. Net als in het bovenstaande geval van enquêtebias, zijn er een aantal manieren waarop gegevens kunnen worden vooringenomen bij machinaal leren:.

- Steekproefbias - de trainingsdataset is niet representatief voor de hele populatie.

- Uitsluitingsbias - soms zijn wat uitschieters lijken, in werkelijkheid geldig, of waar we de grens trekken over wat moet worden opgenomen (postcodes, datums, enz.).

- Meetafwijking - de afspraak is om altijd te meten vanuit het midden en de onderkant van de meniscus, bijvoorbeeld bij het meten van vloeistoffen in maatkolven of reageerbuizen (behalve kwik).

- Recall bias - wanneer onderzoek afhankelijk is van het geheugen van de deelnemers.

- Observer bias - wetenschappers zijn, net als alle mensen, meer geneigd om te zien wat ze verwachten te zien.

- Seksistische en racistische vooroordelen – geslacht of ras kan over- of ondervertegenwoordigd zijn.

- Associatiebias - de gegevens versterken stereotypen

Om AI betrouwbare resultaten te geven, moeten de trainingsgegevens de echte wereld vertegenwoordigen. Zoals we in een vorig blogartikel hebben besproken, is de voorbereiding van gegevens van cruciaal belang en net als elk ander gegevensproject. Onbetrouwbare gegevens kunnen machine learning-systemen de verkeerde les leren en tot de verkeerde conclusie leiden. Dat gezegd hebbende: "Alle gegevens zijn bevooroordeeld. Dit is geen paranoia. Dit is een feit." – Dr Sanjiv M. Narayan, Stanford University School of Medicine.

Het gebruik van vooringenomen gegevens voor training heeft geleid tot een aantal opmerkelijke AI-storingen. (Voorbeelden hier en hier, Onderzoek hier..)

Bevooroordeelde algoritmen

Een algoritme is een set regels die invoer accepteren en uitvoer creëren om een zakelijk probleem te beantwoorden. Het zijn vaak goed gedefinieerde beslisbomen. Algoritmen voelen aan als zwarte dozen. Niemand weet zeker hoe ze werken, vaak zelfs de bedrijven die ze gebruiken. Oh, en ze zijn vaak eigendom. Hun mysterieuze en complexe aard is een van de redenen waarom bevooroordeelde algoritmen zo verraderlijk zijn. .

Denk aan AI-algoritmen in de geneeskunde, HR of financiën die rekening houden met ras. Als ras een factor is, kan het algoritme niet raciaal blind zijn. Dit is niet theoretisch. Dergelijke problemen zijn in de echte wereld ontdekt met behulp van AI in verhuring, rit-aandeel, aanvraag voor een lenings en niertransplantaties.

Waar het op neerkomt, is dat als uw gegevens of algoritmen slecht zijn, erger dan nutteloos zijn, ze gevaarlijk kunnen zijn. Er bestaat zoiets als een "algoritmische audit.” Het doel is om organisaties te helpen de potentiële risico's van het algoritme te identificeren met betrekking tot eerlijkheid, vooringenomenheid en discriminatie. Ergens anders, Facebook gebruikt AI om vooroordelen in AI te bestrijden.

Mensen zijn bevooroordeeld

We hebben mensen aan beide kanten van de vergelijking. Mensen bereiden de analyse voor en mensen ontvangen de informatie. Er zijn onderzoekers en er zijn lezers. Bij elke communicatie kunnen er problemen zijn bij het verzenden of ontvangen.

Neem bijvoorbeeld het weer. Wat betekent "kans op regen"? Ten eerste, wat bedoelen meteorologen als ze zeggen dat er kans is op regen? Volgens de Amerikaanse regering National Weather Service, een kans op regen, of wat ze Probability of Precipitation (PoP) noemen, is een van de minst begrepen elementen in een weersvoorspelling. Het heeft wel een standaarddefinitie: "De kans op neerslag is gewoon een statistische kans van 0.01″ inch [sic] meer [sic] meer neerslag in een bepaald gebied in het gegeven voorspellingsgebied in de gespecificeerde tijdsperiode." Het "gegeven gebied" is het prognosegebied, of broadgegoten gebied. Dat betekent dat de officiële kans op neerslag afhankelijk is van het vertrouwen dat het ergens in het gebied gaat regenen en het percentage van het gebied dat nat wordt. Met andere woorden, als de meteoroloog er zeker van is dat het gaat regenen in het voorspelde gebied (vertrouwen = 100%), dan vertegenwoordigt de PoP het deel van het gebied dat regen zal ontvangen.

Parijs straat; Regenachtige dagGustave Caillebotte (1848-1894) Chicago Art Institute Public Domain

De kans op regen hangt af van zowel het vertrouwen als de oppervlakte. Dat wist ik niet. Ik vermoed dat andere mensen dat ook niet weten. Ongeveer 75% van de bevolking begrijpt niet precies hoe PoP wordt berekend of wat het moet voorstellen. Dus worden we voor de gek gehouden, of is dit een perceptieprobleem. Laten we het neerslagperceptie noemen. Geven we de weersvoorspeller de schuld? Om eerlijk te zijn, er is wat verwarring ook onder weersvoorspellers. In een klanttevredenheid, zei 43% van de ondervraagde meteorologen dat er weinig consistentie is in de definitie van PoP.

De analyse zelf is bevooroordeeld

Van de vijf beïnvloedende factoren is de analyse zelf misschien wel de meest verrassende. In wetenschappelijk onderzoek dat resulteert in de publicatie van een beoordeeld artikel, wordt meestal een theorie verondersteld, worden methoden gedefinieerd om de hypothese te testen, worden gegevens verzameld en vervolgens worden de gegevens geanalyseerd. Het type analyse dat wordt gedaan en hoe het wordt gedaan, wordt ondergewaardeerd in hoe het de conclusies beïnvloedt. In een papier eerder dit jaar (januari 2022) gepubliceerd in het International Journal of Cancer, evalueerden de auteurs of resultaten van gerandomiseerde gecontroleerde studies en retrospectieve observationele studies. Hun bevindingen concludeerden dat,

Door analytische keuzes in vergelijkend effectiviteitsonderzoek te variëren, genereerden we tegengestelde uitkomsten. Onze resultaten suggereren dat sommige retrospectieve observationele studies kunnen vinden dat een behandeling de resultaten voor patiënten verbetert, terwijl een andere vergelijkbare studie dit niet kan vinden, simpelweg op basis van analytische keuzes.

Als je in het verleden een wetenschappelijk tijdschriftartikel las, dacht je misschien dat de resultaten of conclusies allemaal over de gegevens gaan. Nu lijkt het erop dat de resultaten, of de aanvankelijke hypothese wordt bevestigd of weerlegd, ook kunnen afhangen van de analysemethode.

Nog een studies vergelijkbare resultaten gevonden. Het artikel, Veel analisten, één dataset: transparant maken hoe variaties in analytische keuzes de resultaten beïnvloeden, beschrijft hoe ze dezelfde dataset aan 29 verschillende teams hebben gegeven om te analyseren. Data-analyse wordt vaak gezien als een strikt, goed gedefinieerd proces dat tot één conclusie leidt.

Ondanks de opmerkingen van methodologen, is het gemakkelijk om het feit over het hoofd te zien dat resultaten kunnen afhangen van de gekozen analytische strategie, die zelf doordrenkt is met theorie, aannames en keuzepunten. In veel gevallen zijn er veel redelijke (en veel onredelijke) benaderingen voor het evalueren van gegevens die betrekking hebben op een onderzoeksvraag.

De onderzoekers hebben de analyse van de gegevens gecrowdsourcet en kwamen tot de conclusie dat al het onderzoek subjectieve beslissingen omvat - inclusief welk type analyse te gebruiken - die de uiteindelijke uitkomst van het onderzoek kunnen beïnvloeden.

De aanbeveling van een ander onderzoeker die de bovenstaande studie analyseerde, moet voorzichtig zijn bij het gebruik van een enkel document bij het nemen van beslissingen of het trekken van conclusies.

Bias in Analytics aanpakken

Dit is gewoon bedoeld als een waarschuwend verhaal. Kennis kan ons beschermen tegen oplichting. Hoe beter we ons bewust zijn van mogelijke methoden die een scanner zou kunnen gebruiken om ons voor de gek te houden, hoe kleiner de kans dat we worden betrapt, bijvoorbeeld door een misleidende zakkenroller of het vlotte gepraat van een toneelstuk van Ponzi. Zo is het ook met het begrijpen en herkennen van mogelijke vooroordelen die van invloed zijn op onze analyses. Als we ons bewust zijn van mogelijke invloeden, kunnen we het verhaal misschien beter presenteren en uiteindelijk betere beslissingen nemen.