Analytics Løgn

Analysens skjevhet

Mark Twain sa diskutabelt noe sånt som: "Det er tre typer løgner: løgner, fordømte løgner og analytics».

Vi tar for gitt at analyser gir oss nyttig, handlingsdyktig innsikt. Det vi ofte ikke er klar over er hvordan våre egne og andres fordommer påvirker svarene vi får av selv den mest sofistikerte programvaren og systemene. Noen ganger kan vi bli manipulert uærlig, men mer vanlig kan det være subtile og ubevisste skjevheter som sniker seg inn i analysene våre. Motivasjonen bak partisk analyse er mangefold. Noen ganger påvirkes de upartiske resultatene vi forventer fra vitenskapen av 1) subtile valg i hvordan dataene presenteres, 2) inkonsistente eller ikke-representative data, 3) hvordan AI-systemer trenes, 4) uvitenhet, inkompetanse til forskere eller andre som prøver å fortelle historien, 5) selve analysen.

Presentasjonen er partisk

Noen av løgnene er lettere å få øye på enn andre. Når du vet hva du skal se etter, kan du lettere oppdage potensielt villedende grafer og diagrammer.

Det er minst fem måter å vise data på villedende: 1) Vis et begrenset datasett, 2). Vis urelaterte korrelasjoner, 3) Vis data unøyaktig, 4) Vis data ukonvensjonelt, eller 5). Vis data forenklet.

Vis et begrenset datasett

Å begrense dataene, eller velge en ikke-tilfeldig del av dataene, kan ofte fortelle en historie som ikke stemmer overens med det store bildet. Dårlig prøvetaking, eller kirsebærplukking, er når analytikeren bruker et ikke-representativt utvalg for å representere en større gruppe.

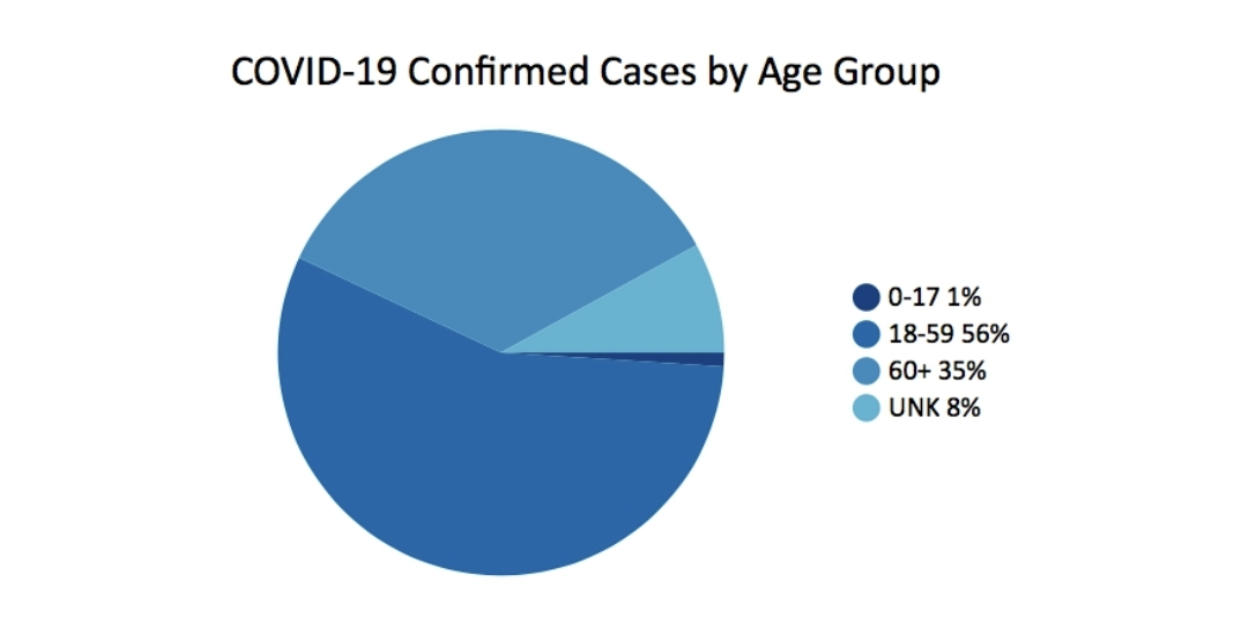

I mars 2020, Georgias avdeling for folkehelse publiserte dette diagrammet som en del av sin daglige statusrapport. Det reiser faktisk flere spørsmål enn det svarer.

En av tingene som mangler er kontekst. For eksempel vil det være nyttig å vite hvor stor prosentandel av befolkningen er for hver aldersgruppe. Et annet problem med det enkle kakediagrammet er de ujevne aldersgruppene. 0-17 har 18 år, 18-59 har 42, 60+ er åpen, men har rundt 40 år. Konklusjonen, gitt dette diagrammet alene, er at flertallet av tilfellene er i aldersgruppen 18-59 år. Aldersgruppen over 60 år ser ut til å være mindre alvorlig rammet av covid-tilfeller. Men dette er ikke hele historien.

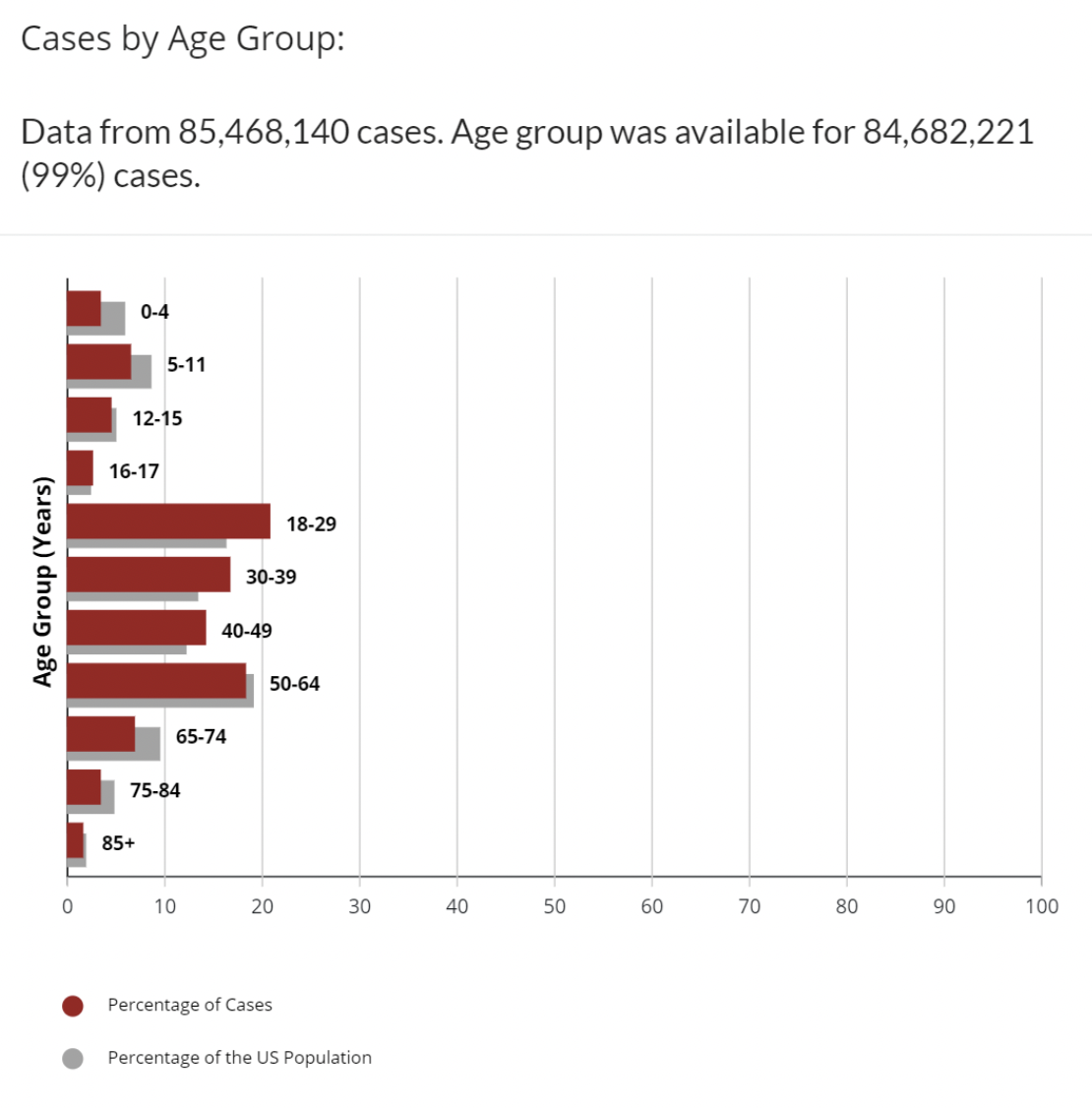

Til sammenligning, dette forskjellige datasettet på CDCs nettsted kartlegger COVID-tilfeller etter aldersgruppe med tilleggsdata om prosentandelen av USAs befolkning som er i hvert aldersgruppe.

Dette er bedre. Vi har mer kontekst. Vi kan se at aldersgruppene 18-29, 30-39, 40-49 alle har en høyere prosentandel av tilfeller enn andelen av aldersgruppen i befolkningen. Det er fortsatt noen ujevne aldersgrupper. Hvorfor er 16-17 en egen aldersgruppe? Fortsatt er ikke dette hele historien, men forståsegpåere har skrevet spalter, gitt spådommer og påbud om mindre enn dette. Åpenbart, med COVID, er det mange variabler i tillegg til alder som påvirker å bli regnet som et positivt tilfelle: vaksinasjonsstatus, tilgjengelighet av tester, antall ganger testet, komorbiditeter og mange andre. Antall saker i seg selv gir et ufullstendig bilde. De fleste eksperter ser også på antall dødsfall, eller prosentandeler av dødsfall per 100,000 XNUMX innbyggere, eller dødsulykker for å se på hvordan COVID påvirker hver aldersgruppe.

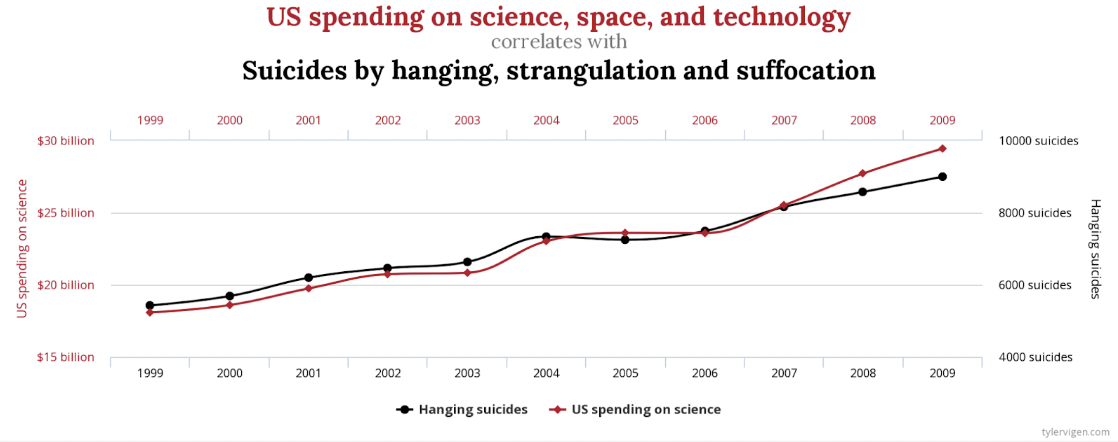

Vis urelaterte korrelasjoner

Det er åpenbart en sterk korrelasjon mellom USAs utgifter til vitenskap, rom og teknologi og antall selvmord ved henging, kvelning og kvelning. Korrelasjonen er 99.79 %, nesten en perfekt match.

Hvem vil imidlertid påstå at disse på en eller annen måte er relatert, eller det ene forårsaker det andre? Det finnes andre mindre ekstreme eksempler, men ikke mindre falske. Det er en lignende sterk korrelasjon mellom Letters in Winning Word of Scripps National Spelling Bee og antall mennesker drept av giftige edderkopper. Tilfeldigheter? Du bestemmer.

En annen måte å kartlegge disse dataene som kan være mindre misvisende, er å inkludere null på begge Y-aksene.

Vis data unøyaktig

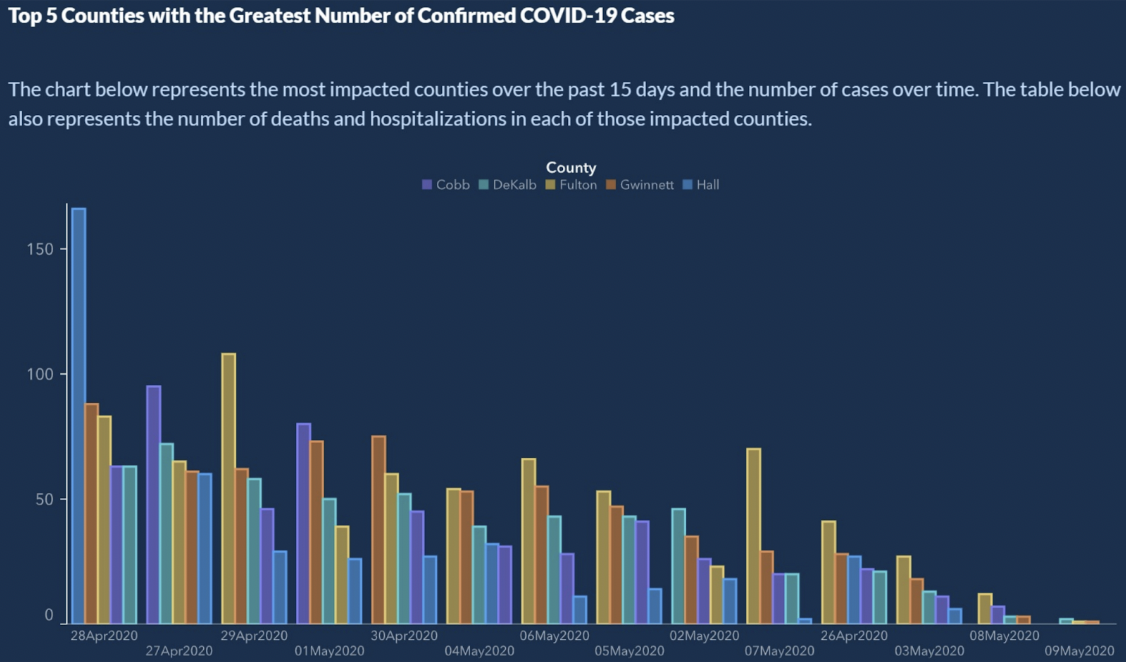

Fra Hvordan vise data dårlig, presenterte den amerikanske delstaten Georgia de 5 beste fylkene med det største antallet bekreftede COVID-19-tilfeller.

Ser legit ut, ikke sant? Det er tydelig en nedadgående trend av bekreftede COVID-19-tilfeller. Kan du lese X-aksen? X-aksen representerer tid. Vanligvis vil datoer øke fra venstre til høyre. Her ser vi en liten tidsreise på X-aksen:

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 ...

Vente? Hva? X-aksen er ikke sortert kronologisk. Så, hvor fin trenden enn ser ut, kan vi ikke trekke noen konklusjoner. Hvis datoene er bestilt, viser søylene for antall tilfeller mer et sagtannmønster enn noen form for trend.

Den enkle løsningen her er å sortere datoene slik en kalender gjør.

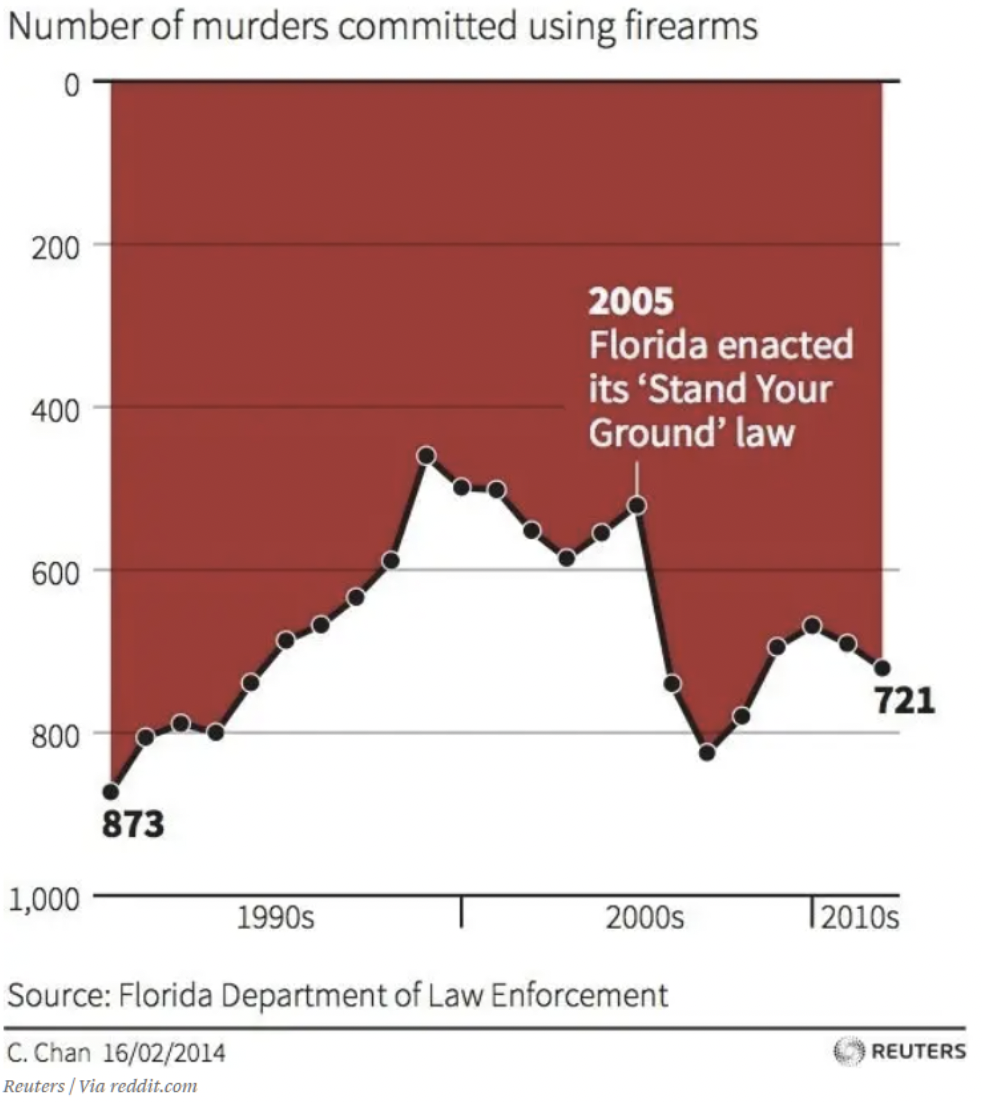

Vis data ukonvensjonelt

Vi er alle opptatt. Hjernen vår har lært oss å gjøre raske vurderinger basert på antakelser som har vært konsistente i vår verden. For eksempel viser hver graf jeg noen gang har sett x- og y-aksene som møtes på null eller laveste verdier. Hvis du ser kort på dette diagrammet, hvilke konklusjoner kan du trekke om effekten av Floridas «Stå på grunnloven din."? Jeg skammer meg over å innrømme det, men denne grafen lurte meg først. Øyet ditt trekkes beleilig til teksten og pilen i midten av grafikken. Ned er opp i denne grafen. Det er kanskje ikke løgn – dataene er i orden der. Men jeg må tro at det er ment å lure. Hvis du ikke har sett den ennå, er null på y-aksen øverst. Så, ettersom datatrender går ned, betyr det flere dødsfall. Dette diagrammet viser at antall drap ved bruk av skytevåpen økt etter 2005, antydet ved at trenden går ned.

Vis dataene forenklet

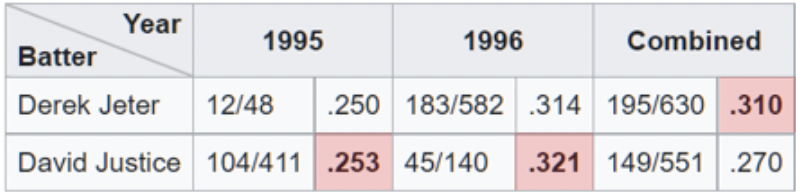

Et eksempel på overforenkling av dataene kan sees når analytikere drar nytte av Simpsons Paradox. Dette er et fenomen som oppstår når aggregerte data ser ut til å demonstrere en annen konklusjon enn når de er delt inn i undergrupper. Denne fellen er lett å gå i når man ser på aggregerte prosenter på høyt nivå. En av de tydeligste illustrasjonene av Simpsons paradoks på jobb er knyttet til slaggjennomsnitt.

Her ser vi at Derek Jeter har et høyere total slaggjennomsnitt enn David Justice for sesongene 1995 og 1996. Paradokset kommer inn når vi innser at Justice vant Jeter i slaggjennomsnitt begge disse årene. Hvis du ser nøye etter, er det fornuftig når du innser at Jeter hadde omtrent 4 ganger flere at-flaggermus (nevneren) i 1996 til et 007 lavere gjennomsnitt i 1996. Mens Justice hadde omtrent 10 ganger antall at-bats på bare . 003 høyere gjennomsnitt i 1995.

Presentasjonen fremstår som grei, men Simpsons paradoks, bevisst eller ubevisst, har ført til uriktige konklusjoner. Nylig har det vært eksempler på Simpsons paradoks i nyhetene og på sosiale medier relatert til vaksiner og COVID-dødelighet. En diagram viser en linjegraf som sammenligner dødsrater mellom vaksinerte og uvaksinerte for personer i alderen 10-59 år. Diagrammet viser at uvaksinerte konsekvent har lavere dødelighet. Hva foregår her?

Problemet ligner det vi ser med slaggjennomsnitt. Nevneren i dette tilfellet er antall individer i hver aldersgruppe. Grafen kombinerer grupper som har forskjellige utfall. Ser vi på den eldre aldersgruppen, 50-59 år, hver for seg, ser vi at de vaksinerte har det bedre. Likeledes, hvis vi ser på 10-49, ser vi også at de vaksinerte klarer seg bedre. Paradoksalt nok, når man ser på det kombinerte settet, ser uvaksinerte ut til å ha et dårligere resultat. På denne måten kan du argumentere for motsatte argumenter ved å bruke dataene.

Dataene er partiske

Data kan ikke alltid stole på. Selv i det vitenskapelige miljøet innrømmet over en tredjedel av de spurte forskerne "tvilsom forskningspraksis." En annen detektiv for forskningssvindel sier: "Det er høyst sannsynlig mye mer svindel i data - tabeller, linjegrafer, sekvenseringsdata [- enn vi faktisk oppdager]. Alle som sitter ved kjøkkenbordet kan legge inn noen tall i et regneark og lage en linjegraf som ser overbevisende ut.»

Dette første eksempel ser ut som noen gjorde akkurat det. Jeg sier ikke at dette er svindel, men som en undersøkelse genererer det bare ingen data som bidrar til en informert beslutning. Det ser ut til at undersøkelsen spurte respondentene om deres mening om bensinstasjonskaffe, eller en annen relevant aktuell hendelse.

- Superb

- Flott

- Veldig bra

Jeg har beskåret Twitter-innlegget for å fjerne referanser til den skyldige, men dette er hele oversikten over de endelige resultatene fra undersøkelsen. Slike undersøkelser er ikke uvanlige. Selvfølgelig vil ethvert diagram som er opprettet fra dataene fra svarene vise at den aktuelle kaffen ikke må gå glipp av.

Problemet er at hvis du hadde fått denne undersøkelsen og ikke fant et svar som passet med tankegangen din, ville du hoppet over undersøkelsen. Dette kan være et ekstremt eksempel på hvordan upålitelige data kan skapes. Dårlig undersøkelsesdesign kan imidlertid føre til færre svar og de som svarer har bare én mening, det er bare et spørsmål om grad. Dataene er partiske.

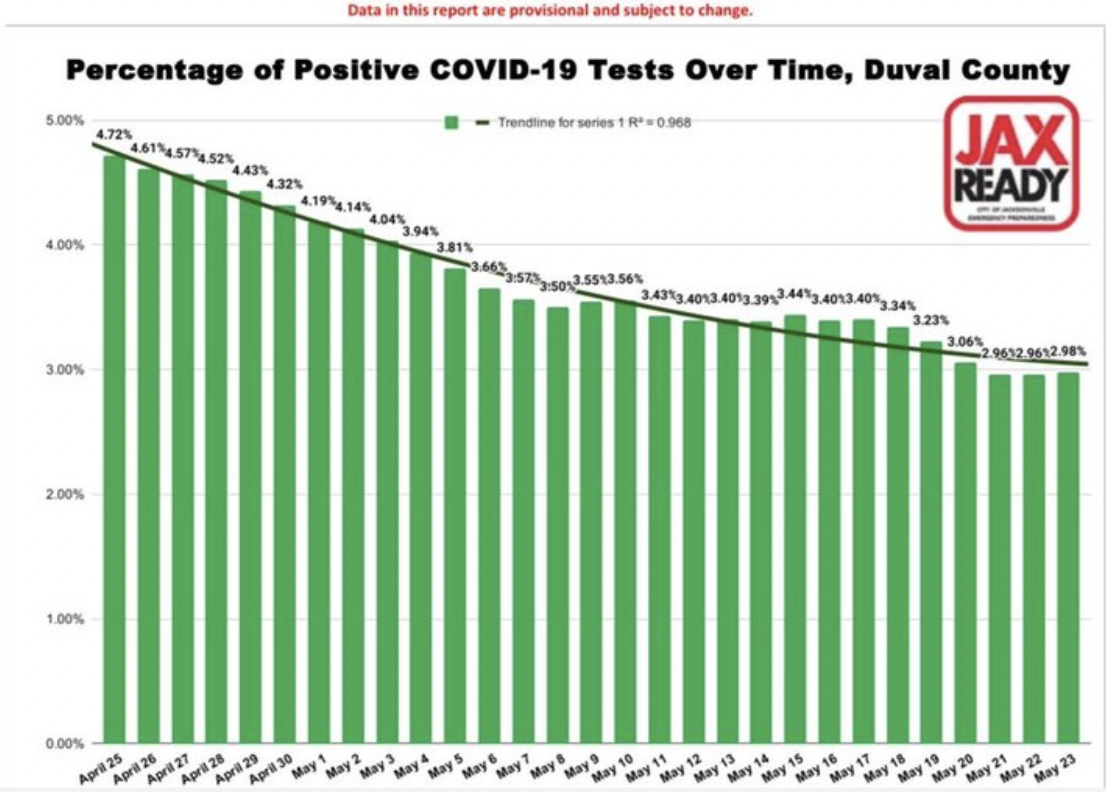

Dette andre eksemplet på databias er fra filene til "Verste COVID 19-villedende grafer».

Igjen, dette er subtilt og ikke helt åpenbart. Søylediagrammet viser en jevn – nesten for jevn – nedgang i prosentandelen av positive COVID-19-tilfeller over tid for et fylke i Florida. Du kan enkelt trekke den konklusjon at sakene går ned. Det er flott, visualiseringen representerer dataene nøyaktig. Problemet ligger i dataene. Så det er en mer lumsk skjevhet fordi du ikke kan se det. Det er bakt inn i dataene. Spørsmålene du må stille, inkluderer hvem som testes? Med andre ord, hva er nevneren, eller befolkningen som vi ser på en prosentandel av. Forutsetningen er at det er hele befolkningen, eller i det minste et representativt utvalg.

Men i løpet av denne perioden, i dette fylket, ble prøver bare gitt til et begrenset antall personer. De måtte ha covid-lignende symptomer, eller hadde nylig reist til et land på listen over hot spots. I tillegg forvirrende resultatene er det faktum at hver positiv test ble telt og hver negativ test ble telt. Vanligvis, når en person testet positivt, ville de teste igjen når viruset hadde gått sin gang og testet negativt. Så på en måte, for hvert positivt tilfelle, er det et negativt testtilfelle som kansellerer det. De aller fleste testene er negative og hver enkelts negative tester ble talt. Du kan se hvordan dataene er partiske og ikke spesielt nyttige for å ta beslutninger.

AI-inngang og opplæring er partisk

Det er minst to måter AI kan føre til forutinntatte resultater på: å starte med forutinntatte data, eller bruke forutinntatte algoritmer for å behandle gyldige data.

Forutinntatt input

Mange av oss er under inntrykk av at AI kan stole på for å knuse tallene, bruke algoritmene og spytte ut en pålitelig analyse av dataene. Kunstig intelligens kan bare være så smart som den er trent. Hvis dataene den er trent på er ufullkomne, vil heller ikke resultatene eller konklusjonene kunne stoles på. I likhet med tilfellet ovenfor med undersøkelsesskjevhet, er det en rekke måter data kan være på forutinntatt i maskinlæring:.

- Utvalgsskjevhet – opplæringsdatasettet er ikke representativt for hele befolkningen.

- Ekskluderingsskjevhet – noen ganger er det som ser ut til å være uteliggere faktisk gyldig, eller der vi trekker grensen for hva som skal inkluderes (postnummer, datoer, osv.).

- Måleskjevhet – konvensjonen er å alltid måle fra midten og bunnen av menisken, for eksempel ved måling av væsker i målekolber eller reagensrør (unntatt kvikksølv.)

- Recall bias – når forskning avhenger av deltakernes hukommelse.

- Observatørbias - forskere, som alle mennesker, er mer tilbøyelige til å se det de forventer å se.

- Sexistisk og rasistisk skjevhet – kjønn eller rase kan være over- eller underrepresentert.

- Assosiasjonsbias – dataene forsterker stereotypier

For at AI skal gi pålitelige resultater, må treningsdataene representere den virkelige verden. Som vi har diskutert i en tidligere bloggartikkel, er utarbeidelsen av data kritisk og som alle andre dataprosjekter. Upålitelige data kan lære maskinlæringssystemer feil leksjon og vil resultere i feil konklusjon. Når det er sagt, "Alle data er partiske. Dette er ikke paranoia. Dette er fakta." – Dr. Sanjiv M. Narayan, Stanford University School of Medicine.

Bruk av partiske data til trening har ført til en rekke bemerkelsesverdige AI-feil. (Eksempler her. og her., forskning her...)

Forutinntatte algoritmer

En algoritme er et sett med regler som aksepterer et input og skaper utdata for å svare på et forretningsproblem. De er ofte veldefinerte beslutningstrær. Algoritmer føles som svarte bokser. Ingen er sikker på hvordan de fungerer, ofte, ikke engang selskaper som bruker dem. Å, og de er ofte proprietære. Deres mystiske og komplekse natur er en av grunnene til at partiske algoritmer er så lumske. .

Vurder AI-algoritmer innen medisin, HR eller finans som tar rase i betraktning. Hvis rase er en faktor, kan ikke algoritmen være raseblind. Dette er ikke teoretisk. Problemer som disse har blitt oppdaget i den virkelige verden ved å bruke AI i ansette, ride-share, Lånesøknads, og nyretransplantasjoner.

Poenget er at hvis dataene eller algoritmene dine er dårlige, er verre enn ubrukelige, kan de være farlige. Det er noe som heter "algoritmisk revisjon." Målet er å hjelpe organisasjoner med å identifisere potensielle risikoer knyttet til algoritmen når det gjelder rettferdighet, skjevhet og diskriminering. Andre steder, Facebook bruker AI for å bekjempe skjevhet i AI.

Folk er partiske

Vi har folk på begge sider av ligningen. Folk forbereder analysen og folk mottar informasjonen. Det er forskere og det er lesere. I enhver kommunikasjon kan det være problemer med overføring eller mottak.

Ta været, for eksempel. Hva betyr "en sjanse for regn"? For det første, hva mener meteorologer når de sier at det er en sjanse for regn? Ifølge den amerikanske regjeringen National Weather Service, en sjanse for regn, eller det de kaller Probability of Precipitation (PoP), er et av de minst forståtte elementene i en værmelding. Den har en standarddefinisjon: "Sannsynligheten for nedbør er ganske enkelt en statistisk sannsynlighet på 0.01" [sic] av [sic] mer nedbør i et gitt område i det gitte prognoseområdet i den angitte tidsperioden." Det "gitte området" er prognoseområdet, eller broadstøpt område. Det betyr at den offisielle sannsynligheten for nedbør avhenger av tilliten til at det vil regne et sted i området og prosentandelen av området som vil bli vått. Med andre ord, hvis meteorologen er sikker på at det kommer til å regne i prognoseområdet (Confidence = 100%), representerer PoP den delen av området som vil motta regn.

Paris Street; Regnfull dag, Gustave Caillebotte (1848-1894) Chicago Art Institute Public Domain

Sjansen for regn avhenger av både selvtillit og område. Jeg visste ikke at. Jeg mistenker at andre ikke vet det heller. Omtrent 75 % av befolkningen forstår ikke nøyaktig hvordan PoP beregnes, eller hva det er ment å representere. Så blir vi lurt, eller er dette et problem med persepsjon. La oss kalle det nedbørpersepsjon. Skyller vi på værmelderen? For å være rettferdig er det noen forvirring også blant værvarslere. I en Undersøkelsen43 % av de undersøkte meteorologene sa at det er veldig lite konsistens i definisjonen av PoP.

Selve analysen er partisk

Av de fem påvirkningsfaktorene kan selve analysen være den mest overraskende. I vitenskapelig forskning som resulterer i at en gjennomgått artikkel publiseres, er det typisk hypoteser om en teori, metoder er definert for å teste hypotesen, data samles inn, deretter analyseres dataene. Hvilken type analyse som gjøres og hvordan den gjøres er undervurdert i hvordan den påvirker konklusjonene. I en papir publisert tidligere i år (januar 2022), i International Journal of Cancer, evaluerte forfatterne om resultater fra randomiserte kontrollerte studier og retrospektive observasjonsstudier. Funnene deres konkluderte med at

Ved å variere analytiske valg i komparativ effektivitetsforskning, genererte vi motsatte resultater. Våre resultater tyder på at noen retrospektive observasjonsstudier kan finne at en behandling forbedrer resultatene for pasienter, mens en annen lignende studie kan finne at den ikke gjør det, bare basert på analytiske valg.

I det siste, når du leser en vitenskapelig tidsskriftartikkel, hvis du er som meg, har du kanskje trodd at resultatene eller konklusjonene handler om dataene. Nå ser det ut til at resultatene, eller om den første hypotesen er bekreftet eller tilbakevist, også kan avhenge av analysemetoden.

En annen studere fant lignende resultater. Artikkelen, Mange analytikere, ett datasett: Å gjøre gjennomsiktig hvordan variasjoner i analytiske valg påvirker resultater, beskriver hvordan de ga det samme datasettet til 29 forskjellige team å analysere. Dataanalyse blir ofte sett på som en streng, veldefinert prosess som fører til en enkelt konklusjon.

Til tross for metodologers remonstrasjoner, er det lett å overse det faktum at resultater kan avhenge av den valgte analytiske strategien, som i seg selv er gjennomsyret av teori, antagelser og valgpunkter. I mange tilfeller er det mange rimelige (og mange urimelige) tilnærminger til å evaluere data som har betydning for et forskningsspørsmål.

Forskerne hentet analysen av dataene og kom til den konklusjonen at all forskning inkluderer subjektive avgjørelser – inkludert hvilken type analyse de skal bruke – som kan påvirke det endelige resultatet av studien.

En annens anbefaling forsker hvem som har analysert studien ovenfor, må være forsiktige når de bruker et enkelt papir for å ta beslutninger eller trekke konklusjoner.

Adressering av skjevhet i Analytics

Dette er rett og slett ment å være en advarende historie. Kunnskap kan beskytte oss mot å bli tatt inn av svindel. Jo mer bevisst på mulige metoder en skanner kan bruke for å lure oss, jo mindre sannsynlig er det at vi blir tatt i, for eksempel, av en lommetyvs feilretning, eller den jevne snakk om et Ponzi-spill. Slik er det med å forstå og gjenkjenne potensielle skjevheter som påvirker analysene våre. Hvis vi er klar over potensielle påvirkninger, kan vi kanskje presentere historien bedre og til slutt ta bedre beslutninger.