Mensonge analytique

Le biais d'analyse

Mark Twain a dit de façon discutable quelque chose comme : « Il y a trois sortes de mensonges : les mensonges, les maudits mensonges et analytique. »

Nous tenons pour acquis que l'analyse nous donne des informations utiles et exploitables. Ce que nous ne réalisons souvent pas, c'est à quel point nos propres préjugés et ceux des autres influencent les réponses que nous donnent même les logiciels et les systèmes les plus sophistiqués. Parfois, nous pouvons être manipulés de manière malhonnête, mais, plus souvent, ce peuvent être des préjugés subtils et inconscients qui se glissent dans nos analyses. La motivation derrière les analyses biaisées est multiple. Parfois, les résultats impartiaux que nous attendons de la science sont influencés par 1) des choix subtils dans la façon dont les données sont présentées, 2) des données incohérentes ou non représentatives, 3) la façon dont les systèmes d'IA sont formés, 4) l'ignorance, l'incompétence des chercheurs ou d'autres personnes essayant pour raconter l'histoire, 5) l'analyse elle-même.

La présentation est biaisée

Certains mensonges sont plus faciles à repérer que d'autres. Lorsque vous savez ce qu'il faut rechercher, vous pouvez détecter plus facilement graphiques et tableaux trompeurs.

Il ya au moins cinq façons d'afficher des données de manière trompeuse: 1) Afficher un ensemble de données limité, 2). Afficher des corrélations non liées, 3) Afficher des données de manière inexacte, 4) Afficher des données de manière non conventionnelle, ou 5). Afficher les données trop simplifiées.

Afficher un ensemble de données limité

Limiter les données ou sélectionner manuellement une section non aléatoire des données peut souvent raconter une histoire qui n'est pas cohérente avec la situation dans son ensemble. Un mauvais échantillonnage, ou cueillette de cerises, se produit lorsque l'analyste utilise un échantillon non représentatif pour représenter un groupe plus important.

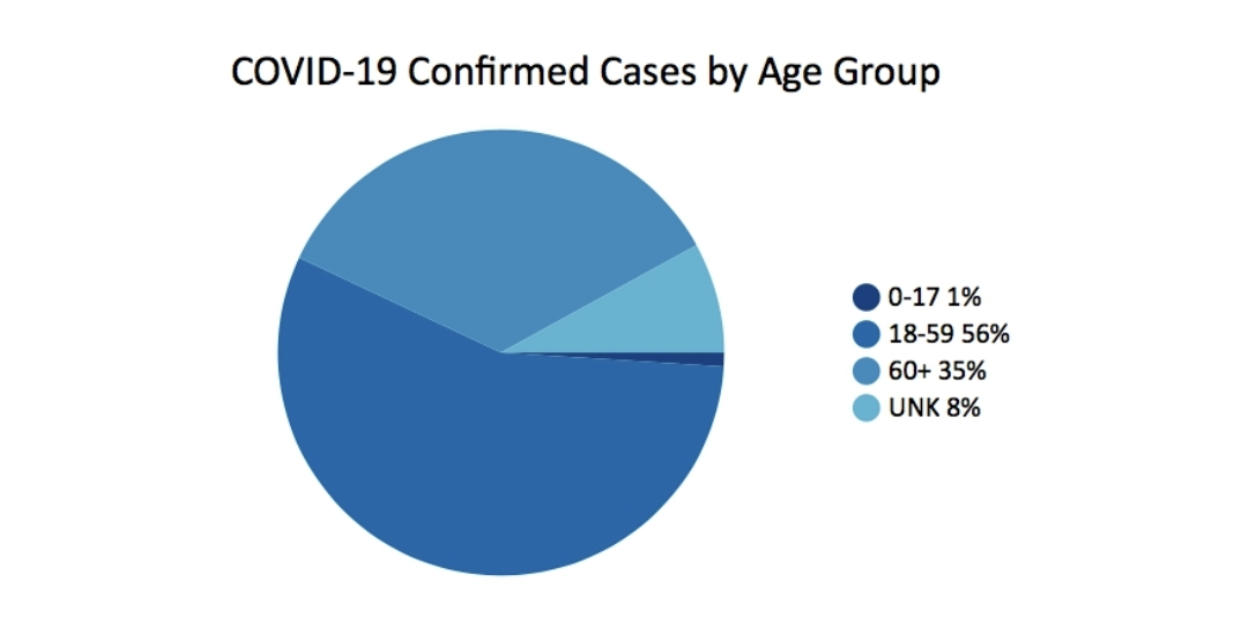

En Mars 2020, Département de la santé publique de Géorgie a publié ce graphique dans le cadre de son rapport de situation quotidien. Il soulève en fait plus de questions qu'il n'apporte de réponses.

Une des choses qui manque est le contexte. Par exemple, il serait utile de savoir quel est le pourcentage de la population pour chaque groupe d'âge. Un autre problème avec le graphique à secteurs simple est les groupes d'âge inégaux. Le 0-17 a 18 ans, le 18-59 en a 42, le 60+ est ouvert, mais a environ 40 ans. La conclusion, compte tenu de ce seul graphique, est que la majorité des cas se situent dans le groupe d'âge des 18 à 59 ans. Le groupe d'âge des plus de 60 ans semble être moins gravement touché par les cas de COVID. Mais ce n'est pas toute l'histoire.

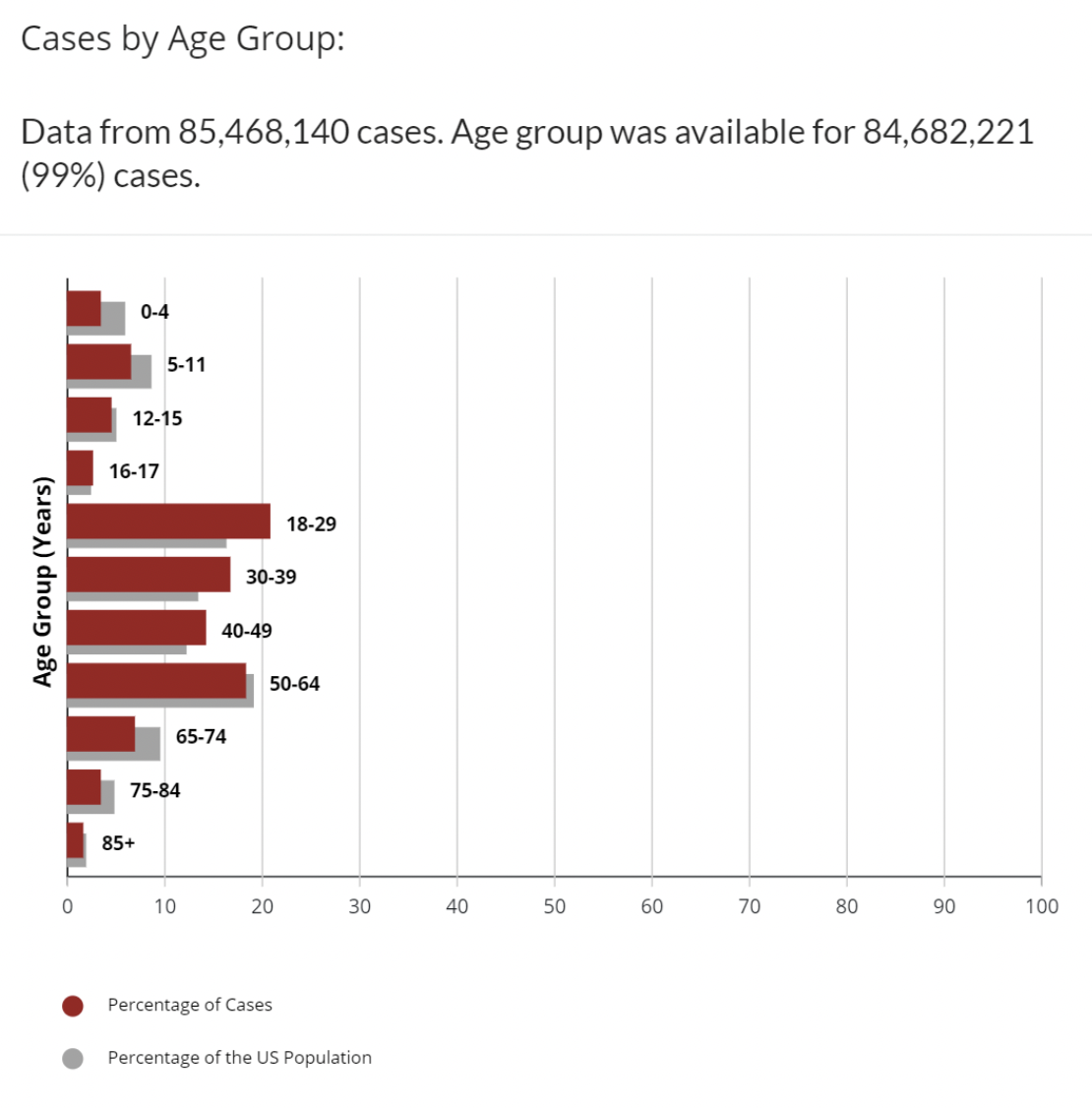

A titre de comparaison, cet ensemble de données différent sur le Site Internet du CDC trace les cas de COVID par groupe d'âge avec les données supplémentaires sur le pourcentage de la population américaine qui se trouve dans chaque tranche d'âge.

C'est mieux. Nous avons plus de contexte. Nous pouvons voir que les groupes d'âge 18-29, 30-39, 40-49 ont tous un pourcentage de cas plus élevé que le pourcentage du groupe d'âge dans la population. Il existe encore des tranches d'âge inégales. Pourquoi les 16-17 ans constituent-ils un groupe d'âge distinct ? Ce n'est pas toute l'histoire, mais les experts ont écrit des colonnes, fait des prédictions et des mandats sur moins que cela. Évidemment, avec le COVID, il existe de nombreuses variables en plus de l'âge qui affectent le fait d'être compté comme un cas positif : statut vaccinal, disponibilité des tests, nombre de fois testés, comorbidités et bien d'autres. Le nombre de cas, en lui-même, fournit une image incomplète. La plupart des experts examinent également le nombre de décès, ou les pourcentages de décès pour 100,000 XNUMX habitants, ou les cas de décès pour examiner comment le COVID affecte chaque groupe d'âge.

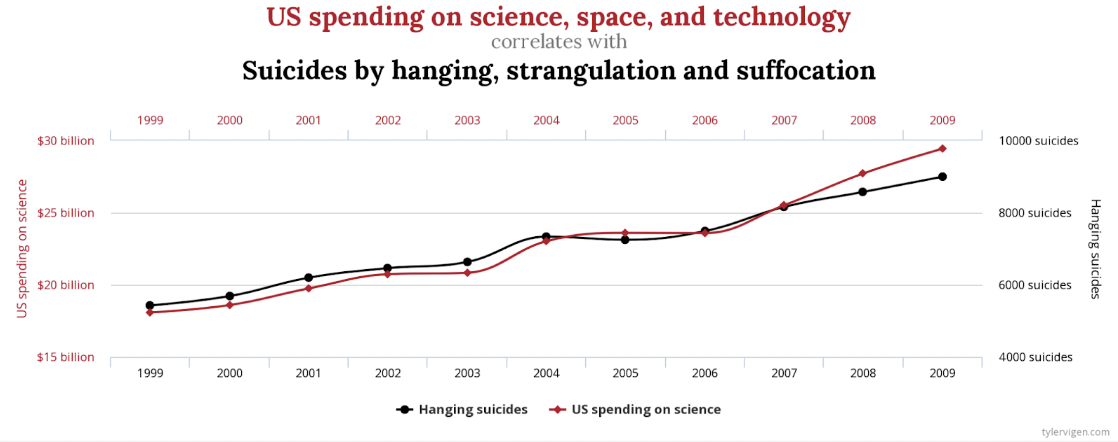

Afficher les corrélations non liées

Évidemment, il y a un forte corrélation entre les dépenses américaines pour la science, l'espace et la technologie et le nombre de suicides par pendaison, strangulation et suffocation. La corrélation est de 99.79 %, une correspondance presque parfaite.

Qui, cependant, ferait valoir que ceux-ci sont liés d'une manière ou d'une autre, ou que l'un cause l'autre? Il existe d'autres exemples moins extrêmes, mais non moins fallacieux. Il existe une forte corrélation similaire entre les lettres dans le mot gagnant de Scripps National Spelling Bee et le nombre de personnes tuées par des araignées venimeuses. Hasard? Tu décides.

Une autre façon de représenter graphiquement ces données qui pourraient être moins trompeuses serait d'inclure zéro sur les deux axes Y.

Afficher les données de manière inexacte

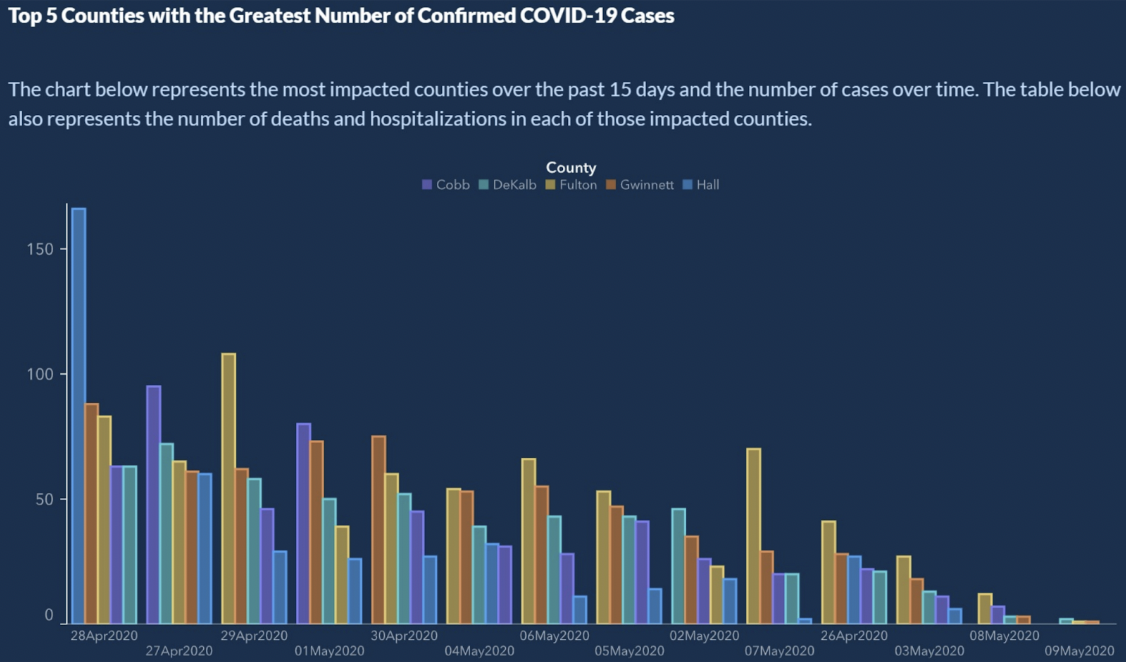

Du Comment mal afficher les données, l'État américain de Géorgie a présenté les 5 principaux comtés avec le plus grand nombre de cas confirmés de COVID-19.

Ça a l'air légitime, non ? Il y a clairement une tendance à la baisse des cas confirmés de COVID-19. Pouvez-vous lire l'axe X ? L'axe X représente le temps. En règle générale, les dates augmentent de gauche à droite. Ici, on voit un petit voyage dans le temps sur l'axe X :

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 ...

Attendre? Quoi? L'axe X n'est pas trié chronologiquement. Donc, aussi belle que puisse paraître la tendance, nous ne pouvons tirer aucune conclusion. Si les dates sont ordonnées, les barres du nombre de cas montrent plus un motif en dents de scie que n'importe quel type de tendance.

La solution la plus simple consiste à trier les dates comme le fait un calendrier.

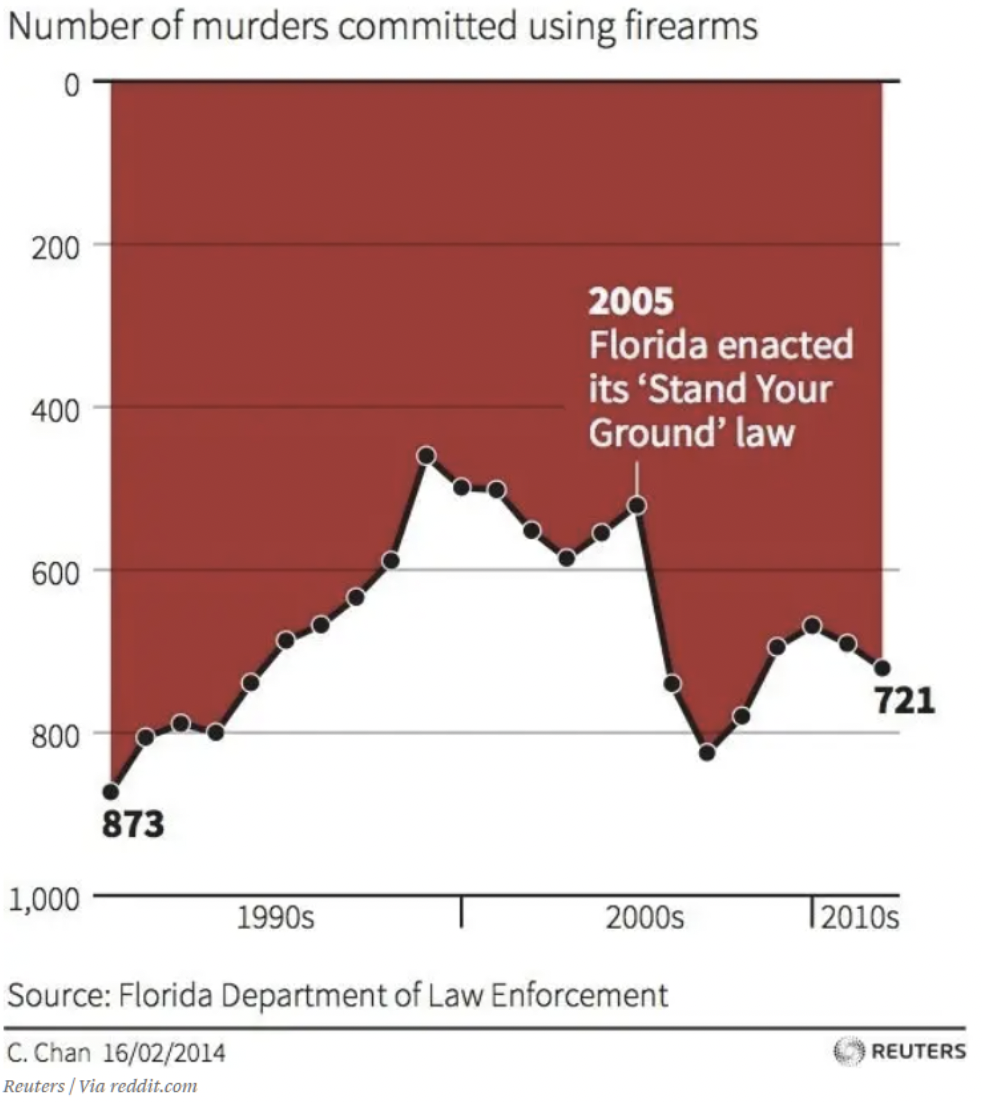

Afficher les données de manière non conventionnelle

Nous sommes tous occupés. Notre cerveau nous a appris à porter des jugements rapides basés sur des hypothèses qui ont été cohérentes dans notre monde. Par exemple, chaque graphique que j'ai jamais vu montre les axes x et y se rencontrant à zéro ou aux valeurs les plus basses. En examinant brièvement ce graphique, quelles conclusions pouvez-vous tirer de l'effet de la Floride « Respectez votre loi fondamentale.” ? J'ai honte de l'admettre, mais ce graphique m'a trompé au début. Votre œil est commodément attiré par le texte et la flèche au milieu du graphique. Bas est haut dans ce graphique. Ce n'est peut-être pas un mensonge - les données sont bien là. Mais, je dois penser que c'est destiné à tromper. Si vous ne l'avez pas encore vu, zéro sur l'axe y est en haut. Ainsi, à mesure que les données baissent, cela signifie plus de décès. Ce graphique montre que le nombre de meurtres à l'aide d'armes à feu increased après 2005, indiqué par la tendance allant down.

Afficher les données trop simplifiées

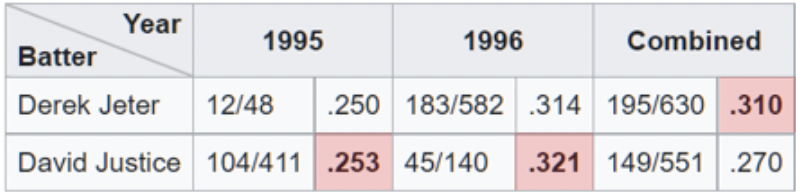

Un exemple de simplification excessive des données peut être observé lorsque les analystes profitent du paradoxe de Simpson. Il s'agit d'un phénomène qui se produit lorsque des données agrégées semblent démontrer une conclusion différente que lorsqu'elles sont séparées en sous-ensembles. Il est facile de tomber dans ce piège lorsqu'on examine des pourcentages agrégés de haut niveau. L'une des illustrations les plus claires du paradoxe de Simpson au travail est liée à moyennes au bâton.

Ici, nous voyons que Derek Jeter a une moyenne au bâton globale plus élevée que David Justice pour les saisons 1995 et 1996. Le paradoxe survient lorsque nous réalisons que Justice a battu Jeter en moyenne au bâton ces deux années. Si vous regardez attentivement, cela a du sens lorsque vous réalisez que Jeter avait environ 4 fois plus d'at-bats (le dénominateur) en 1996 à une moyenne inférieure de 007 en 1996. Alors que Justice avait environ 10 fois plus d'at-bats à seulement . 003 moyenne plus élevée en 1995.

La présentation semble simple, mais le paradoxe de Simpson, sciemment ou non, a conduit à des conclusions incorrectes. Récemment, il y a eu des exemples du paradoxe de Simpson dans les nouvelles et sur les réseaux sociaux liés aux vaccins et à la mortalité par COVID. Une tracer montre un graphique linéaire comparant les taux de mortalité entre vaccinés et non vaccinés pour les personnes âgées de 10 à 59 ans. Le graphique montre que les personnes non vaccinées ont systématiquement un taux de mortalité plus faible. Que se passe t-il ici?

Le problème est similaire à celui que nous voyons avec les moyennes au bâton. Le dénominateur dans ce cas est le nombre d'individus dans chaque groupe d'âge. Le graphique combine des groupes qui ont des résultats différents. Si nous regardons la tranche d'âge plus âgée, 50-59 ans, séparément, nous voyons que les vaccinés s'en sortent mieux. De même, si on regarde 10-49, on voit aussi que les vaccinés s'en sortent mieux. Paradoxalement, lorsque l'on regarde l'ensemble combiné, les non vaccinés semblent avoir un moins bon résultat. De cette façon, vous êtes en mesure de faire valoir des arguments opposés en utilisant les données.

Les données sont biaisées

Les données ne sont pas toujours fiables. Même dans la communauté scientifique, plus d'un tiers des chercheurs interrogés admettent "pratiques de recherche douteuses". Une autre détective de recherche sur la fraude dit: «Il y a très probablement beaucoup plus de fraude dans les données - tableaux, graphiques linéaires, données de séquençage [– que nous n'en découvrons réellement]. Toute personne assise à sa table de cuisine peut mettre des chiffres dans une feuille de calcul et créer un graphique linéaire qui semble convaincant. »

Ce premier exemple on dirait que quelqu'un a fait ça. Je ne dis pas que c'est de la fraude, mais en tant qu'enquête, cela ne génère tout simplement aucune donnée qui contribue à une décision éclairée. Il semble que l'enquête ait interrogé les répondants sur leur opinion sur le café de la station-service ou sur un autre événement d'actualité pertinent.

- Superbe

- Great

- très bon

J'ai recadré le message Twitter pour supprimer les références au coupable, mais il s'agit du tableau complet des résultats finaux de l'enquête. Des enquêtes comme celle-ci ne sont pas rares. Évidemment, tout graphique créé à partir des données résultant des réponses montrera que le café en question est à ne pas manquer.

Le problème est que si vous aviez reçu cette enquête et que vous n'aviez pas trouvé de réponse correspondant à votre réflexion, vous sauteriez l'enquête. Cela peut être un exemple extrême de la façon dont des données non fiables peuvent être créées. Une mauvaise conception de l'enquête, cependant, peut entraîner moins de réponses et ceux qui répondent n'ont qu'une opinion, ce n'est qu'une question de degré. Les données sont biaisées.

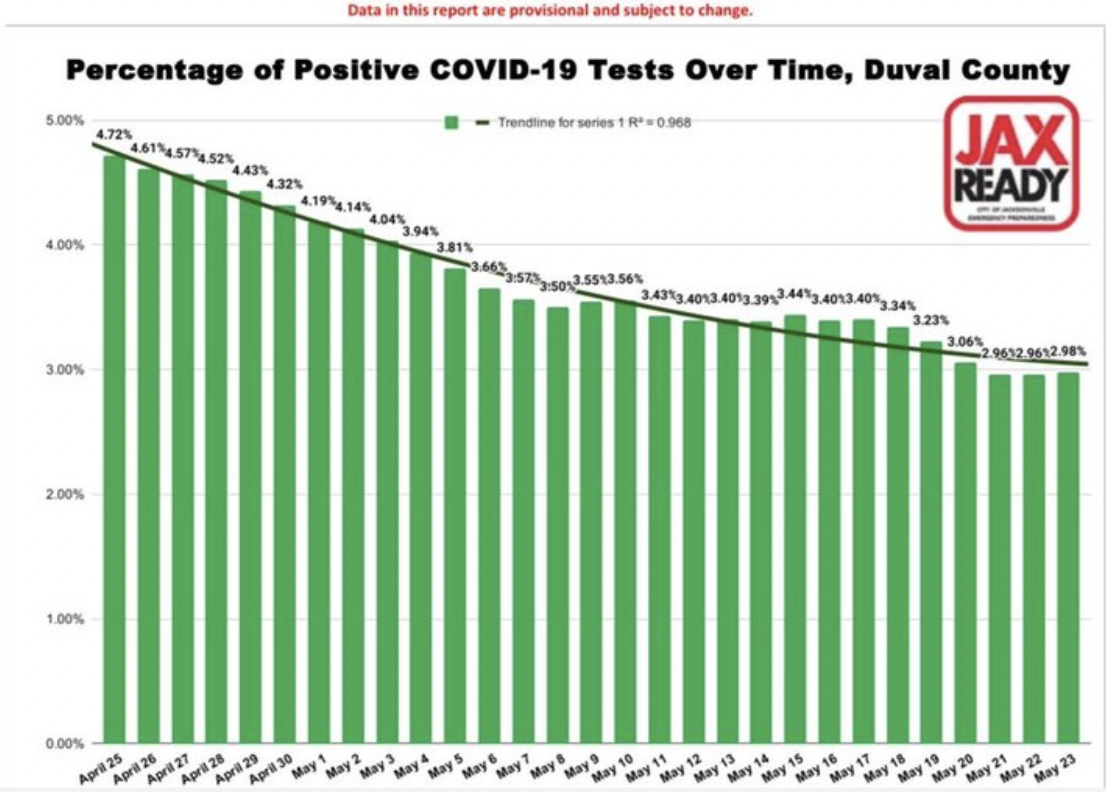

Ce deuxième exemple de biais de données provient des fichiers de "Les pires graphiques trompeurs COVID 19. »

Encore une fois, c'est subtil et pas complètement évident. Le graphique à barres montre une baisse régulière – presque trop régulière – du pourcentage de cas positifs de COVID-19 au fil du temps pour un comté de Floride. Vous pourriez facilement tirer la conclusion que les cas sont en baisse. C'est super, la visualisation représente fidèlement les données. Le problème est dans les données. Donc, c'est un biais plus insidieux parce que vous ne pouvez pas le voir. C'est intégré aux données. Les questions que vous devez poser incluent, qui est testé ? En d'autres termes, quel est le dénominateur, ou la population dont nous regardons un pourcentage. L'hypothèse est qu'il s'agit de l'ensemble de la population, ou du moins, d'un échantillon représentatif.

Cependant, pendant cette période, dans ce comté, les tests n'ont été administrés qu'à un nombre limité de personnes. Ils devaient avoir des symptômes de type COVID ou avaient voyagé récemment dans un pays figurant sur la liste des points chauds. De plus, le fait que chaque test positif a été compté et que chaque test négatif a été compté constitue une confusion supplémentaire dans les résultats. En règle générale, lorsqu'un individu était testé positif, il testait à nouveau lorsque le virus avait suivi son cours et était négatif. Donc, en un sens, pour chaque cas positif, il y a un cas test négatif qui l'annule. La grande majorité des tests sont négatifs et les tests négatifs de chaque individu ont été comptés. Vous pouvez voir comment les données sont biaisées et pas particulièrement utiles pour prendre des décisions.

L'entrée et la formation de l'IA sont biaisées

L'IA peut conduire à des résultats biaisés au moins de deux manières : en commençant par des données biaisées ou en utilisant des algorithmes biaisés pour traiter des données valides.

Entrée biaisée

Beaucoup d'entre nous ont l'impression qu'on peut faire confiance à l'IA pour calculer les chiffres, appliquer ses algorithmes et cracher une analyse fiable des données. L'intelligence artificielle ne peut être aussi intelligente que si elle est entraînée. Si les données sur lesquelles il est formé sont imparfaites, les résultats ou les conclusions ne pourront pas non plus être fiables. Semblable au cas ci-dessus du biais d'enquête, il existe un certain nombre de façons dont les données peuvent être biaisé en apprentissage automatique :.

- Biais d'échantillon - l'ensemble de données de formation n'est pas représentatif de l'ensemble de la population.

- Biais d'exclusion - parfois, ce qui semble être des valeurs aberrantes est en fait valide, ou, où nous traçons la ligne sur ce qu'il faut inclure (codes postaux, dates, etc.).

- Biais de mesure - la convention est de toujours mesurer à partir du centre et du bas du ménisque, par exemple, lors de la mesure de liquides dans des fioles jaugées ou des tubes à essai (sauf le mercure.)

- Biais de rappel – lorsque la recherche dépend de la mémoire des participants.

- Biais d'observateur - les scientifiques, comme tous les humains, sont plus enclins à voir ce qu'ils s'attendent à voir.

- Préjugés sexistes et racistes – le sexe ou la race peuvent être sur- ou sous-représentés.

- Biais d'association - les données renforcent les stéréotypes

Pour que l'IA renvoie des résultats fiables, ses données d'entraînement doivent représenter le monde réel. Comme nous en avons discuté dans un article de blog précédent, la préparation des données est essentielle et comme tout autre projet de données. Des données non fiables peuvent enseigner aux systèmes d'apprentissage automatique la mauvaise leçon et entraîner une mauvaise conclusion. Cela dit, « toutes les données sont biaisées. Ce n'est pas de la paranoïa. C'est un fait." – Dr Sanjiv M. Narayan, École de médecine de l'Université de Stanford.

L'utilisation de données biaisées pour la formation a conduit à un certain nombre d'échecs notables de l'IA. (Exemples ici ainsi que ici, recherche ici..)

Algorithmes biaisés

Un algorithme est un ensemble de règles qui acceptent une entrée et créent une sortie pour répondre à un problème métier. Ce sont souvent des arbres de décision bien définis. Les algorithmes ressemblent à des boîtes noires. Personne n'est sûr de leur fonctionnement, souvent, pas même le entreprises qui les utilisent. Oh, et ils sont souvent propriétaires. Leur nature mystérieuse et complexe est l'une des raisons pour lesquelles les algorithmes biaisés sont si insidieux. .

Considérez les algorithmes d'IA en médecine, en RH ou en finance qui tiennent compte de la race. Si la race est un facteur, l'algorithme ne peut pas être aveugle à la race. Ce n'est pas théorique. Des problèmes comme ceux-ci ont été découverts dans le monde réel en utilisant l'IA dans embauche, covoiturage, demande de prêts, et greffes de rein.

En fin de compte, si vos données ou vos algorithmes sont mauvais, pires qu'inutiles, ils peuvent être dangereux. Il existe une chose telle qu'un "audit algorithmique.” L'objectif est d'aider les organisations à identifier les risques potentiels liés à l'algorithme en ce qui concerne l'équité, les préjugés et la discrimination. Autre part, Facebook utilise l'IA pour lutter contre les préjugés dans l'IA.

Les gens sont biaisés

Nous avons des gens des deux côtés de l'équation. Les gens préparent l'analyse et les gens reçoivent l'information. Il y a des chercheurs et il y a des lecteurs. Dans toute communication, il peut y avoir des problèmes de transmission ou de réception.

Prenez la météo, par exemple. Que signifie « un risque de pluie » ? Premièrement, que veulent dire les météorologues lorsqu'ils disent qu'il y a un risque de pluie ? Selon le gouvernement américain National Weather Service, un risque de pluie, ou ce qu'ils appellent la probabilité de précipitation (PoP), est l'un des éléments les moins compris dans une prévision météorologique. Il a une définition standard : "La probabilité de précipitations est simplement une probabilité statistique de 0.01 pouce [sic] de [sic] plus de précipitations dans une zone donnée dans la zone de prévision donnée au cours de la période spécifiée." La "zone donnée" est la zone de prévision, ou broadzone de fonte. Cela signifie que la probabilité officielle de précipitation dépend de la certitude qu'il pleuvra quelque part dans la région et du pourcentage de la région qui sera mouillée. En d'autres termes, si le météorologue est convaincu qu'il va pleuvoir dans la zone de prévision (Confiance = 100%), alors la PoP représente la partie de la zone qui recevra de la pluie.

Rue de Paris ; Jour de pluie,Gustave Caillebotte (1848-1894) Domaine public du Chicago Art Institute

Le risque de pluie dépend à la fois de la confiance et de la zone. Je ne le savais pas. Je soupçonne que d'autres personnes ne le savent pas non plus. Environ 75 % de la population ne comprend pas exactement comment la PoP est calculée ou ce qu'elle est censée représenter. Alors, sommes-nous dupés, ou, est-ce un problème de perception. Appelons cela la perception des précipitations. Faut-il blâmer le météorologue ? Pour être juste, il y a quelques confusion parmi les météorologues aussi. Dans une enquête, 43 % des météorologues interrogés ont déclaré qu'il y avait très peu de cohérence dans la définition de PoP.

L'analyse elle-même est biaisée

Parmi les cinq facteurs d'influence, l'analyse elle-même est peut-être la plus surprenante. Dans la recherche scientifique qui aboutit à la publication d'un article révisé, une théorie est généralement émise comme hypothèse, des méthodes sont définies pour tester l'hypothèse, des données sont collectées, puis les données sont analysées. Le type d'analyse qui est effectuée et la façon dont elle est effectuée sont sous-estimés dans la façon dont cela affecte les conclusions. Dans un papier publié plus tôt cette année (janvier 2022), dans l'International Journal of Cancer, les auteurs ont évalué si les résultats des essais contrôlés randomisés et des études observationnelles rétrospectives. Leurs conclusions ont conclu que,

En faisant varier les choix analytiques dans la recherche sur l'efficacité comparative, nous avons généré des résultats contraires. Nos résultats suggèrent que certaines études observationnelles rétrospectives peuvent trouver qu'un traitement améliore les résultats pour les patients, tandis qu'une autre étude similaire peut trouver que ce n'est pas le cas, simplement sur la base de choix analytiques.

Dans le passé, en lisant un article de revue scientifique, si vous êtes comme moi, vous avez peut-être pensé que les résultats ou les conclusions concernaient uniquement les données. Maintenant, il semble que les résultats, ou si l'hypothèse initiale est confirmée ou infirmée, peuvent également dépendre de la méthode d'analyse.

Une autre étude trouvé des résultats similaires. L'article, De nombreux analystes, un seul ensemble de données : rendre transparent l'impact des variations dans les choix analytiques sur les résultats, décrit comment ils ont donné le même ensemble de données à 29 équipes différentes à analyser. L'analyse des données est souvent considérée comme un processus strict et bien défini qui mène à une seule conclusion.

Malgré les remontrances des méthodologistes, il est facile d'oublier que les résultats peuvent dépendre de la stratégie analytique choisie, elle-même imprégnée de théorie, d'hypothèses et de points de choix. Dans de nombreux cas, il existe de nombreuses approches raisonnables (et beaucoup déraisonnables) pour évaluer les données qui portent sur une question de recherche.

Les chercheurs ont collecté l'analyse des données et sont arrivés à la conclusion que toutes les recherches incluent des décisions subjectives - y compris le type d'analyse à utiliser - qui peuvent affecter le résultat final de l'étude.

La recommandation d'un autre chercheur qui a analysé l'étude ci-dessus doit être prudent lors de l'utilisation d'un seul document pour prendre des décisions ou tirer des conclusions.

Lutter contre les biais dans l'analytique

Ceci est simplement censé être un récit édifiant. La connaissance peut nous protéger contre les escroqueries. Plus nous sommes conscients des méthodes possibles qu'un scanner pourrait utiliser pour nous tromper, moins nous sommes susceptibles d'être dupés, disons, par, disons, la mauvaise direction d'un pickpocket ou le discours doux d'un jeu de Ponzi. Il en va de même pour la compréhension et la reconnaissance des biais potentiels qui affectent nos analyses. Si nous sommes conscients des influences potentielles, nous pourrons peut-être mieux présenter l'histoire et finalement prendre de meilleures décisions.