Analytics lögn

Analysens partiskhet

Mark Twain sa diskutabelt något i stil med: "Det finns tre typer av lögner: lögner, förbannade lögner och analytics. "

Vi tar för givet att analyser ger oss användbara, handlingsbara insikter. Vad vi ofta inte inser är hur våra egna och andras fördomar påverkar svaren vi får av även de mest sofistikerade mjukvaran och systemen. Ibland kan vi bli manipulerade på ett oärligt sätt, men, mer vanligt, kan det vara subtila och omedvetna fördomar som smyger sig in i vår analys. Motivationen bakom partisk analys är många. Ibland påverkas de opartiska resultat vi förväntar oss från vetenskapen av 1) subtila val i hur data presenteras, 2) inkonsekventa eller icke-representativa data, 3) hur AI-system tränas, 4) okunskapen, inkompetensen hos forskare eller andra som försöker att berätta historien, 5) själva analysen.

Presentationen är partisk

Vissa av lögnerna är lättare att upptäcka än andra. När du vet vad du ska leta efter kan du lättare upptäcka potentiellt vilseledande grafer och diagram.

Det finns åtminstone fem sätt att vilseledande visa data: 1) Visa en begränsad datamängd, 2). Visa orelaterade korrelationer, 3) Visa data felaktigt, 4) Visa data okonventionellt, eller 5). Visa data alltför förenklat.

Visa en begränsad datamängd

Att begränsa data eller välja en icke-slumpmässig del av data kan ofta berätta en historia som inte stämmer överens med helheten. Dålig provtagning, eller körsbärsplockning, är när analytikern använder ett icke-representativt urval för att representera en större grupp.

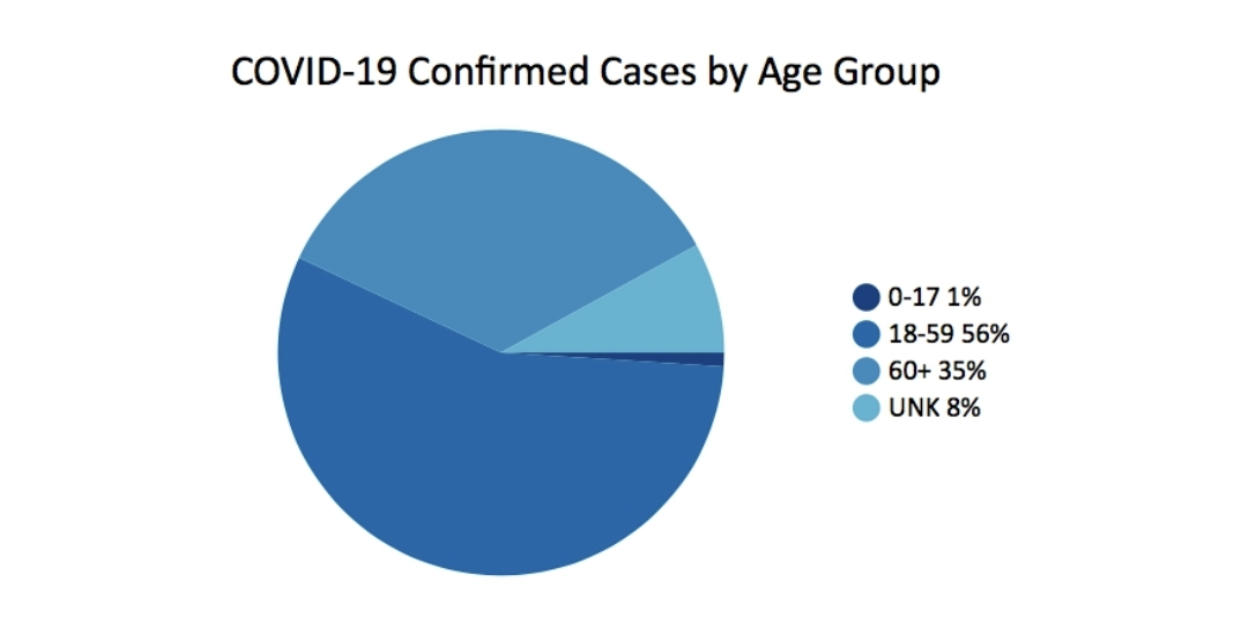

I mars 2020, Georgiens avdelning för folkhälsa publicerade detta diagram som en del av sin dagliga statusrapport. Det väcker faktiskt fler frågor än det besvarar.

En av de saker som saknas är sammanhang. Det skulle till exempel vara bra att veta hur stor procentandelen av befolkningen är för varje åldersgrupp. Ett annat problem med det enkla cirkeldiagrammet är de ojämna åldersgrupperna. 0-17 har 18 år, 18-59 har 42, 60+ är öppet, men har runt 40 år. Slutsatsen, endast givet detta diagram, är att majoriteten av fallen är i åldersgruppen 18-59 år. Åldersgruppen över 60 år ser ut att vara mindre allvarligt påverkad av covid-fall. Men det här är inte hela historien.

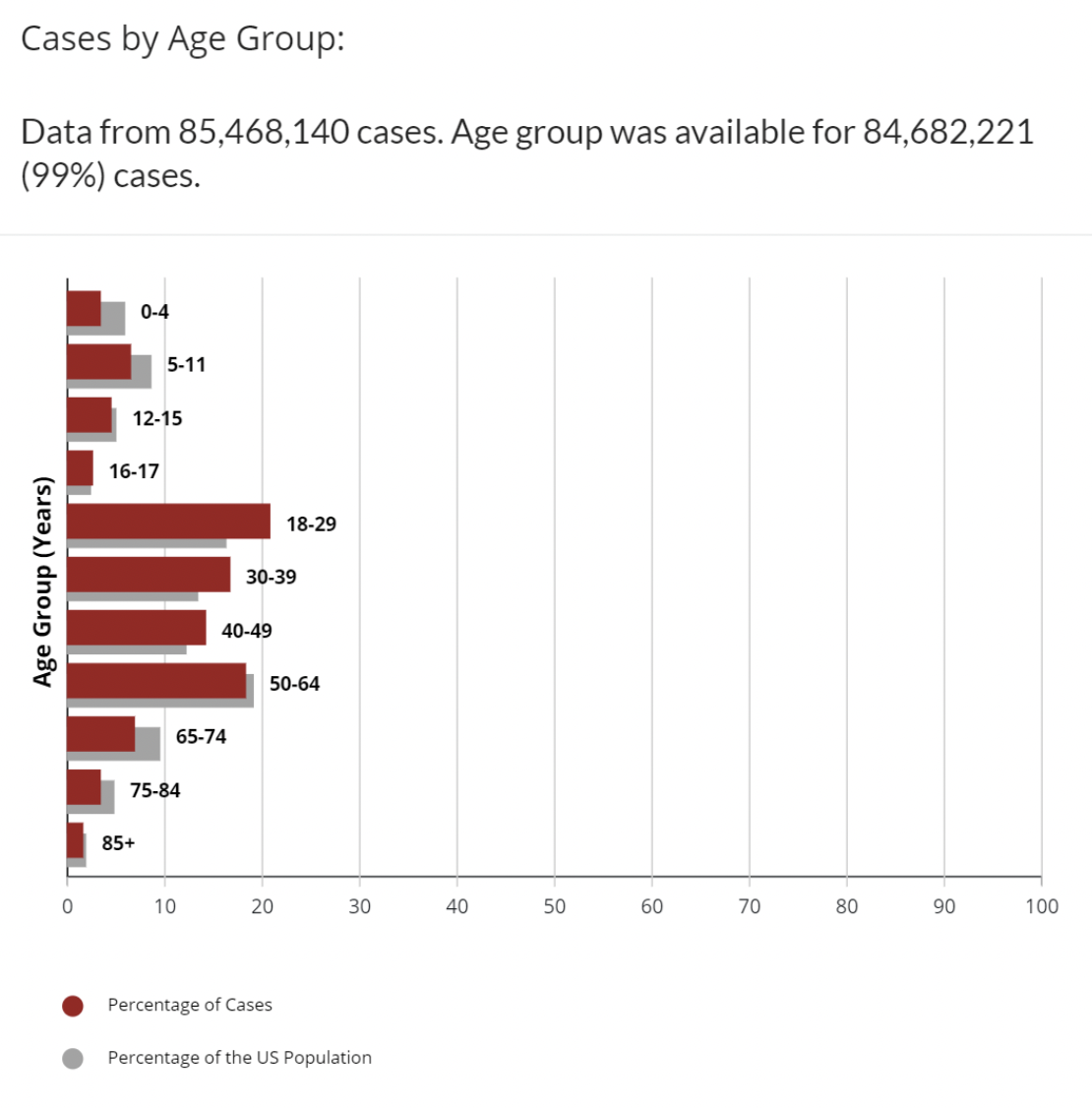

För jämförelse, denna olika datamängd på CDC:s webbplats kartlägger fall av covid efter åldersgrupp med ytterligare data om procentandelen av befolkningen i USA som finns i varje åldersintervall.

Detta är bättre. Vi har mer sammanhang. Vi kan se att åldersgrupperna 18-29, 30-39, 40-49 alla har en högre andel fall än andelen av åldersgruppen i befolkningen. Det finns fortfarande ojämna åldersgrupperingar. Varför är 16-17 en separat åldersgrupp? Ändå är detta inte hela historien, men förståsigpåare har skrivit kolumner, gjort förutsägelser och mandat om mindre än detta. Uppenbarligen, med covid, finns det många variabler förutom ålder som påverkar att räknas som ett positivt fall: vaccinationsstatus, tillgänglighet av tester, antal gånger som testats, samsjukligheter och många andra. Antalet fall ger i sig en ofullständig bild. De flesta experter tittar också på antalet dödsfall, eller procentandelen dödsfall per 100,000 XNUMX invånare, eller dödsfall för att titta på hur covid påverkar varje åldersgrupp.

Visa orelaterade korrelationer

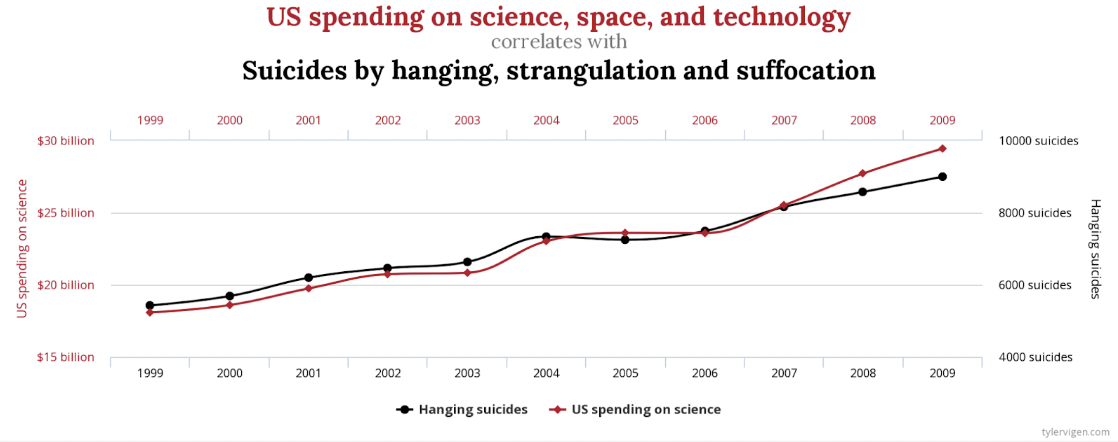

Uppenbarligen finns det en stark korrelation mellan USA:s utgifter för vetenskap, rymd och teknik och antalet självmord genom hängning, strypning och kvävning. Korrelationen är 99.79%, nästan en perfekt matchning.

Vem skulle dock hävda att dessa på något sätt är relaterade, eller att det ena orsakar det andra? Det finns andra mindre extrema exempel, men inte mindre falska. Det finns en liknande stark korrelation mellan Letters in Winning Word of Scripps National Spelling Bee och antalet människor som dödats av giftiga spindlar. Tillfällighet? Du bestämmer.

Ett annat sätt att kartlägga denna data som kan vara mindre missvisande skulle vara att inkludera noll på båda Y-axlarna.

Visa data felaktigt

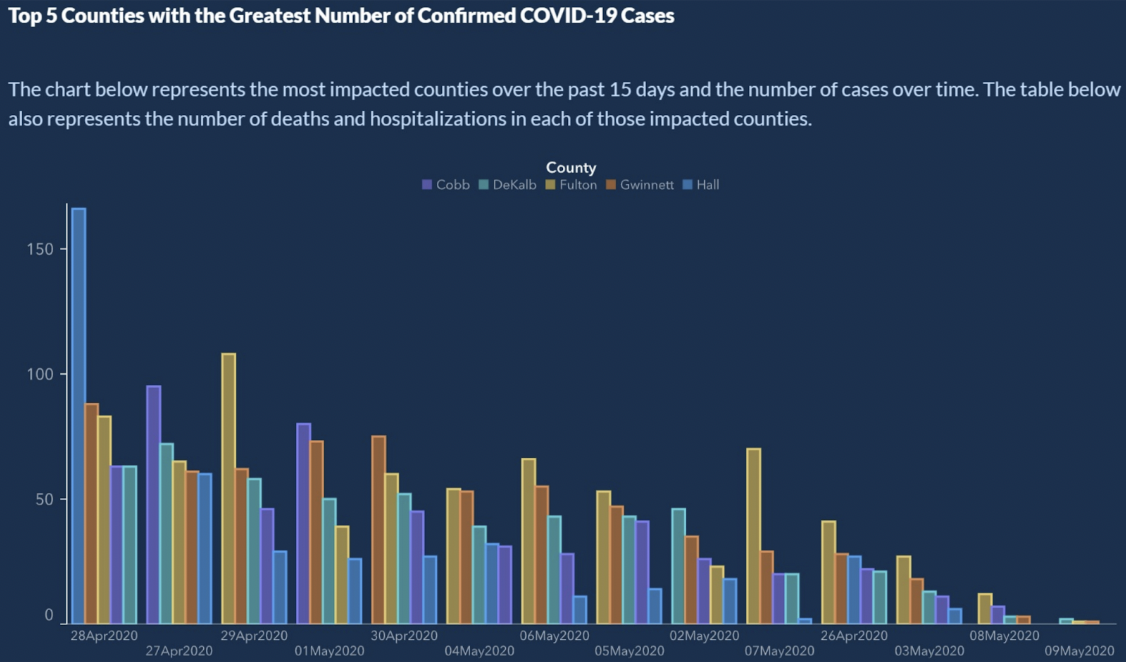

Från Hur man visar data dåligt, presenterade den amerikanska delstaten Georgia de fem bästa länen med det största antalet bekräftade fall av covid-5.

Ser legit ut, eller hur? Det finns helt klart en nedåtgående trend av bekräftade fall av covid-19. Kan du läsa X-axeln? X-axeln representerar tid. Typiskt kommer datum att öka från vänster till höger. Här ser vi en liten tidsresa på X-axeln:

4/28/2020

4/27/2020

4/29/2020

5/1/2020

4/30/2020

5/4/2020

5/6/2020

5/5/2020

5/2/22020 .

Vänta? Vad? X-axeln är inte sorterad kronologiskt. Så hur trevlig trenden än ser ut kan vi inte dra några slutsatser. Om datumen är beställda visar staplarna för antalet fall mer ett sågtandsmönster än någon form av trend.

Den enkla lösningen här är att sortera datumen som en kalender gör.

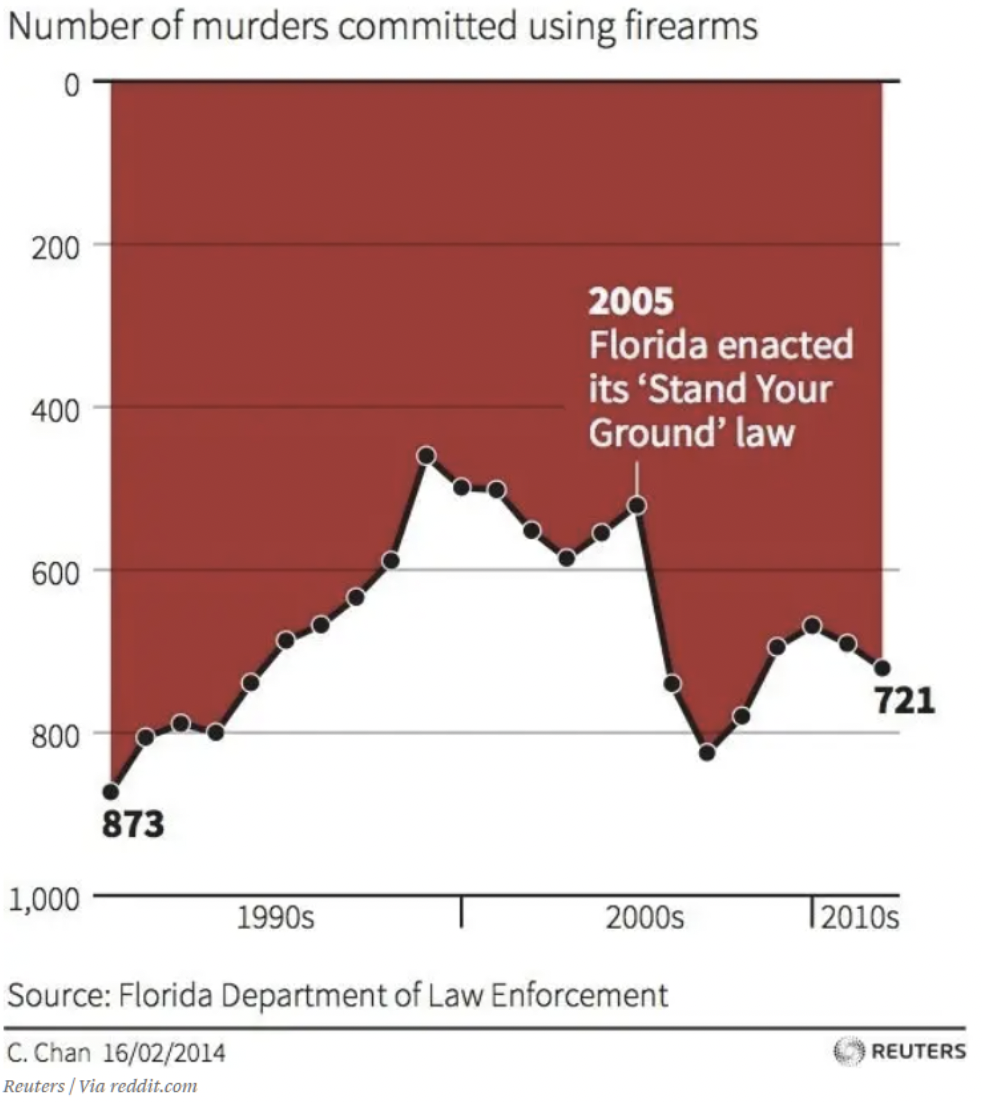

Visa data okonventionellt

Vi är alla upptagna. Våra hjärnor har lärt oss att göra snabba bedömningar baserade på antaganden som har varit konsekventa i vår värld. Till exempel, varje graf jag någonsin sett visar x- och y-axlarna som möter noll eller lägsta värden. Om du tittar på det här diagrammet kortfattat, vilka slutsatser kan du dra om effekten av Floridas ”Stå på din grundlag.”? Jag skäms över att erkänna det, men den här grafen lurade mig först. Ditt öga dras bekvämt till texten och pilen i mitten av grafiken. Ned är upp i denna graf. Det kanske inte är en lögn – uppgifterna är okej där. Men jag måste tro att det är meningen att lura. Om du inte har sett den än är noll på y-axeln överst. Så när datatrenderna minskar betyder det fler dödsfall. Detta diagram visar att antalet mord med skjutvapen ökat efter 2005, vilket indikeras av att trenden går ner.

Visa uppgifterna alltför förenklat

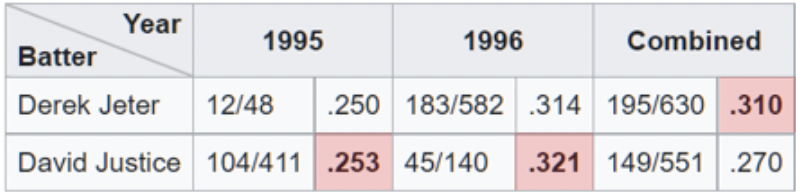

Ett exempel på överförenkling av data kan ses när analytiker drar fördel av Simpsons Paradox. Detta är ett fenomen som uppstår när aggregerad data verkar visa en annan slutsats än när den är uppdelad i delmängder. Denna fälla är lätt att falla i när man tittar på aggregerade procentsatser på hög nivå. En av de tydligaste illustrationerna av Simpsons Paradox på jobbet är relaterad till slagmedelvärden.

Här ser vi att Derek Jeter har ett högre total slagmedelvärde än David Justice för säsongerna 1995 och 1996. Paradoxen kommer in när vi inser att Justice överträffade Jeter i slaggenomsnitt båda dessa år. Om du tittar noga är det vettigt när du inser att Jeter hade ungefär 4x fler at-bats (nämnaren) 1996 till ett 007 lägre genomsnitt 1996. Medan Justice hade ungefär 10x antalet at-bats på bara . 003 högre genomsnitt 1995.

Presentationen verkar okomplicerad, men Simpsons paradox, medvetet eller omedvetet, har lett till felaktiga slutsatser. På senare tid har det funnits exempel på Simpsons paradox i nyheterna och på sociala medier relaterade till vacciner och dödlighet i covid. Ett diagrammet visar ett linjediagram som jämför dödstalen mellan vaccinerade och ovaccinerade för personer i åldern 10-59 år. Diagrammet visar att ovaccinerade konsekvent har en lägre dödlighet. Vad händer här?

Problemet liknar det vi ser med slaggenomsnitt. Nämnaren i detta fall är antalet individer i varje åldersgrupp. Grafen kombinerar grupper som har olika utfall. Om vi tittar på den äldre åldersgruppen, 50-59 år, separat ser vi att de vaccinerade klarar sig bättre. Likaså om vi tittar på 10-49 ser vi också att de vaccinerade klarar sig bättre. Paradoxalt nog, när man tittar på den kombinerade uppsättningen, verkar ovaccinerade ha ett sämre resultat. På så sätt kan du argumentera för motsatta argument med hjälp av data.

Uppgifterna är partiska

Data kan inte alltid litas på. Även inom forskarvärlden erkände över en tredjedel av de tillfrågade forskarna "tvivelaktiga forskningsmetoder." Annan forskningsbedrägeridetektiv säger, "Det är mycket troligt mycket mer bedrägeri i data – tabeller, linjediagram, sekvenseringsdata [– än vad vi faktiskt upptäcker]. Den som sitter vid sitt köksbord kan lägga in några siffror i ett kalkylblad och göra ett linjediagram som ser övertygande ut.”

Detta första exempel ser ut som att någon gjorde just det. Jag säger inte att detta är bedrägeri, men som en undersökning genererar det bara ingen data som bidrar till ett välgrundat beslut. Det ser ut som att undersökningen frågade de tillfrågade om deras åsikter om bensinstationskaffe eller någon annan relevant aktuell händelse.

- Superb

- Great

- Mycket bra

Jag har beskuren Twitter-inlägget för att ta bort referenser till den skyldige, men det här är hela diagrammet över slutresultaten av undersökningen. Sådana undersökningar är inte ovanliga. Uppenbarligen visar alla diagram som skapats från data från svaren att kaffet i fråga inte får missas.

Problemet är att om du hade fått den här undersökningen och inte hittade ett svar som passade ditt tänkande, skulle du hoppa över undersökningen. Detta kan vara ett extremt exempel på hur opålitlig data kan skapas. Dålig undersökningsdesign kan dock leda till färre svar och de som svarar har bara en åsikt, det är bara en fråga om grad. Uppgifterna är partiska.

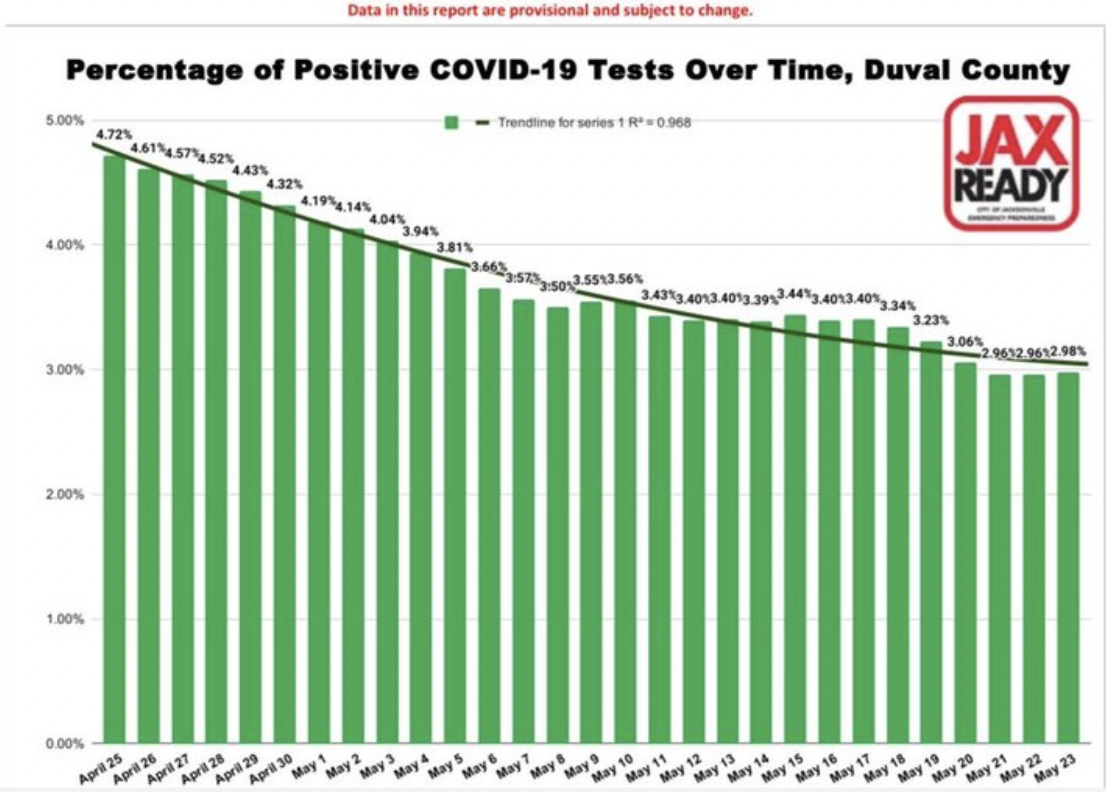

Detta andra exempel på databias är från filerna i "Värsta COVID 19 vilseledande grafer. "

Återigen, detta är subtilt och inte helt självklart. Stapeldiagrammet visar en jämn – nästan för jämn – minskning av andelen positiva COVID-19-fall över tid för ett län i Florida. Man skulle lätt kunna dra slutsatsen att fallen minskar. Det är bra, visualiseringen representerar data korrekt. Problemet ligger i datan. Så det är en mer lömsk fördom eftersom du inte kan se det. Det är inbakat i datan. Frågorna som du behöver ställa, inkluderar, vem testas? Med andra ord, vad är nämnaren, eller befolkningen som vi tittar på i procent. Antagandet är att det är hela populationen, eller åtminstone ett representativt urval.

Men under denna period, i detta län, gjordes tester endast för ett begränsat antal personer. De var tvungna att ha covid-liknande symtom, eller hade nyligen rest till ett land på listan över hot spots. Dessutom förvirrande resultaten är det faktum att varje positivt test räknades och varje negativt test räknades. Vanligtvis, när en individ testade positivt, skulle de testa igen när viruset hade sprungit ut och testade negativt. Så, på sätt och vis, för varje positivt fall finns det ett negativt testfall som tar bort det. De allra flesta tester är negativa och varje individs negativa tester räknades. Du kan se hur informationen är partisk och inte särskilt användbar för att fatta beslut.

AI-input och -utbildning är partisk

Det finns åtminstone två sätt på vilka AI kan leda till partiska resultat: att börja med partisk data, eller att använda partiska algoritmer för att bearbeta giltig data.

Partisk ingång

Många av oss är under intrycket av att AI kan lita på att den slår siffrorna, tillämpar dess algoritmer och spottar ut en tillförlitlig analys av data. Artificiell intelligens kan bara vara så smart som den är tränad. Om uppgifterna som den utbildas på är ofullkomliga, kommer resultaten eller slutsatserna inte heller att kunna litas på. I likhet med fallet ovan med undersökningsbias, finns det ett antal sätt på vilka data kan vara partisk i maskininlärning:.

- Urvalsbias – träningsdataset är inte representativt för hela populationen.

- Uteslutningsbias – ibland är det som verkar vara extremvärden faktiskt giltigt, eller där vi drar gränsen för vad som ska inkluderas (postnummer, datum, etc).

- Mätbias – konventionen är att alltid mäta från mitten och botten av menisken, till exempel vid mätning av vätskor i mätkolvar eller provrör (förutom kvicksilver.)

- Recall bias – när forskning beror på deltagarnas minne.

- Observerbias – forskare, som alla människor, är mer benägna att se vad de förväntar sig att se.

- Sexistisk och rasistisk partiskhet – kön eller ras kan vara över- eller underrepresenterad.

- Associationsbias – uppgifterna förstärker stereotyper

För att AI ska ge tillförlitliga resultat måste dess träningsdata representera den verkliga världen. Som vi har diskuterat i en tidigare bloggartikel är beredningen av data avgörande och som alla andra dataprojekt. Otillförlitliga data kan lära maskininlärningssystem fel läxa och kommer att resultera i fel slutsats. Som sagt, "All data är partisk. Detta är inte paranoia. Detta är fakta." – Dr Sanjiv M. Narayan, Stanford University School of Medicine.

Att använda partisk data för träning har lett till ett antal anmärkningsvärda AI-fel. (Exempel här. och här., forskning här...)

Partiska algoritmer

En algoritm är en uppsättning regler som accepterar en input och skapar output för att svara på ett affärsproblem. De är ofta väldefinierade beslutsträd. Algoritmer känns som svarta lådor. Ingen är säker på hur de fungerar, ofta, inte ens företag som använder dem. Åh, och de är ofta proprietära. Deras mystiska och komplexa natur är en av anledningarna till att partiska algoritmer är så lömska. .

Tänk på AI-algoritmer inom medicin, HR eller finans som tar hänsyn till ras. Om ras är en faktor kan algoritmen inte vara rasblind. Detta är inte teoretiskt. Problem som dessa har upptäckts i den verkliga världen med hjälp av AI anställa, åkdel, låneansökans, och njurtransplantationer.

Summan av kardemumman är att om dina data eller algoritmer är dåliga, är värre än värdelösa, kan de vara farliga. Det finns en sak som "algoritmisk granskning.” Målet är att hjälpa organisationer att identifiera potentiella risker relaterade till algoritmen när det gäller rättvisa, partiskhet och diskriminering. Någon annanstans, Facebook använder AI för att bekämpa fördomar i AI.

Människor är partiska

Vi har människor på båda sidor av ekvationen. Människor förbereder analysen och människor tar emot informationen. Det finns forskare och det finns läsare. I all kommunikation kan det uppstå problem i sändningen eller mottagningen.

Ta vädret till exempel. Vad betyder "risk för regn"? För det första, vad menar meteorologer när de säger att det finns en risk för regn? Enligt den amerikanska regeringen National Weather Service, en risk för regn, eller vad de kallar Probability of Precipitation (PoP), är ett av de minst förstådda elementen i en väderprognos. Den har en standarddefinition: "Sannolikheten för nederbörd är helt enkelt en statistisk sannolikhet på 0.01 tum [sic] av [sic] mer nederbörd vid ett givet område i det givna prognosområdet under den angivna tidsperioden." Det "givna området" är prognosområdet, eller broadgjutet område. Det betyder att den officiella sannolikheten för nederbörd beror på förtroendet för att det kommer att regna någonstans i området och procentandelen av området som kommer att bli blött. Med andra ord, om meteorologen är säker på att det kommer att regna i prognosområdet (Konfidens = 100%), så representerar PoP den del av området som kommer att få regn.

Parisgatan; Regnig dag, Gustave Caillebotte (1848-1894) Chicago Art Institute Public Domain

Risken för regn beror på både självförtroende och område. Jag visste inte det. Jag misstänker att andra inte vet det heller. Cirka 75 % av befolkningen förstår inte exakt hur PoP beräknas, eller vad det är tänkt att representera. Så, blir vi lurade, eller är detta ett problem med uppfattningen. Låt oss kalla det nederbördsuppfattning. Skyller vi på väderprognosmakaren? För att vara rättvis så finns det några förvirring även bland väderprognosmakare. I ett undersökning43% av de tillfrågade meteorologerna sa att det finns väldigt lite konsekvens i definitionen av PoP.

Själva analysen är partisk

Av de fem påverkande faktorerna kan analysen i sig vara den mest överraskande. I vetenskaplig forskning som resulterar i att en granskad artikel publiceras, antas vanligtvis en teori, metoder definieras för att testa hypotesen, data samlas in, sedan analyseras data. Vilken typ av analys som görs och hur den görs är underskattad i hur den påverkar slutsatserna. I en papper publicerad tidigare i år (januari 2022), i International Journal of Cancer, utvärderade författarna om resultaten av randomiserade kontrollerade studier och retrospektiva observationsstudier. Deras resultat drog slutsatsen att,

Genom att variera analytiska val i jämförande effektivitetsforskning genererade vi motsatta resultat. Våra resultat tyder på att vissa retrospektiva observationsstudier kan finna att en behandling förbättrar resultaten för patienter, medan en annan liknande studie kanske finner att den inte gör det, helt enkelt baserat på analytiska val.

Tidigare, när du läser en artikel i en vetenskaplig tidskrift, om du är som jag, kanske du har trott att resultaten eller slutsatserna enbart handlar om data. Nu verkar det som om resultaten, eller om den initiala hypotesen bekräftas eller vederläggs, också kan bero på analysmetoden.

Annan studera hittade liknande resultat. Artikeln, Många analytiker, en datauppsättning: Att göra transparent hur variationer i analytiska val påverkar resultaten, beskriver hur de gav samma datamängd till 29 olika team att analysera. Dataanalys ses ofta som en strikt, väldefinierad process som leder till en enda slutsats.

Trots metodologernas remonstrationer är det lätt att förbise det faktum att resultaten kan bero på den valda analytiska strategin, som i sig är genomsyrad av teorier, antaganden och valpunkter. I många fall finns det många rimliga (och många orimliga) metoder för att utvärdera data som har betydelse för en forskningsfråga.

Forskarna samlade in analysen av data och kom till slutsatsen att all forskning inkluderar subjektiva beslut – inklusive vilken typ av analys som ska användas – som kan påverka det slutliga resultatet av studien.

En annans rekommendation forskaren vem som analyserat ovanstående studie ska vara försiktig när man använder ett enda dokument för att fatta beslut eller dra slutsatser.

Ta itu med bias i Analytics

Detta är helt enkelt menat att vara en varnande berättelse. Kunskap kan skydda oss från att bli gripna av bedrägerier. Ju mer medveten om möjliga metoder en skanner kan använda för att lura oss, desto mindre sannolikt är det att vi blir tagna i, säg, av, säg, en ficktjuvs felriktning, eller det smidiga snacket om ett Ponzispel. Så är det med att förstå och känna igen potentiella fördomar som påverkar vår analys. Om vi är medvetna om potentiella influenser kanske vi kan presentera berättelsen bättre och i slutändan fatta bättre beslut.